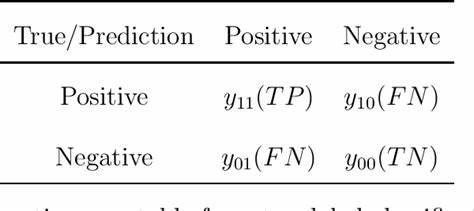

En el creciente mundo de la inteligencia artificial y los modelos de lenguaje a gran escala (LLM), la necesidad de evaluaciones rigurosas y realistas se ha convertido en un pilar fundamental para asegurar la calidad, coherencia y utilidad de las respuestas generadas por estas tecnologías. Tradicionalmente, la evaluación de los LLM se ha basado en métricas cuantitativas, como precisión, recall, BLEU, ROUGE o métricas similares que comparan fragmentos de texto o tokens generados con respuestas de referencia. Sin embargo, a medida que avanza la complejidad de las aplicaciones basadas en IA conversacional y la interacción con usuarios reales se vuelve primordial, surge un nuevo enfoque: las evaluaciones end-to-end (E2E) basadas en aserciones binarias. Este enfoque pone el foco en verificar de manera categórica si una respuesta cumple o no con lo esperado, disminuyendo la complejidad de la medición y facilitando la integración en sistemas de prueba automatizados y escalables. Las evaluaciones E2E en modelos de lenguaje representan una evolución significativa de las evaluaciones tradicionales porque consideran la conversación como una unidad completa en lugar de dividirla en pares de entrada y respuesta aislados.

Esto simula mucho mejor el comportamiento esperado en entornos reales, donde una respuesta debe tener sentido no solo en relación con la pregunta inmediata sino con todo el contexto previo. En este sentido, las aserciones binarias permiten afirmar con claridad si la respuesta generada es correcta o no, sustentando la validación en juicios concretos y específicos que eliminan ambigüedades. Este cambio tiene un impacto directo en la manera en que desarrolladores y equipos de IA diseñan, monitorean y mejoran sus agentes conversacionales. Al basarse en aserciones fáciles de interpretar (rechazar o aprobar), pueden implementarse testes automatizados más robustos, que no solo verifican si un modelo genera texto cohesivo, sino también que cumple con requisitos funcionales precisos, que pueden ir desde confirmar que el asistente hace una pregunta de seguimiento adecuada hasta validar que un conjunto determinado de herramientas o APIs se activaron correctamente durante una interacción. Un ejemplo típico de este enfoque puede encontrarse en frameworks modernos de evaluación que usan agentes simulados dentro de los escenarios de prueba.

En lugar de evaluar solo fragmentos estáticos, se simula un flujo conversacional completo, donde el agente debe cumplir con una serie de condiciones durante la interacción. A través de jueces automáticos que emplean inteligencia artificial, se evalúan criterios específicos mediante preguntas que se responden con un sí o no categórico, simplificando el movimiento de la evaluación hacia un paradigma pragmático y funcional. Esta técnica es especialmente poderosa porque no depende exclusivamente de comparaciones de texto sino que utiliza modelos de valoración inteligentes para determinar si un comportamiento o respuesta cumple con los estándares definidos. Por ejemplo, es posible hacer que un juez basado en un LLM evalúe si la respuesta incluye un seguimiento lógico a la pregunta del usuario, o si el agente invocó correctamente una función para obtener información actualizada. Al hacerlo, no se mide solo la calidad lingüística sino la lógica y utilidad práctica, que son aspectos clave para la implementación en aplicaciones reales.

Otra ventaja de centrarse en aserciones binarias para las evaluaciones E2E es su compatibilidad con las prácticas actuales de desarrollo de software que utilizan pruebas automatizadas y continuas. Los desarrolladores pueden integrar estos tests en pipelines de integración continua, permitiendo detectar rápidamente fallos, regresiones o comportamientos no deseados. De esta manera, se asegura que cada actualización o cambio en el modelo o en la lógica del agente mantenga una calidad mínima verificada a través de criterios simples y efectivos. Además, la capacidad para simular usuarios y escenarios completos amplía el alcance evaluativo. Más que medir solo respuestas estáticas, estas pruebas ponen a prueba la capacidad del modelo para lidiar con contextos dinámicos, preguntas sucesivas y distintos tonos o matices en la conversación.

Así, al comprobar que el agente responde correctamente a lo largo de distintas etapas o en presencia de múltiples mensajes, se garantiza que las funcionalidades esperadas se mantengan estables y útiles. La integración con herramientas como LangChain o SDKs de proveedores como Vercel facilita la creación de estos sistemas de evaluación, ya que ofrecen componentes reutilizables para agentes, jueces y simuladores de usuario. Esto permite montar entornos de evaluación rápidos y flexibles, donde se pueden definir distintos criterios según las necesidades del proyecto, y extender la funcionalidad fácilmente añadiendo nuevas aserciones o tipos de segmentación para simular escenarios específicos. Otro aspecto relevante es la transparencia y trazabilidad que promueven estas evaluaciones, facilitando la interpretación de resultados y la identificación de áreas problemáticas. Al tener resultados binarios, los reportes de test son claros y directos, facilitando la comunicación entre equipos técnicos y no técnicos.

Esto es esencial para la adopción de la inteligencia artificial en entornos empresariales donde la calidad y el cumplimiento de requisitos específicos determinan la viabilidad y confianza en las soluciones. Asimismo, el enfoque en aserciones binarias permite una mayor personalización y adaptación a casos de uso concretos. En lugar de depender de métricas generalistas que pueden no captar detalles importantes para una aplicación particular, se diseñan pruebas específicas que validan funcionalidades críticas, como la correcta interpretación de instrucciones, respuestas a consultas de soporte, cumplimiento de políticas éticas o el correcto uso de datos sensibles. Esto contribuye a una mejora continua dirigida y eficiente. El uso creciente de estas evaluaciones también se alinea con movimientos en la industria para mejorar la gobernanza y responsabilidad en el uso de modelos de lenguaje, permitiendo validar automáticamente que el comportamiento del agente está alineado con estándares éticos, de privacidad y seguridad implementados.

Finalmente, el desarrollo y la adopción de estas prácticas están marcando una nueva tendencia en la creación y mantenimiento de agentes conversacionales, chatbots y asistentes virtuales. La combinación de evaluaciones robustas, automatizadas y centradas en resultados categóricos asegura no solo la calidad técnica sino también la experiencia del usuario final, fundamento imprescindible para la aceptación masiva de estas tecnologías. En conclusión, las evaluaciones E2E para modelos de lenguaje basadas en aserciones binarias representan una evolución trascendental en la forma en que se mide y garantiza la calidad de la generación de lenguaje natural. Al centrarse en conversaciones completas y en pruebas pragmáticas que reflejan escenarios reales, ofrecen una alternativa clara, efectiva y escalable frente a las métricas tradicionales. Este enfoque no solo mejora la confianza en los modelos y agentes implementados, sino que también facilita su integración en procesos de desarrollo modernos que demandan precisión, trazabilidad y control en entornos complejos y dinámicos.

La comunidad tecnológica y los desarrolladores de IA están viendo en estas evaluaciones una herramienta clave para construir aplicaciones conversacionales más útiles, confiables y adaptadas a necesidades concretas, asegurando así un futuro sólido y responsable para la inteligencia artificial aplicada al lenguaje.