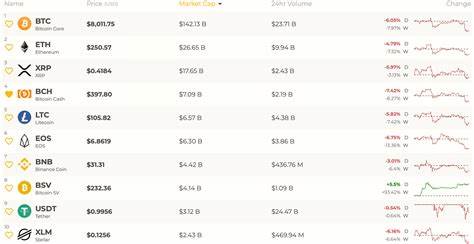

En el dinámico mundo digital actual, donde la inteligencia artificial (IA) ha irrumpido con fuerza transformando múltiples ámbitos, el periodismo y la búsqueda de información no son la excepción. Los motores de búsqueda basados en IA prometen ofrecer respuestas rápidas y precisas a los usuarios, pero un estudio reciente realizado por el Centro Tow de Periodismo Digital en la Universidad de Columbia pone bajo lupa la confiabilidad de estas herramientas. Según el análisis, más del 60% de las citas suministradas por estos motores presentan fallas, un porcentaje alarmante que pone en entredicho la utilidad y precisión de la información presentada por estas plataformas. El estudio, titulado «La búsqueda de IA tiene un problema de citación», fue llevado a cabo por Klaudia Jaźwińska y Aisvarya Chandrasekar y consistió en la realización de 200 pruebas empleando ocho motores de búsqueda IA diferentes. Entre ellos, destacan ChatGPT Search, Perplexity, Gemini y diversas versiones de Grok Search.

Se les proporcionaron fragmentos de artículos y se les solicitó que generaran la cita completa, incluyendo el título del artículo, fecha de publicación, nombre del medio y la URL correspondiente. El resultado fue revelador: en más de la mitad de los casos las citas no coincidían con la fuente original o eran directamente incorrectas. Este hallazgo confirma una preocupación que había estado circulando en la comunidad de usuarios y especialistas en IA desde hace tiempo. La aparición de noticias falsas, URLs inexistentes o erróneas y referencias imprecisas afecta críticamente a la credibilidad que los lectores pueden otorgar a las respuestas entregadas por estas tecnologías. Uno de los ejemplos más destacados ofrecidos por los investigadores es que ChatGPT frecuentemente genera URLs falsas, incluso refiriéndose a colaboradores editoriales de OpenAI, la propia organización detrás de ChatGPT.

Tales fallas no solo ponen en riesgo la confianza del usuario, sino que afectan la economía de los medios al reducir el tráfico dirigido hacia ellos. Dentro del conjunto evaluado, Perplexity demostró ser el motor de búsqueda con mejor desempeño relativo, fallando en torno a un 37% de las ocasiones, cifra que todavía es elevada si se considera el estándar que se espera para cualquier herramienta de información. En contraste, Grok-3 Search, un servicio de suscripción disponible para usuarios de X Premium+, presentó un índice de error extraordinariamente alto del 94%, superando incluso a la versión gratuita Grok-2. Este dato expone la paradoja de que no siempre pagar por un servicio ofrece mejor precisión o resultados de mayor calidad. Un problema adicional expuesto por el informe es la confianza excesiva con que muchos motores de búsqueda de IA emiten sus respuestas incorrectas.

En numerosos casos, estas herramientas no solo fallan en la cita, sino que lo hacen con un lenguaje seguro y sin señales que indiquen incertidumbre o posibilidad de error. Esta «confianza ciega» puede confundir a los usuarios, quienes podrían dar por válida la información sin verificarla, fomentando así la propagación de datos falsos o erróneos en internet. Otros motores, como Copilot, se distinguen por un comportamiento más cauteloso, ya que se negaron a responder a la mayoría de las preguntas cuando no contaban con certeza de la información. Sin embargo, esta actitud es la excepción y no la regla en el ecosistema actual de motores IA. La calidad de las URLs generadas por los motores también evidenció problemas.

Geminis y Grok-3 sobresalieron negativamente, generando más enlaces fabricados que válidos. Grok-3, por ejemplo, remitió a páginas de error 404 en 154 ocasiones durante las pruebas, un claro indicador de que no existe un trabajo riguroso de verificación ni actualización de los enlaces compartidos. Este escenario resulta especialmente preocupante porque el tráfico generado por motores de búsqueda IA hacia sitios de noticias es considerablemente bajo en comparación con motores tradicionales como Google. Un estudio reciente llevado a cabo por TollBit, empresa que ofrece soluciones para monetizar la reutilización de contenidos por parte de IA, concluyó que el tráfico referido por chatbots es hasta un 96% menor que el impulsado por búsquedas convencionales. A su vez, proyectos académicos como ‘Generative AI in the Newsroom’ de la Universidad Northwestern han revelado que sitios de noticias reciben apenas un minúsculo porcentaje del tráfico generado por estas plataformas, reforzando la idea de que la IA no está cumpliendo su papel esperado como generadora de audiencia para los medios.

Frente a este panorama, es importante reflexionar sobre el papel que juegan los motores de búsqueda basados en inteligencia artificial en el ecosistema informativo. Si por un lado facilitan el acceso acelerado a datos y respuestas, por otro deben garantizar la exactitud de la información que ofrecen, especialmente cuando se trata de fuentes periodísticas que involucran trabajo editorial, verificación de hechos y responsabilidad social. El desafío para las empresas responsables del desarrollo de estas tecnologías será corregir estas deficiencias de forma sistemática. La implementación de mecanismos robustos de verificación, la transparencia en cuanto a la confianza de las respuestas y mejor integración con bases de datos confiables podrían ser vías para aumentar la precisión de las citas. Asimismo, el compromiso con la integridad periodística no solo ayudará a mejorar la experiencia del usuario, sino que también favorecerá una relación más sostenible y equilibrada entre las plataformas IA y los creadores de contenido.

En definitiva, el informe del Centro Tow es una llamada de atención sobre los riesgos asociados al uso indiscriminado y sin mayor supervisión de los motores IA en la búsqueda de información. Habitualmente se habla de la inteligencia artificial como una herramienta revolucionaria y positiva, pero para que ello sea cierto será necesario enfrentar los problemas actuales y trabajar en soluciones que protejan la calidad y la veracidad del contenido digital. Para los usuarios, esta advertencia también implica la necesidad de mantener una mirada crítica y prudente al usar respuestas generadas por IA. La verificación de fuentes y la consulta directa de medios reconocidos deben seguir siendo parte insoslayable de cualquier investigación o búsqueda de datos relevantes. Finalmente, el futuro de la búsqueda de información asistida por inteligencia artificial dependerá en gran medida de la capacidad del sector tecnológico y periodístico para cooperar en la mejora continua de estas herramientas.

Sólo con una actitud colaborativa y consciente se podrá lograr ofrecer respuestas fiables que contribuyan a un entorno informativo sano, ético y funcional en beneficio de la sociedad.