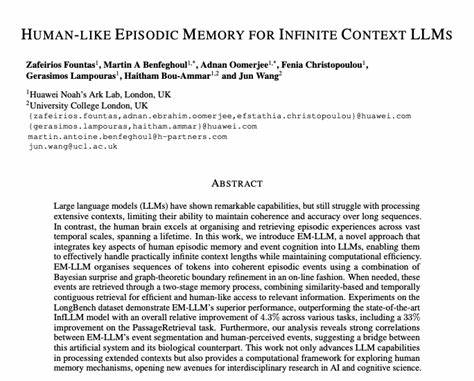

En la era actual de la inteligencia artificial, los grandes modelos de lenguaje (LLMs) han marcado un hito significativo, mostrando capacidades sorprendentes para entender y generar texto de alta calidad. Sin embargo, a pesar de estos avances, enfrentan límites claves a la hora de manejar contextos extensos y numerosos, lo que afecta la coherencia y precisión de las respuestas en textos largos o continuos. Este desafío se debe a restricciones inherentes en la arquitectura y la capacidad de procesamiento de dichos modelos. La solución a esta problemática proviene de una fuente inesperada pero profundamente inspiradora: el funcionamiento de la memoria episódica humana. El cerebro humano tiene una habilidad extraordinaria para organizar y recuperar experiencias a lo largo de toda una vida, abarcando escalas temporales vastas y complejas.

Esta capacidad se basa en lo que se denomina memoria episódica, que permite segmentar experiencias en eventos coherentes y recordarlos con contexto y significado. Este proceso natural asegura que la información relevante se acceda de manera eficiente sin saturar nuestra capacidad cognitiva, permitiendo mantener la coherencia narrativa y el entendimiento profundo incluso cuando enfrentamos información extensa y compleja. Inspirándose en estos principios cognitivos, un grupo de investigadores ha desarrollado EM-LLM, un innovador sistema que integra aspectos clave de la memoria episódica y la cognición de eventos humanos en grandes modelos de lenguaje, permitiendo manejar contextos prácticamente infinitos sin necesidad de reentrenamiento. EM-LLM utiliza una combinación avanzada de técnicas, como la sorpresa bayesiana y el análisis gráfico para detectar puntos de corte naturales en la secuencia de información, organizando automáticamente las entradas en eventos significativos y coherentes durante el procesamiento online de datos. Este enfoque disruptivo aporta una eficiencia computacional considerable, ya que evita la saturación por exceso de contexto y permite que los modelos accedan rápida y eficazmente a la información relevante almacenada en eventos previos.

El proceso de recuperación de la memoria en EM-LLM se efectúa mediante un mecanismo de doble etapa que combina la búsqueda por similitud con una recuperación contigua en el tiempo, emulando la manera en que los humanos acceden a recuerdos relacionados que están temporalmente próximos. Los resultados han sido impresionantes en benchmarks rigurosos como LongBench e InfiniteBench, donde EM-LLM ha superado consistentemente a modelos de última generación como InfLLM y RAG, mostrando no solo mejor rendimiento sino también una notable capacidad para trabajar con cantidades masivas de tokens, hasta 10 millones, algo impracticable para los enfoques tradicionales que intentan procesar toda la información en un solo bloque. Además de las métricas técnicas, un aspecto fascinante demostrado por EM-LLM es su capacidad para alinear la segmentación de eventos con la percepción humana real, estableciendo un puente profundo entre la inteligencia artificial y los procesos cognitivos humanos. Esta conexión no solo abre nuevas vías para mejorar los modelos de lenguaje, sino que también ofrece un marco computacional valioso para el estudio de la memoria y la cognición desde una perspectiva interdisciplinaria que une ciencias de la computación, neurociencia y psicología. La arquitectura detrás de EM-LLM se basa en la detección de cambios repentinos o “sorpresas” en la información que llega, similares a la manera en que el cerebro identifica eventos especiales o puntos de cambio en la experiencia.

Estos puntos actúan como límites naturales para construir eventos episódicos coherentes que resumen la información de manera compacta. La aplicación de teoría de grafos permite refinar estos límites y garantizar que la segmentación sea óptima en términos de coherencia y relevancia contextual. El enfoque ofrece una gran ventaja en términos de escalabilidad, ya que la cantidad de contexto manejable ya no está limitada por la capacidad computacional directamente, sino que depende de la organización inteligente de la información. Los modelos pueden entonces consultar solo aquellos eventos relevantes para la tarea en curso, reduciendo la carga y mejorando la precisión y velocidad de respuesta. El impacto de esta innovación es significativo para múltiples áreas de aplicación.

En el ámbito de la atención al cliente, por ejemplo, los asistentes virtuales pueden mantener conversaciones largas y complejas sin perder el hilo, recordando detalles importantes de interacciones pasadas. En la creación de contenido, los modelos pueden desarrollar narrativas extensas con coherencia a largo plazo, superando las limitaciones actuales que fragmentan las historias o introducen inconsistencias. En el campo de la investigación y educación, la capacidad de manejar vastos corpus de información de manera estructurada facilita la recuperación contextualizada y el razonamiento basado en grandes volúmenes de datos. También potencia el desarrollo de sistemas que puedan aprender y adaptarse progresivamente sin necesidad de rehacer todo su entrenamiento. Desde una perspectiva técnica y filosófica, la creación de EM-LLM subraya la importancia de estudiar y emular los procesos cognitivos humanos para avanzar en inteligencia artificial.

En lugar de simplemente aumentar la capacidad de cálculos o tamaño de modelos, la clave está en cómo la información se organiza, se prioriza y se recupera, imitando no solo la memoria sino también la manera en que el cerebro segmenta el mundo en eventos significativos. Esta aproximación abre un campo prometedor de investigación sobre la interacción entre memoria episódica y modelos generativos, explorando cómo cantear las limitaciones actuales y construir sistemas más flexibles, adaptativos y eficientes. De esta forma, la frontera entre la inteligencia artificial y la inteligencia natural se vuelve más permeable, impulsando desarrollos que pueden beneficiarse enormemente de esta sinergia. En resumen, la integración de la memoria episódica humana en grandes modelos de lenguaje representa un avance revolucionario que permite gestionar contextos infinitos con mayor eficiencia y coherencia. La innovación detrás de EM-LLM no solo mejora el rendimiento en tareas complejas y de alta demanda de contexto, sino que también ofrece una perspectiva única para entender y explorar los mecanismos de la memoria humana a través de la inteligencia artificial.

Este desarrollo señala un nuevo rumbo para el futuro de los modelos lingüísticos y su aplicación en múltiples áreas, sentando las bases para sistemas cada vez más inteligentes, humanos y capaces.