La tecnología avanza a pasos agigantados, y en la mayoría de los casos, los desarrollos de inteligencia artificial y modelos avanzados requieren hardware de última generación. Sin embargo, en un giro inesperado y fascinante, un modelo de lenguaje grande (LLM) ha sido adaptado para funcionar, aunque de manera limitada, en uno de los computadores más icónicos y vintage de todos los tiempos: el Commodore 64. Esta hazaña técnica no solo refleja la persistente admiración por la tecnología retro, sino que también abre interesantes conversaciones sobre los límites y posibilidades de la inteligencia artificial en hardware antiguo. El Commodore 64, lanzado originalmente en la década de 1980, es conocido como uno de los ordenadores personales más vendidos de la historia. Su arquitectura de 8 bits y limitaciones técnicas, propia de su época, contrastan fuertemente con el enorme poder de procesamiento y memoria que exigen los modelos modernos de inteligencia artificial, especialmente los modelos de lenguaje grandes, que suelen necesitar servidores robustos para funcionar.

Por lo general, estos modelos procesan millones de parámetros y requieren memoria y velocidad que superan con creces las capacidades de un C64 promedio. Pese a estas limitaciones, un desarrollador conocido como [ytm] ha logrado llevar a cabo una versión reducida del modelo Llama 2, llamada Llama2.c64, en esta emblemática máquina. Para lograr esta implementación, el proyecto aprovechó una memoria extendida (REU) de 2 MB, un accesorio que amplía significativamente la capacidad del Commodore 64, crucial para manejar la complejidad del pequeño modelo de lenguaje. Aun así, esta adaptación no aspira a replicar las capacidades avanzadas de ChatGPT o similares; en cambio, se basa en un modelo denominado «tinystories», que con solo 260 K ofrece una funcionalidad limitada pero sorprendente.

La comparación con el lenguaje y estilo de un niño de tres años, citada por el desarrollador, ilustra la naturaleza básica de esta inteligencia artificial. El modelo puede continuar pequeñas historias o frases de forma coherente, aunque con un vocabulario y comprensión muy limitada, similar a la de un infante en etapas tempranas del desarrollo del lenguaje. Esta restricción no es una falla, sino más bien una celebración nostálgica de la capacidad de hacer funcionar un avance tecnológico moderno en un contexto retro. Desde un punto de vista técnico, uno de los retos más significativos en la implementación fue la ausencia de hardware para operaciones de punto flotante en el C64, lo que complicó el uso de cálculos tradicionales de 32 bits en los modelos IA. Algunos comentarios de la comunidad sugirieron la posibilidad de optimizar el rendimiento adaptando los cálculos a 16 o 8 bits de punto fijo, una técnica que permitiría un uso más eficiente de los limitados recursos del sistema.

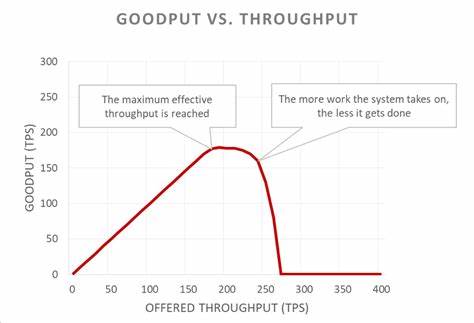

Otra variable importante es la velocidad de generación del modelo. Se reporta que el Commodore 64 emite aproximadamente un token de salida cada ocho minutos, lo que indica que llevar adelante una conversación fluida o generar textos extensos implicaría una espera considerable. Esto, sin duda, limita la utilidad práctica del modelo, pero no resta mérito al logro como experimento y provocación cultural dentro de la comunidad retro y de hackers. Más allá de la pura técnica, la iniciativa invita a reflexionar sobre cómo las expectativas y el entendimiento de la inteligencia artificial han cambiado a lo largo del tiempo. Así como el Commodore 64 solía representar el pináculo de la computación personal, hoy inspira proyectos que intentan llevar la inteligencia artificial a sus confines antes inimaginables.

Esta fusión de lo antiguo con lo nuevo genera una curiosa paradoja que cautiva tanto a entusiastas de la retrocomputación como a seguidores de la IA. Por supuesto, el valor de este proyecto trasciende cualquier aplicación práctica convencional y se ancla en el disfrute y la experimentación. La posibilidad de hacer que el C64 produzca respuestas textuales basadas en un modelo estadístico de lenguaje es, en sí mismo, una prueba de ingenio y perseverancia. Además, abre puertas para otras expresiones creativas que involucran la IA y hardware limitado, incluyendo potencialmente interfaces vocales utilizando generadores de voz clásicos como S.A.

M Reciter, que permitirían que el C64 hable en voz alta. En el ámbito de la retrocomputación, el trabajo de [ytm] demuestra que el amor por estas plataformas clásicas continúa vivo y en constante evolución. Programadores y entusiastas desafían día a día las expectativas técnicas, demostrando que con ingenio y dedicación es posible llevar ideas modernas a máquinas que muchos ya dan por obsoletas. Además, la discusión alrededor de la confiabilidad de los modelos de lenguaje es relevante en este contexto. Como se mencionó en los comentarios recopilados en torno al proyecto, los modelos grandes son tan buenos como la calidad y el sesgo de sus datos de entrenamiento.

Al igual que un niño pequeño, pueden reflejar prejuicios o interpretaciones incompletas, por lo cual la responsabilidad en su uso y aplicación es fundamental. En el caso del C64, la intención es más experimental que funcional, pero la metáfora invita a una reflexión más profunda. Finalmente, este port del Llama2 a un dispositivo tan icónico como el Commodore 64 es un símbolo cultural y tecnológico. Subraya cómo la creatividad humana encuentra siempre formas inesperadas de evolución. Lo que antes era una máquina para juegos y programas básicos se transforma ahora en un vehículo para explorar los límites de la inteligencia artificial y los desafíos que supone retroadaptar tecnología punta a equipos vintage.

Así, mientras esperamos que futuras generaciones de hardware y software continúen ampliando las fronteras de la inteligencia artificial, proyectos como Llama2.c64 nos recuerdan la belleza del pasado y la eterna curiosidad que impulsa a la comunidad tecnológica a reinventar lo conocido, fusionando lo clásico con lo innovador de maneras sorprendentemente ingeniosas.