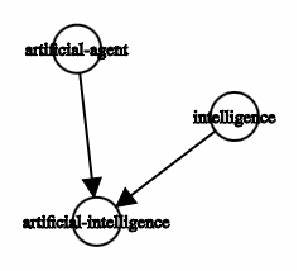

La inteligencia artificial (IA) se ha consolidado como una de las áreas más dinámicas e innovadoras de la tecnología contemporánea. Sin embargo, a medida que los sistemas de inteligencia artificial y aprendizaje automático (IA/ML) se vuelven más complejos, también crece la necesidad de adoptar buenas prácticas de ingeniería de software para mantener la calidad, modularidad y facilidad de mantenimiento de tales proyectos. En este contexto, la inyección de dependencias (Dependency Injection o DI) emerge como una práctica fundamental para lograr arquitecturas limpias y altamente testeables en el desarrollo de IA. La inyección de dependencias es, en esencia, una técnica que consiste en definir explícitamente las dependencias de una clase o función a través de sus parámetros o constructor, en lugar de crear esas dependencias internamente o depender de variables globales. Este principio está estrechamente relacionado con la inversión de control, y se ha popularizado bajo varios nombres, incluyendo el llamado “Principio de Hollywood”: “No nos llames, nosotros te llamamos”.

Esta máxima refleja la idea de que el control del flujo de dependencias debe estar en manos externas, otorgando mayor flexibilidad y modularidad al código. En el desarrollo tradicional de software, la inyección de dependencias ha sido ampliamente adoptada debido a su capacidad para separar claramente las responsabilidades y facilitar las pruebas unitarias. Sorprendentemente, en el ámbito de la inteligencia artificial, especialmente en proyectos de aprendizaje automático, esta técnica no siempre ha sido utilizada con la misma perseverancia. En parte, esto se debe a la percepción de que los sistemas de IA/ML son inherentemente complejos y únicos, lo que ha llevado a muchos desarrolladores a aceptar soluciones menos estructuradas y a no aplicar rigurosamente buenas prácticas de ingeniería. Sin embargo, esto está cambiando rápidamente.

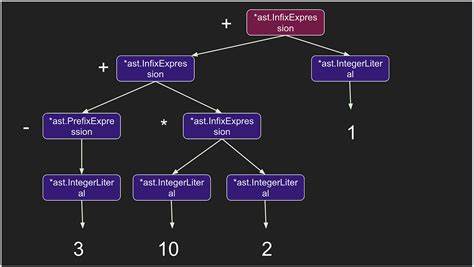

El auge de lenguajes modernos como Python, junto con herramientas como dataclasses y sistemas de tipado estático como mypy, han facilitado enormemente la incorporación de DI en código para IA. Además, la integración de inteligencia artificial con asistencia de programación automatizada permite generar el código base que implementa estos patrones, reduciendo el esfuerzo manual e incentivando mejores prácticas. Un ejemplo ilustrativo de cómo se aplica la inyección de dependencias en IA es la implementación de un ciclo de entrenamiento para un modelo de aprendizaje automático. En este contexto, las dependencias principales incluyen la arquitectura del modelo, los datos de entrenamiento y, frecuentemente, las herramientas para el registro y monitoreo de métricas, como WandB. La inyección de dependencias sugiere que, en lugar de que la clase encargada del entrenamiento cree o acceda directamente a estas dependencias, éstas deben ser pasadas como parámetros durante su construcción.

Esto genera un código que no depende de implementaciones concretas y puede ser probado fácilmente con objetos simulados o nulos que cumplen las mismas interfaces. El beneficio que aporta esta técnica a las pruebas unitarias es inestimable. En un escenario tradicional, un desarrollador que quiera probar la función de entrenamiento debe lidiar con complejidades como la carga de datos reales desde disco o la interacción con servicios externos. Al utilizar DI, se pueden pasar datos simulados o listas en memoria directamente al objeto entrenador, evitando complicaciones y aumentando la velocidad y confiabilidad de los tests. Además, la inyección de dependencias permite que los componentes del sistema se desarrollen y evolucionen de forma independiente.

Por ejemplo, un investigador puede trabajar en la mejora de la arquitectura del modelo sin preocuparse por los cambios en la gestión de datos o el registro de métricas. Así mismo, otro integrante del equipo puede modificar o reemplazar el sistema de registro sin afectar la lógica interna del ciclo de entrenamiento. La modularidad y claridad que ofrece DI se extienden también a la configuración y construcción de objetos con múltiples dependencias. Al organizar estos parámetros en objetos de configuración, preferiblemente utilizando dataclasses, es posible distinguir claramente entre elementos esenciales, como la tasa de aprendizaje o la ruta del dataset, y dependencias incidentales, como el tamaño de la imagen. Esta división facilita el mantenimiento y la comprensión del sistema, además de evitar la infección del código con múltiples capas arbitrarias y confusas de configuración que suelen dificultar la tarea de saber qué valores se están usando efectivamente.

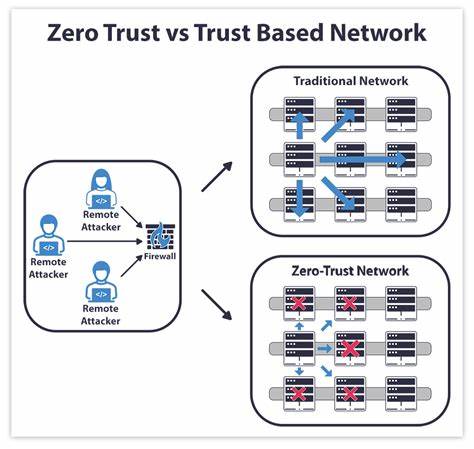

Por ejemplo, un objeto de configuración para datos puede aceptar parámetros esenciales proporcionados por el usuario, mientras que ciertos atributos, como la forma de entrada para un modelo, se calculan internamente y se pasan a otros objetos de configuración, reflejando la dependencia real entre un componente y otro. Este enfoque refuerza una clara separación de responsabilidades y favorece un desarrollo más ordenado y coherente. Es importante también tener en cuenta lo que debe evitarse para no caer en malas prácticas contraproducentes. Entre los anti-patrones comunes están los ejemplos de dependencias codificadas de forma rígida dentro de las clases, estados globales compartidos y el uso excesivo o inadecuado de métodos de fábrica. La codificación rígida, como instanciar directamente una arquitectura específica o cargar datos desde un archivo con una ruta fija dentro del constructor, hace que el código sea inflexible y difícil de probar.

Los estados globales, a su vez, son otra fuente de problemas, porque la dependencia queda implícita y no declarada, lo que genera dificultad para entender el flujo y hace que las pruebas unitarias sean complejas o imposibles de ejecutar de forma aislada. Finalmente, los métodos de fábrica excesivos o que encapsulan lógica innecesaria terminan complicando la estructura del código y limitan la posibilidad de sustituir componentes durante pruebas o cambios en el diseño. Un principio fundamental relacionado con la inyección de dependencias es priorizar la composición sobre la herencia para lograr flexibilidad y legibilidad. En lugar de crear jerarquías complejas de clases donde los métodos auxiliares están escondidos en superclases y subclases deben heredar métodos que no utilizan, es mejor desacoplar estas funciones y pasarlas explícitamente como dependencias. Esto permite modificar o intercambiar comportamientos sin necesidad de alterar clases base o crear múltiples subtipos.

Por ejemplo, en un escenario donde se calculan métricas distintas según el tipo de problema, en vez de obligar a distintas clases a sobreescribir un método común, es preferible recibir una función de cálculo de métricas como una dependencia inyectada. Así, el entrenador no se preocupa por cuál métrica se usa, solo sabe que la función es llamada apropiadamente. Esto mejora la legibilidad, facilita pruebas con funciones simuladas y simplifica el mantenimiento del código. La adopción de la inyección de dependencias en proyectos de inteligencia artificial no solo ayuda a mantener limpio el código, sino que también impulsa una cultura de ingeniería más profesional dentro de un campo que a veces ha estado marcado por su origen académico. Muchas soluciones en IA/ML han sido creadas por investigadores centrados en la innovación científica, más que en la robustez del software.

Sin embargo, para escalar, desplegar y mantener estos sistemas en escenarios reales, aplicar buenas prácticas de ingeniería, como DI, resulta crucial. Además, la mejora en la modularidad obtenida con DI facilita la colaboración interdisciplinaria. Por ejemplo, ingenieros especializados en infraestructura pueden encargarse de la gestión eficiente de datos o el monitoreo sin interferir en los detalles del modelo, mientras que científicos de datos se concentran en optimizar algoritmos o arquitecturas. Esto también favorece la integración con nuevas herramientas y frameworks sin necesidad de reescribir grandes partes del código. En resumen, la inyección de dependencias es mucho más que una simple técnica; es un paradigma que impulsa la calidad y sostenibilidad del desarrollo en inteligencia artificial.