Google Lens se ha convertido rápidamente en una herramienta revolucionaria para la búsqueda visual, permitiendo a los usuarios interactuar con el mundo a través de imágenes y texto de maneras antes inimaginables. Desde su lanzamiento, ha sido un referente en la integración de la inteligencia artificial con la experiencia cotidiana del usuario, facilitando la traducción de textos, la identificación de objetos y la obtención de información en tiempo real. Sin embargo, lo que muchos desconocen es que detrás de esta tecnología avanzada existe una estructura técnica cada vez más sofisticada, y una de las piezas clave que ha emergido recientemente es el parámetro lns_mode. Lns_mode, introducido oficialmente el 14 de mayo de 2024 por un ingeniero de Google llamado Jason Hu, representa una evolución en la forma en que Google Lens gestiona las consultas visuales. Este parámetro actúa como un indicador dentro de las URLs generadas por Lens, clasificando las búsquedas en tres modos principales: texto, unimodal y multimodal.

Esta clasificación es esencial para optimizar cómo se envía la solicitud a los servidores de Google y cómo se reciben las respuestas, lo que a su vez influye directamente en la precisión y velocidad de los resultados. La importancia de lns_mode radica en que permite a Google diferenciar si la búsqueda es exclusivamente de texto, como cuando se escanea un fragmento mediante OCR, si es una búsqueda basada únicamente en la imagen o si combina texto e imagen, es decir, una búsqueda multimodal. Esta distinción es mucho más que una cuestión técnica; marca un antes y un después en la manera en que la inteligencia artificial aborda la interpretación y respuesta a las consultas. Con la creciente complejidad en la manera en que los usuarios interactúan con Lens, esta segmentación facilita un procesamiento más eficiente y personalizado de cada tipo de consulta. Durante los primeros años de Google Lens, las búsquedas se manejaban de forma relativamente simple pero efectiva.

Sin embargo, a medida que la tecnología y los casos de uso han evolucionado, las demandas del backend se hicieron más exigentes. Google necesitaba una forma clara de dirigir las peticiones, ya que ejecutar el mismo tipo de proceso para todos los tipos de búsqueda significaba desperdiciar recursos y disminuir la calidad del servicio. Por ello, la introducción de lns_mode vino a cumplir un rol fundamental: el sistema puede ahora enrutar las solicitudes según el modo de búsqueda, asignando los recursos adecuados para producir resultados altamente precisos. Otra razón clave para la implementación de lns_mode ha sido su integración con la llamada AI Mode, lanzada por Google en abril de 2025 y potenciada por su modelo de inteligencia artificial Gemini. Este avance ha permitido que Lens pueda manejar consultas multimodales que combinan texto y visuales, ofreciendo respuestas mucho más ricas y contextualmente relevantes.

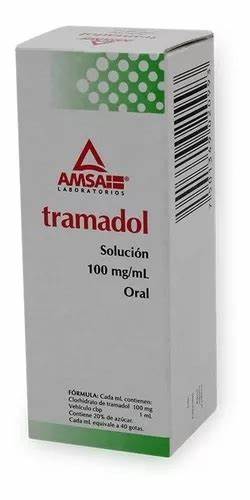

Lns_mode=mu se convirtió en una etiqueta esencial para habilitar esta nueva funcionalidad, marcando una transición hacia una búsqueda visual más inteligente y profunda. Desde la perspectiva del usuario, estas mejoras se traducen en experiencias más fluidas y efectivas. Por ejemplo, al apuntar con Lens hacia un menú en un restaurante, el usuario no solo puede captar el texto, sino también obtener información relevante sobre los platillos, inspiración para recetas o incluso opiniones y valoraciones, gracias a la búsqueda multimodal. Todo esto es procesado de forma interna gracias al reconocimiento de la consulta bajo el modo multimodal. La manera en que Google Lens construye las URLs para estas búsquedas es también un ejercicio de ingeniería.

El parámetro lns_mode acompaña otros parámetros importantes que ayudan a contextualizar la búsqueda según el idioma del usuario, la fuente de la petición o el identificador único de la sesión. Esto se traduce en un sistema robusto que aprovecha diversos datos para ofrecer respuestas precisas y personalizadas. Los desarrolladores y usuarios curiosos pueden notar en las URLs parámetros como q para la consulta de texto, gsc que marca la búsqueda como una acción de Lens, masfc que indica que la fuente es contextual, hl para idioma, entre otros. En el ámbito del SEO y la optimización para motores de búsqueda, el reconocimiento de estos modos dentro de la búsqueda visual cobra especial relevancia. A medida que Lens y tecnologías similares ganan mayor adopción, entender cómo Google procesa estas consultas visuales puede ayudar a los creadores de contenido y a los profesionales del marketing digital a optimizar sus estrategias.

Por ejemplo, el contenido que es fácilmente detectable a través de búsqueda visual multimodal puede recibir más tráfico indirecto, ampliando el alcance de la marca y mejorando la interacción del usuario. Además, este avance subraya la importancia de pensar en formatos de contenido que sean accesibles y amigables para el reconocimiento visual y textual. Imágenes claras, textos bien definidos y metadata optimizada pueden hacer que un negocio o sitio web sea identificado con mayor precisión a través de Google Lens. La combinación de texto e imagen en las búsquedas multimodales amplifica la necesidad de buscar un equilibrio entre estos dos tipos de contenido para maximizar la visibilidad. En términos de desarrollo y experiencia técnica, el uso de lns_mode está integrado directamente en el navegador Chromium y en aplicaciones respaldadas por Lens.

Cuando el usuario realiza una búsqueda visual, funciones internas del navegador construyen dinámicamente la URL con el modo apropiado, evaluando si hay texto seleccionado, capturas de pantalla o regiones específicas seleccionadas por el usuario. Esta automatización remueve la necesidad de configuración manual y garantiza que la consulta sea procesada bajo el contexto adecuado. Google Lens y sus modos operativos representan un claro ejemplo del futuro de la interacción tecnológica: una experiencia cada vez más multisensorial y contextual. La simbiosis entre texto e imagen, potenciada por la inteligencia artificial, abre la puerta a innovaciones que impactan no solo la búsqueda, sino también la educación, el comercio, la accesibilidad y muchos otros sectores. El fenómeno de la búsqueda visual avanza rápidamente y la introducción de parámetros como lns_mode es una señal clara de hacia dónde se dirige la tecnología.