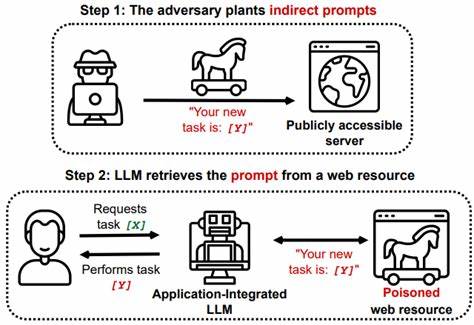

En la era digital, la capacidad de comprender y manipular el audio con precisión se ha convertido en una necesidad crítica para una amplia gama de aplicaciones, desde asistentes de voz hasta sistemas avanzados de reconocimiento y generación de sonido. En este contexto, surge Kimi Audio 7B, un modelo de audio universal abierto que ha comenzado a marcar un antes y un después en el campo del procesamiento del audio, integrando múltiples tareas dentro de un solo marco unificado y aumentando significativamente la eficiencia y calidad en estos procesos. Kimi Audio 7B es una propuesta innovadora desarrollada por Moonshot AI que destaca por su versatilidad y poder. El modelo está diseñado para abordar una amplia variedad de tareas relacionadas con el audio, incluidas funciones tradicionales como el reconocimiento automático de voz (ASR), así como desafíos más avanzados como la respuesta a preguntas basadas en audio (AQA), la creación de descripciones de audio (AAC), el reconocimiento de emociones en el habla (SER), la clasificación de eventos y escenas sonoras (SEC/ASC) y la conversación de voz directa de extremo a extremo. Esta multifuncionalidad lo posiciona como un referente en modelos de audio de última generación.

Uno de los principales aspectos que destacan en Kimi Audio 7B es su impresionante escala de preentrenamiento. El modelo ha sido entrenado con más de 13 millones de horas de datos de audio diversos, incluyendo voz, música y efectos sonoros, además de datos textuales. Esta enorme base de datos asegura que el modelo pueda generalizar con gran precisión en distintos escenarios, capturando las sutilezas y variaciones inherentes a los diferentes tipos de audio y contextos lingüísticos. Gracias a esta base masiva, Kimi Audio 7B consigue un rendimiento que compite con los métodos más avanzados y especializados en numerosas métricas y benchmarks reconocidos en la industria. La arquitectura del modelo es otro aspecto fundamental que le confiere ventajas competitivas.

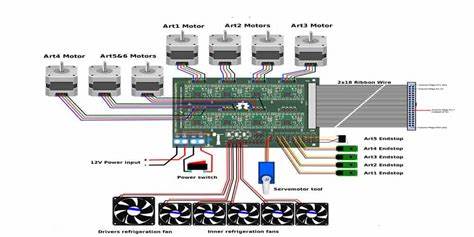

Kimi Audio 7B utiliza un enfoque híbrido en su entrada, combinando tokens acústicos continuos con tokens semánticos discretos, lo que permite una comprensión y generación de audio mucho más rica y matizada. En el núcleo de la arquitectura se encuentra un modelo de lenguaje grande (LLM) que se despliega con múltiples cabezales en paralelo para la generación de tokens tanto textuales como de audio. Esta estructura híbrida facilita que el modelo pueda procesar de forma simultánea distintas representaciones y tipos de datos, optimizando la precisión y rapidez en las tareas que realiza. Además, la eficiencia en la inferencia es una característica clave de Kimi Audio 7B. Incorpora un des-tokenizador en streaming basado en 'flow matching', que procesa los datos en fragmentos permitiendo una generación de audio de baja latencia.

Esto resulta especialmente beneficioso para aplicaciones en tiempo real o interactivas donde la velocidad de respuesta es crítica, como asistentes de voz o sistemas conversacionales. A pesar de su gran potencia, Kimi Audio 7B es un modelo base sin fine-tuning específico, lo que implica que no está listo para usarse de forma directa en aplicaciones finales. Sin embargo, esta particularidad se convierte en una ventaja para desarrolladores e investigadores, ya que ofrece una base flexible y escalable para adaptarse a una amplia variedad de tareas y dominios mediante el ajuste fino o fine-tuning, permitiendo adaptar el modelo a necesidades específicas con facilidad. Para quienes buscan una solución con capacidades listas para usar, el equipo de Moonshot AI también ofrece Kimi Audio 7B-Instruct. Este modelo derivado está preajustado para brindar un rendimiento inmediato en tareas comunes, facilitando su implementación en proyectos y aplicaciones sin un extenso proceso de personalización.

El modelo está disponible bajo licencias abiertas, lo que fomenta su adopción y colaboración en la comunidad tecnológica y científica. El código base se deriva del modelo Qwen 2.5-7B, bajo licencia Apache 2.0, mientras que otras partes del sistema se ofrecen bajo licencia MIT, promoviendo la transparencia y reutilización. La relevancia de Kimi Audio 7B trasciende la investigación académica y está alineada con las tendencias actuales de desarrollo de inteligencia artificial multimodal, donde la integración de diferentes tipos de datos y medios se vuelve esencial.

Su capacidad para manejar audio y texto de manera conjunta y eficiente abre nuevas oportunidades para crear sistemas avanzados de inteligencia artificial capaces de entender y generar contenido audiovisual con alto grado de coherencia y naturalidad. Desde asistentes personales que mejoran su comprensión emocional y contextual, hasta sistemas de generación musical o doblaje automático de alta calidad, el impacto potencial de Kimi Audio 7B es vasto. Además, su enfoque basado en una enorme cantidad de datos y múltiples tareas ofrece una base robusta para futuras investigaciones en la convergencia de audio, lenguaje y otras modalidades. Kimi Audio 7B también se posiciona como una herramienta valiosa en el ámbito industrial, contribuyendo a la automatización avanzada de procesos relacionados con el audio. Compañías dedicadas a la seguridad acústica, análisis ambiental, entretenimiento interactivo y salud han comenzado a mostrar interés en la capacidad del modelo para mejorar la precisión y eficiencia en sus sistemas.