En el dinámico mundo de la inteligencia artificial, la interoperabilidad y la integración eficiente de sistemas son elementos clave para desbloquear todo el potencial de las tecnologías modernas. En este contexto, el Protocolo de Contexto de Modelo, mejor conocido como MCP por sus siglas en inglés (Model Context Protocol), ha emergido como un estándar revolucionario que está cambiando la manera en que los modelos de IA acceden a la información y colaboran con otras herramientas. Considerado como el "USB-C para los modelos de IA", MCP busca simplificar las conexiones entre modelos y datos, establecer reglas claras para la comunicación y, al mismo tiempo, abordar los retos de seguridad que surgen en este proceso. El origen de MCP se remonta a noviembre de 2024, cuando Anthropic lo lanzó inicialmente para su modelo Claude AI. Desde entonces, la comunidad de desarrolladores ha adoptado rápidamente este estándar, con grandes actores como OpenAI, Neon, Cloudflare y Sentry construyendo sus propios servidores MCP.

Pero ¿qué es exactamente MCP y por qué ha generado tanto interés entre expertos y desarrolladores? Para entenderlo, debemos desglosar sus componentes fundamentales: el modelo, el contexto y el protocolo. El “modelo” hace referencia a los modelos de lenguaje de gran tamaño o a cualquier modelo de inteligencia artificial que requiere datos externos para funcionar eficazmente. El “contexto” es la información relevante que se suministra al modelo para que genere respuestas precisas, como fragmentos de código, documentos o resultados de consultas en bases de datos. Finalmente, el “protocolo” se refiere a un conjunto de estándares y reglas que facilitan el intercambio estructurado y seguro de estos datos. La analogía con USB-C es fundamental para entender la visión detrás de MCP.

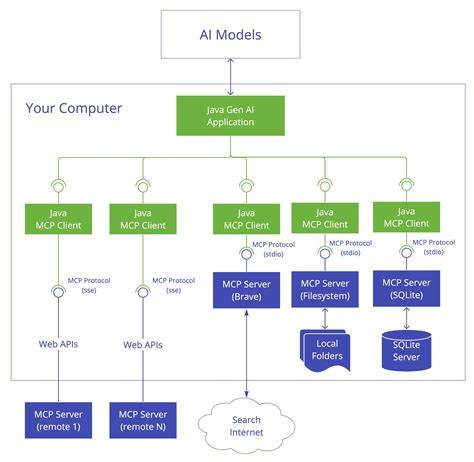

Así como USB-C unificó las conexiones físicas en un solo puerto para cargar dispositivos, transferir datos y otros usos, MCP aspira a estandarizar la conexión entre cualquier modelo de IA y cualquier fuente de datos o herramienta. En lugar de construir integraciones personalizadas que multiplican la complejidad (imagine conectar M modelos con N fuentes de datos, resultando en M por N conexiones), MCP reduce el problema a una suma simple, permitiendo que modelos y fuentes se comuniquen mediante un estándar común. La arquitectura de MCP se apoya en tres actores esenciales: el Host, los Clientes MCP y los Servidores MCP. El Host generalmente es la aplicación de IA utilizada por el usuario final, pudiendo ser desde un entorno de desarrollo integrado (IDE) como VS Code, hasta aplicaciones de escritorio AI como Claude Desktop. El Host gestiona la interacción general y orquesta las comunicaciones.

Los Clientes MCP actúan como líneas de comunicación dentro del Host, cada uno vinculado a un Servidor MCP específico. Estos clientes son los encargados de enviar y recibir solicitudes y respuestas siguiendo el protocolo MCP. Los Servidores MCP, por otro lado, funcionan como pasarelas especializadas que se comunican con sistemas concretos, como repositorios de código, bases de datos o incluso funcionalidades particulares como búsquedas web. Estos servidores “traducen” las capacidades de sus sistemas subyacentes a un lenguaje conocido y estandarizado, facilitando que los modelos de IA puedan solicitar y usar esos recursos eficazmente. La interacción entre clientes y servidores se realiza mediante JSON-RPC 2.

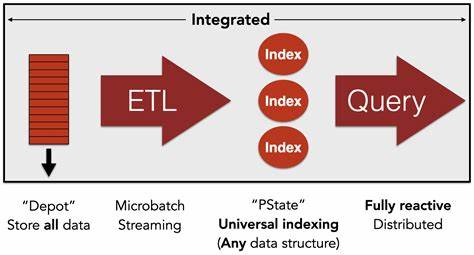

0, un formato muy estructurado de mensajería basado en JSON, muy popular por su sencillez y compatibilidad transversal. Este marco asegura claridad y coherencia en el intercambio de información, sin importar quién haya desarrollado cada componente. El tipo de contexto que pueden intercambiar los sistemas mediante MCP se organiza en tres categorías clave llamadas "Primitives": recursos, indicaciones y herramientas. Los recursos son datos estructurados que el Servidor entrega al modelo, como fragmentos de código, documentos o resultados de una consulta en una base de datos, proporcionando información factual que mejora la precisión del modelo. Las indicaciones o prompts son instrucciones o plantillas predefinidas que el Servidor puede ofrecer al usuario o al modelo para guiar la generación de textos o acciones específicas, como resumir documentos o generar código en un estilo particular.

Estas a menudo se activan cuando el usuario lo decide. Por último, las herramientas representan acciones concretas que el modelo puede solicitar al Servidor para ejecutar, pero que generalmente requieren autorización previa del usuario. Esto incluye solicitar búsquedas en la web, consultar bases de datos complejas o incluso enviar correos electrónicos. Esta capacidad amplía significativamente el alcance funcional de los asistentes de IA. Una dimensión crucial para comprender MCP es dónde operan los Servidores MCP.

Existen dos opciones principales: servidores locales y remotos. Los servidores locales corren directamente en el dispositivo del usuario, permitiendo una comunicación directa y de baja latencia a través del canal estándar de entrada/salida (stdio). Esta configuración es ideal para desarrolladores que trabajan de forma local, ya que brinda control completo sobre el entorno y los datos. En contraste, los servidores remotos están alojados en la nube, lo que permite accesos desde cualquier dispositivo conectado a Internet, normalmente mediante protocolos web como Server-Sent Events (SSE) y HTTP. Estas implementaciones pueden usar métodos seguros de autenticación y autorización, como OAuth, para gestionar accesos y permisos de forma más flexible.

La ventaja es que no requieren configuración complicada para los usuarios finales y pueden integrarse fácilmente con aplicaciones web y agentes basados en la nube. Servicios como Vercel y Cloudflare facilitan el despliegue y la gestión de estos servidores remotos, dándoles flexibilidad y escalabilidad para atender una gran variedad de aplicaciones. El transporte de mensajes es otro componente esencial en MCP. Para servidores locales, el método preferido es stdio, un canal simple y directo que omite la necesidad de red y límites de firewall. Para servidores remotos, la combinación de SSE para streaming eficiente y HTTP para solicitudes garantiza que las comunicaciones sean seguras y fluidas a través de Internet.

Sin embargo, con gran poder viene gran responsabilidad, y MCP no está exento de riesgos de seguridad que deben tomarse muy en serio. El protocolo en sí no impone medidas de seguridad intrínsecas; por ello, la protección recae en las implementaciones que lo usan y en las buenas prácticas. Una amenaza significativa es el "envenenamiento de herramientas", donde actores malintencionados pueden insertar instrucciones o datos dañinos a través de las herramientas o los métodos que el modelo utiliza. Si no se valida y sanitiza adecuadamente, la IA podría ejecutar comandos adversos involuntariamente. Además, cuando un asistente IA gestiona múltiples herramientas con diferentes permisos, existe el riesgo de que una herramienta comprometida pueda acceder a datos sensibles mediante otra herramienta con mayores privilegios, exponiendo información privada de forma inadvertida.

Los riesgos varían también entre servidores locales y remotos. Los locales, al ejecutarse en el entorno del usuario, pueden tener acceso amplio al sistema operativo, archivos y red, complicando el aislamiento y protección ante amenazas. Los remotos, por su parte, enfrentan peligros típicos de la red como ataques Man-in-the-Middle, filtraciones de datos y problemas de autenticación y gestión de claves. Por ello, la recomendación general es implementar controles estrictos basados en el principio de mínimo privilegio, segregar cada herramienta como un dominio de seguridad independiente y utilizar protocolos robustos de autenticación y autorización, en especial para servidores remotos via OAuth. Las aplicaciones prácticas de MCP son variadas y representan un avance significativo en la usabilidad de la IA.

En entornos de desarrollo, MCP permite asistentes inteligentes que se integran directamente con el código y documentación específicos del proyecto, mejorando la productividad y eficiencia del programador. En empresas, los chatbots hipercontextuales pueden acceder de forma segura a bases de conocimiento internas, brindando respuestas precisas y personalizadas en tiempo real. Para usuarios finales, las capacidades para interactuar con archivos locales, aplicaciones y servicios mediante MCP amplían enormemente el espectro de funciones realizables con asistentes de IA, desde la administración de tareas hasta la automatización de flujos de trabajo complejos. En resumen, el Protocolo de Contexto de Modelo representa un hito en la evolución del ecosistema de inteligencia artificial. Al establecer un lenguaje común y una infraestructura estandarizada para conectar modelos con datos y herramientas, MCP facilita integraciones más fáciles, escalables y seguras.

Aunque el protocolo no garantiza seguridad automáticamente, su diseño flexible y modular permite a desarrolladores implementar protecciones adaptadas a cada entorno. Por todo ello, MCP está allanando el camino hacia asistentes de inteligencia artificial más inteligentes, eficientes y confiables, tanto en el escritorio, como en IDEs y en la web. Para quienes estén interesados en profundizar, existen recursos accesibles y guías para iniciar la implementación y aprovechar todas las ventajas que esta revolucionaria tecnología ofrece.