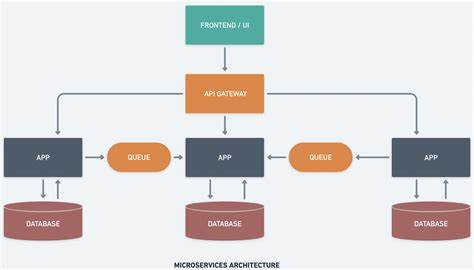

En el mundo actual del desarrollo de software, la creación de aplicaciones altamente escalables y con respuestas rápidas es fundamental para ofrecer experiencias de usuario óptimas. Los microservicios en Go han ganado popularidad debido a las capacidades nativas del lenguaje para manejar concurrencia y gestionar eficientemente los recursos. Sin embargo, para alcanzar un balance ideal entre baja latencia y alta capacidad de procesamiento, se requiere un enfoque integral que abarque desde optimizaciones en el código hasta mejoras a nivel de sistema y arquitectura. Comprender la latencia y la capacidad de procesamiento es el primer paso para cualquier estrategia de optimización. La latencia se refiere al tiempo que tarda un servicio en procesar una solicitud individual, mientras que la capacidad de procesamiento describe cuántas solicitudes pueden manejarse en un periodo determinado.

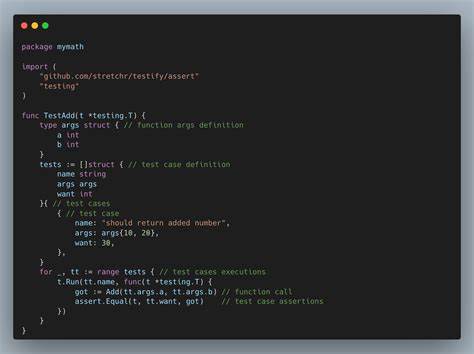

Aunque a menudo están relacionados, mejorar uno puede impactar negativamente en el otro si no se aborda con cautela. Por lo tanto, los desarrolladores deben encontrar un equilibrio que se adapte a las necesidades específicas de su aplicación y caso de uso. La concurrencia es uno de los pilares en los que Go destaca. Su modelo de goroutines y canales permite ejecutar múltiples tareas simultáneamente sin grandes costos de memoria o complejidad. Aprovechar este modelo concurrente permite que las solicitudes se procesen en paralelo, reduciendo la latencia en la respuesta y aumentando el throughput.

No obstante, un manejo indiscriminado de goroutines puede llevar a un consumo excesivo de recursos, pérdida de control y dificultades para depurar. Aquí entra en juego el patrón de worker pool, que permite limitar la cantidad de goroutines activas y distribuir eficientemente las tareas, manteniendo el balance entre rapidez y estabilidad. El uso de Redis como componente en la arquitectura de microservicios en Go se ha convertido en una práctica esencial para mejorar tanto la latencia como la capacidad. Redis, como datastore en memoria con alta velocidad de acceso, ofrece múltiples ventajas que van más allá del simple caché. Implementar Redis como un nivel de cacheo intermedio evita consultas repetitivas y pesadas a la base de datos, reduciendo notablemente el tiempo de respuesta.

Además, emplear Redis para el control de tasa (rate limiting) ayuda a proteger el servicio ante picos de tráfico, garantizando que no se saturen los sistemas y manteniendo una experiencia uniforme para los usuarios. La sincronización distribuida también es factible gracias a Redis mediante mecanismos de bloqueo, permitiendo que diversas instancias de microservicios coordinen acciones esenciales sin conflictos o condiciones de carrera. Esta capacidad es clave en escenarios donde los datos compartidos son críticos o los procesos deben ejecutarse en orden estricto. Sumado a lo anterior, implementaciones avanzadas a través de estrategias de cacheo multinivel combinan la memoria local del microservicio con Redis, logrando un equilibrio aún más eficiente entre velocidad y consistencia de datos. Complementando esto, Redis Pub/Sub facilita la comunicación ligera y rápida entre microservicios, soporte que puede reemplazar o complementar sistemas de mensajería más complejos y pesados.

La velocidad y simplicidad de esta herramienta la hacen idónea para notificaciones, eventos o sincronización rápida de estados, mejorando la reactividad general del sistema. Otro aspecto crucial es la optimización de memoria en las aplicaciones Go. La reutilización de objetos a través de pooling reduce la presión sobre el recolector de basura y disminuye la latencia provocada por pausas imprevisibles. Evitar asignaciones innecesarias al preasignar capacidad en estructuras como slices también ayuda a mantener eficiencia, especialmente bajo cargas altas. Además, el correcto manejo de conexiones para bases de datos y servicios externos mediante pools de conexiones reduce el overhead de establecer nuevas conexiones constantemente, evitando cuellos de botella y mejorando la estabilidad.

La adopción de protocolos modernos y eficientes en las capas de red complementa las ventajas internas del código. HTTP/2 y gRPC sobresalen por su multiplexación de solicitudes, compresión de headers y comunicación binaria, lo que reduce el tiempo de transferencia y optimiza el uso del ancho de banda. Junto con ajustes en configuraciones a nivel del sistema operativo, como aumentar el límite de conexiones simultáneas, se maximiza el rendimiento en escenarios de alto volumen de tráfico. En el nivel de base de datos, técnicas como el procesamiento en lote disminuyen la frecuencia de llamadas y consolidan operaciones, lo que a la vez reduce la carga y el tiempo total invertido en consultas. La combinación de estas estrategias con una configuración adecuada del pool de conexiones es vital para evitar quedar limitado por la infraestructura de datos.

Para llevar el rendimiento clásico de Go y Redis al siguiente nivel, es imprescindible integrar herramientas de monitoreo y diagnóstico que brinden visibilidad en tiempo real. Detectar puntos críticos y cuellos de botella permite actuar con precisión y actualizaciones informadas, previniendo degradaciones o caídas inesperadas. Las pruebas de benchmark deben formar parte del ciclo de desarrollo para validar que las optimizaciones realmente aportan mejoras significativas sin introducir nuevos problemas. Por último, una configuración sólida en arquitecturas distribuidas, con balanceo de carga inteligente y políticas de reintentos o circuit breakers, garantiza que las microservicios sean resilientes y capaces de manejar picos de demanda sin sacrificar la calidad en las respuestas. En conclusión, optimizar microservicios desarrollados en Go para lograr baja latencia y alta capacidad de procesamiento es un desafío multifacético que abarca la escritura eficiente del código, la implementación de patrones de concurrencia controlada, la integración avanzada con Redis, y la optimización a nivel de red y sistema.

Un enfoque equilibrado que combine estas prácticas no solo mejora el rendimiento inmediato, sino que también asegura que la aplicación sea escalable, confiable y preparada para las demandas futuras. La clave está en medir constantemente, adaptar y evolucionar las soluciones de acuerdo con las necesidades reales del entorno y características del flujo de trabajo.