La inferencia bayesiana representa una metodología poderosa para el análisis probabilístico y la toma de decisiones bajo incertidumbre. Su aplicación se extiende a múltiples sectores, desde la medicina hasta la finanza, pasando por la inteligencia artificial y el aprendizaje automático. Sin embargo, uno de los retos más significativos a la hora de implementar modelos bayesianos en entornos productivos es la adecuación a requerimientos estrictos de baja latencia. Esto implica que las predicciones deben entregarse en milisegundos, algo que no siempre es posible con métodos tradicionales de inferencia bayesiana. En el núcleo del problema está la dificultad para equilibrar dos factores fundamentales: la precisión predictiva y la velocidad de inferencia.

Métodos clásicos como el uso de PyMC con su función pm.sample_posterior_predictive suelen proveer resultados sólidos y precisos, pero muchas veces tardan varios segundos en ejecutarse. Este retraso puede ser prohibitivo en escenarios como sistemas en tiempo real o aplicaciones web con alta demanda de usuarios, donde la experiencia del usuario y la eficiencia del sistema dependen en gran medida del tiempo que se tarda en obtener una predicción. Para mitigar este problema, algunos desarrolladores optan por implementar manualmente la lógica de inferencia, transformando el cálculo bayesiano en operaciones específicas dentro de frameworks de deep learning como PyTorch. Sin embargo, esta aproximación tradicional es propensa a errores y requiere un esfuerzo significativo, tanto en desarrollo como en mantenimiento.

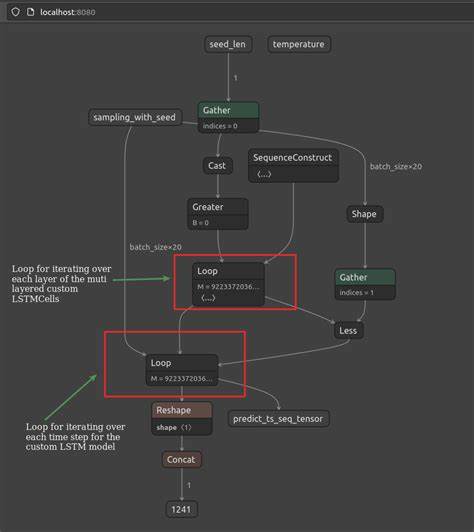

Además, si no se sigue un estándar claro, esta implementación puede acarrear inconsistencias cuando se trata de replicar o actualizar modelos. Una solución emergente y especialmente prometedora es la conversión y despliegue de modelos bayesianos utilizando PyTorch y ONNX. Este enfoque parte de la representación eficiente del posterior bayesiano en tensores de PyTorch, organizados en una estructura (dimensión, cantidad de draws o muestras) que permite manipulación ágil y paralelización de cálculos. Esta organización facilita no solo el proceso de inferencia, sino también la transformación estandarizada del modelo hacia otros entornos. El siguiente paso fundamental es extraer la transformación del modelo en código que sea independiente del framework específico, logrando así una interfaz agnóstica que puede funcionar tanto con tensores de PyTorch como con PyTensor.

Esta compatibilidad estrecha entre los dos formatos es una pieza clave que permite utilizar la misma base de código para inferencia en línea (online) y por lotes (offline). Esta consistencia no solo reduce la carga de mantenimiento del código sino que también asegura que las predicciones sean reproducibles y coherentes sin importar el contexto de ejecución. Finalmente, la serialización del modelo en formato ONNX (Open Neural Network Exchange) representa el salto definitivo hacia la eficiencia y la portabilidad. ONNX es un estándar abierto ampliamente aceptado para representar modelos de aprendizaje automático, que permite que estos se desplieguen en distintos operadores e infraestructuras con bajo tiempo de latencia. Una vez convertido a ONNX, el modelo bayesiano puede ejecutarse con rapidez en producción, utilizando entornos optimizados para inferencias rápidas y consumiendo menos recursos.

Una ventaja destacada de este método es su independencia del lenguaje de programación. Al estar en formato ONNX, el modelo bayesiano no está restringido a Python; puede ser desplegado en plataformas que utilicen Go, JVM, Rust u otros lenguajes, facilitando de esta manera su integración en sistemas heterogéneos y ampliando las posibilidades de aplicación en industrias con variados ecosistemas tecnológicos. El camino hacia esta implementación eficiente requiere algunos pasos técnicos, pero a nivel conceptual representa un cambio paradigmático en la forma en que se abordan los desafíos de latencia en inferencia bayesiana. La clave está en mantener una representación clara y modular del modelo, optimizar su transformación y aprovechar herramientas y estándares que permitan portabilidad y bajo tiempo de respuesta en producción. Por ejemplo, en la práctica, la carga del posterior del modelo se organiza en tensores de PyTorch, lo que permite operaciones vectoriales rápidas.

A continuación, la transformación del modelo que aplica distintas funciones o cálculos sobre estas muestras se codifica de manera genérica, compatible con distintas estructuras de datos tensoriales. Finalmente, la exportación del modelo a ONNX se realiza con las utilidades propias de PyTorch, generando un archivo que puede ser utilizado en diversos runtime especializados en acelerar inferencias. Esta metodología no solo beneficia el rendimiento y la escalabilidad de los sistemas que incorporan inferencia bayesiana, sino que también reduce considerablemente la complejidad del ciclo de vida del desarrollo, facilitando actualizaciones y pruebas. Además, permite que los modelos se conviertan en componentes reutilizables y fácilmente integrables en múltiples plataformas y servicios. Es importante destacar que, para maximizar el potencial de este enfoque, la preparación de datos, incluyendo la codificación de variables categóricas, debe realizarse adecuadamente en etapas previas, asegurando que la entrada al modelo tenga el formato correcto y optimizado para la inferencia rápida.

Aunque los ejemplos públicos pueden omitir detalles como la codificación de características categóricas para simplificar, en escenarios reales esto es indispensable. El futuro de la inferencia bayesiana en producción apunta claramente hacia soluciones que combinan precisión estadística con ingeniería de alto rendimiento. El uso de PyTorch para representar el posterior, la abstracción de transformaciones y la exportación a ONNX conforman un stack tecnológico moderno que cubre esa necesidad crítica. Esta estrategia no solo es escalable y eficiente, sino que también democratiza el despliegue de modelos bayesianos, permitiendo que organizaciones de distintos tamaños y con diferentes arquitecturas tecnológicas aprovechen sus ventajas. En conclusión, la implementación de modelos bayesianos con baja latencia mediante PyTorch y ONNX es una aproximación robusta y práctica para resolver el desafío histórico de acelerar la inferencia sin sacrificar la precisión ni la integridad estadística.

Adoptando este método, los desarrolladores y científicos de datos podrán entregar predicciones rápidas y confiables, mejorar la experiencia del usuario y ampliar el rango de aplicaciones posibles para la inferencia bayesiana en entornos productivos. La comunidad técnica ya está recogiendo los beneficios de esta estrategia, aprovechando repositorios abiertos y ejemplos funcionales que facilitan su adopción y adaptación. Por lo tanto, quienes busquen optimizar sus pipelines de inferencia bayesiana deberían considerar seriamente incorporar PyTorch y ONNX en sus flujos de trabajo, asegurando así soluciones ágiles, consistentes y listas para la era de la alta velocidad en la inteligencia artificial.