El mundo de la programación asíncrona en Python puede resultar, en muchos casos, como una caja negra inexplicable. Cada vez que utilizamos async y await al escribir código con asyncio, el resultado es satisfactorio pero la sensación de magia sigue presente. ¿Cómo es que el programa continúa ejecutándose sin bloquearse cuando una función realiza una operación de entrada/salida? ¿Quién está gestionando el proceso oculto que permite que otras tareas continúen avanzando mientras esperamos? Si te has hecho estas preguntas, estás a punto de descubrir la maravillosa explicación detrás de Protocolo asyncio, entendiendo sus entresijos y la manera en que todo se conecta, desarmándolo y reconstruyéndolo paso a paso desde lo más básico: el yield. Para entender asyncio, debemos comenzar con algo fundamental en Python: los generadores y las corutinas. Un generador es una función que puede pausar su ejecución y luego continuar donde lo dejó.

Esto se logra utilizando la palabra yield y permite que el contexto de la función se mantenga intacto mientras se devuelve temporalmente un valor. Pero aquí está la belleza: un generador puede recibir valores externos a través del método send, convirtiéndose en una corutina, es decir, un sistema que permite cooperativamente pasar el control para ejecutar tareas de forma concurrente, sin necesidad de hilos ni procesos adicionales. La esencia de asyncio radica en esta capacidad de pausar y reanudar funciones para evitar que el programa quede bloqueado. En lugar de invocar operaciones de manera secuencial y esperar activamente a que terminen, asyncio permite escribir funciones que "se detienen" cuando esperan por una operación larga, como una consulta a una API o una lectura de un socket, y luego reaparecen cuando el resultado está listo. Este mecanismo se apoya en lo que se denomina un planificador o scheduler, que maneja una cola de tareas y determina cuál se ejecuta en qué momento.

Construir un scheduler sencillo involucra una estructura que almacena las corutinas listas para continuar su ejecución. Se ejecuta un ciclo donde se toma la siguiente tarea, se ejecuta hasta el próximo yield y luego se coloca de vuelta en la cola para que otras tareas puedan avanzar mientras esta espera. Esto es multitarea cooperativa. La ventaja es que el programador controla explícitamente cuándo ceder el control, lo que facilita un manejo predictivo y eficiente de recursos. Sin embargo, un problema surge al querer esperar por eventos externos, como una operación de I/O sin bloquear el sistema.

Aquí es donde el concepto de Future resulta esencial. Un Future es una promesa de un resultado que no está disponible todavía, pero que llegará en algún momento. Cuando una corutina devuelve un Future, el scheduler suspende su tarea hasta que el Future se complete. Así, el sistema puede seguir ejecutando otras tareas en lugar de quedarse esperando inactivo. Implementar un Future propiamente dicho requiere una estructura que pueda verificar periódicamente si el evento esperado ya ocurrió y notificar a la tarea correspondiente para que continúe su ejecución.

Este mecanismo se basa en callbacks que se ejecutan justo en el momento en que la respuesta está disponible. Esto elimina la necesidad de pausar el hilo principal y aprovecha eficientemente los recursos del sistema. Un ejemplo práctico es la implementación de una función de espera no bloqueante, similar a asyncio.sleep, que expone esta arquitectura. La corutina invoca un Future que se resuelve después de un periodo de tiempo determinado.

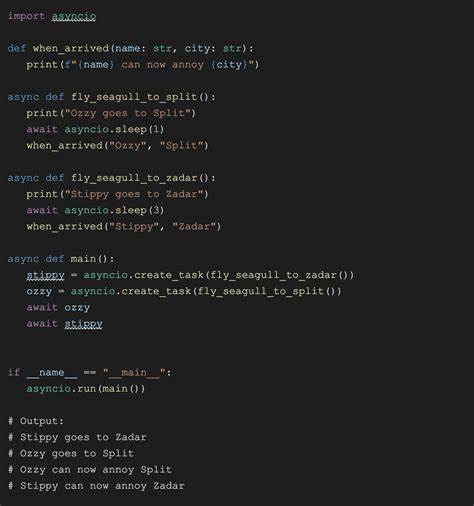

Durante ese intervalo el scheduler sigue ejecutando otras tareas. Al cumplirse el período, la llamada que estaba "esperando" se reanuda limpiamente. Con la base de generadores, corutinas, scheduler y futures sentada, la transición para soportar la sintaxis async/await de Python es más un cambio de cara que de sustancia. La palabra clave async define que la función devuelva un coroutine object y await se convierte en una forma legible y explícita de realizar un yield from tras bambalinas. El truco consiste en hacer que nuestros futures sean "awaitables" implementando el método __await__.

Esto hace que Python entienda cómo suspender y reanudar corutinas en función de la resolución de los futures. Por último, llevar este modelo al mundo real implica manejar operaciones de entrada/salida reales sin bloquear el programa. Python dispone del módulo selectors que facilita la supervisión de sockets para saber cuándo están listos para lectura o escritura sin bloquear el hilo principal. Al registrar un socket con el selector y consultarlo sin bloqueo, podemos implementar nuestras propias futures específicas para operaciones como aceptar conexiones y leer datos. En concreto, una future AcceptSocket suspende la ejecución hasta que el selector indica que hay una nueva conexión entrante en el socket.

De forma similar, ReadSocket espera hasta que los datos estén disponibles para ser leídos. Estas abstracciones se integran fluidamente con nuestro scheduler, que se encarga de gestionar la cola de tareas y garantizar que cada una reanude en el momento adecuado. El resultado es un servidor echo completamente funcional, construido con código explicado y controlado al 100%. Escucha conexiones entrantes, crea una nueva tarea para cada cliente y lee y escribe datos sin bloquear al resto del sistema. Al entender este proceso, se desvanece la sensación de magia y se aprecia la sofisticación detrás de cada await.

El camino para llegar a una librería que replica el comportamiento de asyncio es desafiante, pero revelador. Aprendemos que el verdadero “secreto” no está en la sintaxis sino en los generadores y cómo el programador diseña un esquema cooperativo para gestionar múltiples tareas aparentemente simultáneas en un entorno single-threaded. Esto abre la puerta para comprender no solo asyncio, sino también sistemas de concurrencia en otras plataformas y lenguajes. Más allá de la teoría, este conocimiento permite abordar con mayor confianza problemas complejos como timeouts, cancelaciones de tareas y manejo de prioridades, sabiendo que la base está dominada. Además, invita a los desarrolladores a indagar en el código fuente de asyncio para apreciar las optimizaciones y estructuras adicionales que lo hacen robusto.

En definitiva, desentrañar asyncio desde sus raíces marca un antes y un después en la percepción y manejo de la programación asincrónica. Dominar generadores, futures y schedulers, y vincularlos con técnicas de monitoreo de I/O no bloqueante redefine la forma en que pensamos en el flujo de ejecución y maximiza el aprovechamiento de recursos disponibles, todo con un control que reafirma la filosofía Python de código claro, eficiente y explícito.