En el mundo actual, donde la inteligencia artificial (IA) se ha convertido en una herramienta fundamental para diversos sectores, la eficiencia en el procesamiento de grandes volúmenes de datos cobra una importancia crucial. Anthropic ha desarrollado la API de Lotes de Mensajes, una solución que permite gestionar solicitudes a su modelo Claude de manera asíncrona, lo que representa un avance significativo para desarrolladores y empresas que manejan cargas elevadas de trabajo. Cuando esta API se combina con Temporal, una plataforma de orquestación de aplicaciones distribuidas robusta y escalable, el resultado es un sistema poderoso que optimiza costos y asegura la durabilidad y confiabilidad en la ejecución de procesos complejos. En este texto exploraremos cómo funciona esta combinación y cuáles son sus beneficios y aplicaciones prácticas. La API de Lotes de Mensajes de Anthropic surge como respuesta a las limitaciones y costos asociados con el procesamiento individual y sincrónico de las solicitudes a modelos de lenguaje avanzado.

Tradicionalmente, enviar miles de consultas una a una implicaba no solo altos costos económicos sino también mayores riesgos de errores o fallos en la gestión de las respuestas. Esta nueva API permite agrupar hasta 10,000 consultas en un solo lote, procesándolas dentro de un periodo máximo de 24 horas. Aunque esta opción introduce cierta latencia en la respuesta, el ahorro en costos puede alcanzar entre un 50% y 85% en comparación con llamadas estándar. Esta diferencia es sumamente atractiva para proyectos que no requieren respuestas inmediatas, pero sí necesitan procesar gran cantidad de información. La clave para aprovechar al máximo la API de Lotes de Mensajes reside en comprender que es un método diseñado para trabajar de forma asíncrona y en masa, reservando la opción de procesar tareas críticas que exijan respuestas rápidas para las llamadas estándar.

Esto abre un abanico de posibilidades para trabajos como análisis de grandes bases de datos textuales, generación masiva de resúmenes o traducciones, y evaluación automática de extensos conjuntos de pruebas o feedback. Uno de los principales retos al trabajar con lotes tan grandes está en la gestión del estado, la supervisión de tareas y la recuperación en caso de fallas. Aquí es donde Temporal aporta un gran valor agregado. Temporal funciona como un motor de workflows duradero y tolerante a fallos, capaz de orquestar la ejecución de actividades que pueden ser desde llamadas a APIs hasta operaciones de base de datos. Lo que diferencia a Temporal es que estas actividades son gestionadas con una lógica de reintentos automática y seguimiento continuo, lo que elimina la necesidad de construir complejos sistemas de control de estado y manejo de errores de forma manual.

Para los desarrolladores que utilizan TypeScript, la integración con la API de Lotes de Mensajes junto con Temporal representa una oportunidad para construir sistemas escalables y confiables sin sacrificar flexibilidad. La construcción comienza validando el formato de los mensajes que se quieren enviar, ya que enviar lotes mal formateados puede resultar en errores que afecten a múltiples solicitudes. Posteriormente, se crea el lote mediante la API y se devuelve un batchId que sirve para monitorear el estado. La supervisión periódica mediante funciones que consultan el estado del lote es fundamental. Temporal implementa una lógica avanzada que incluye backoff exponencial en el sondeo, lo que optimiza las llamadas al servicio y evita un consumo innecesario de recursos.

Cuando el lote ha terminado su procesamiento, se pueden recuperar los resultados de manera fiable, clasificando las respuestas exitosas de las que han tenido algún error o inconveniente. Esta separación permite implementar estrategias específicas de reintento o análisis posterior. Otra ventaja que ofrece Temporal es la posibilidad de manejar múltiples lotes simultáneamente. La plataforma distribuye la carga entre diferentes workers y mantiene un historial completo de ejecución, facilitando la depuración y auditoría en producción. Además, la interfaz gráfica que proporciona Temporal permite visualizar en tiempo real el avance de los workflows, una herramienta indispensable para equipos técnicos y de gestión.

Además de la simplificación técnica, la integración entre la API de Anthropic y Temporal es una respuesta a la necesidad de optimizar los gastos asociados con el uso de inteligencia artificial. Al lograr reducciones significativas en costos sin sacrificar la posibilidad de procesamiento masivo, se abren oportunidades para empresas de todos los tamaños para incorporar IA en sus flujos de trabajo. Los casos de uso típicos incluyen procesamiento de retroalimentación masiva de clientes, moderación de contenido en plataformas que gestionan millones de interacciones, traducción en lote de documentos, y generación automatizada de resúmenes o reportes. En todos estos escenarios, el factor diferenciador es que los tiempos de respuesta pueden ser menos inmediatos a cambio de un manejo más eficiente y económico de las solicitudes. Para quienes necesiten respuestas en tiempo real se mantiene la opción del modo tradicional, dejando a la API de Lotes de Mensajes el rol para trabajos pesados y programados.

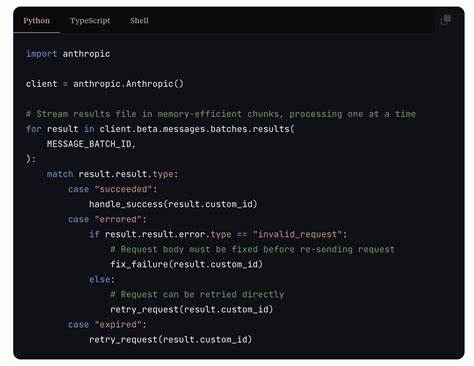

Para dar los primeros pasos en esta integración, es esencial contar con un entorno de desarrollo adecuado, que incluya la instalación del SDK oficial de Anthropic y las herramientas necesarias para temporal, incluyendo el cliente, worker y definiciones de workflow. La secuencia típica implica crear los activities que definen las tareas individuales (crear batch, chequear estado, recuperar resultados), diseñar un workflow que coordine estas actividades y un worker que ejecute las tareas y se comunique con Temporal Server. A nivel de código, la estructura permite definir claramente las políticas de reintentos, tiempos máximos de espera y manejo de errores, manteniendo el código limpio y fácil de mantener. Temporal se encarga de toda la complejidad subyacente de la durabilidad y persistencia de estado, un factor que puede marcar la diferencia en sistemas en producción. Más allá de la implementación básica, hay espacio para futuras mejoras que pueden transformar aún más la eficiencia del sistema.

La implementación de mecanismos de caché y deduplicación de prompts para evitar repetir solicitudes idénticas puede llevar a ahorros adicionales de costos. Asimismo, construir paneles de gestión que exploten la API de Temporal para monitorear métricas de uso, costos y resultados es una opción altamente recomendada. Una estrategia avanzada también contempla la creación de sistemas de batching dinámicos, donde la agrupación de solicitudes se realiza en función de la prioridad, tamaño y tiempo de entrada, optimizando la metodología de envío a la API de lotes. Complementariamente, la integración con bases de datos para almacenar y consultar resultados, así como la adición de notificaciones automáticas fuera del pipeline principal, pueden formar parte de una arquitectura sólida para sistemas de IA a gran escala. Por último, es importante mencionar la relevancia de los mecanismos de validación robusta de las solicitudes para evitar que un lote entero se debilite por errores puntuales.

También, considerando que los resultados de los lotes permanecen accesibles durante aproximadamente 29 días, es crucial planificar la estrategia de recuperación y almacenamiento para evitar pérdidas de información. En conclusión, la combinación de la API de Lotes de Mensajes de Anthropic con Temporal se presenta como una solución ideal para empresas y desarrolladores que buscan aprovechar la IA a gran escala con eficiencia y fiabilidad. El enfoque asíncrono acompañado de un motor de workflows desarrollado para manejar fallas y reintentos simplifica la complejidad técnica al tiempo que reduce significativamente los costos operativos. En la medida en que la inteligencia artificial siga siendo una pieza fundamental en la innovación tecnológica, dominar estas herramientas y metodologías será clave para mantenerse competitivo y brindar soluciones escalables y sostenibles.