En el mundo actual de la gestión de datos, la velocidad y la eficiencia en la replicación son clave para mantener operaciones ágiles y competitivas. La integración entre bases de datos transaccionales como PostgreSQL y plataformas de almacenamiento analítico como Apache Iceberg es un proceso fundamental que requiere herramientas robustas y confiables. Recientemente, OLake, un conector open source desarrollado específicamente para replicar datos desde PostgreSQL a Iceberg, ha captado la atención por sus resultados en pruebas comparativas frente a alternativas reconocidas como Fivetran, Debezium, Estuary y Airbyte. OLake nace con la premisa de ofrecer un rendimiento excepcional en la replicación de datos, tanto en cargas iniciales completas como en captura de cambios en tiempo real (CDC, por sus siglas en inglés). Su enfoque open source y autoalojado permite a las organizaciones el control total sobre la infraestructura y los costos, un aspecto que resulta particularmente atractivo en proyectos de gran escala y larga duración donde las tarifas basadas en consumo pueden escalar rápidamente.

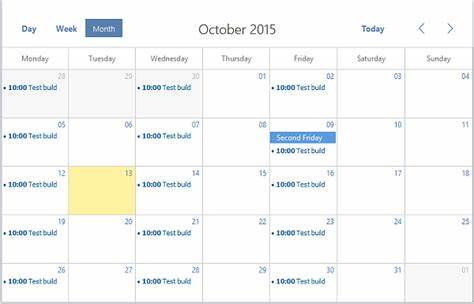

Uno de los aspectos sobresalientes de OLake es su capacidad para manejar enormes volúmenes de datos. En pruebas de carga inicial, donde se procesaron más de 4 mil millones de filas durante un periodo de 24 horas, OLake logró una tasa de transferencia promedio de aproximadamente 46,262 filas por segundo. Este desempeño es prácticamente equiparable al de Fivetran, un servicio comercialmente consolidado, que alcanzó 46,395 filas por segundo. Contrastando, Debezium, aunque popular en entornos de código abierto, mostró un rendimiento tres veces inferior, mientras que Estuary y Airbyte quedaron bastante rezagados, con proporciones de velocidad notablemente bajas y, en el caso de Airbyte, incluso enfrentando fallas en pruebas prolongadas. Las pruebas de captura de cambios en tiempo real refuerzan aún más la propuesta de valor de OLake.

Procesando 50 millones de cambios en apenas 22.5 minutos a una velocidad cercana a 37,000 filas por segundo, OLake superó significativamente a sus competidores. Fivetran, su rival más cercano en esta categoría, tardó aproximadamente 31 minutos, mientras que Debezium y Estuary necesitaron tiempos sustancialmente mayores, y Airbyte presentó un tiempo de procesamiento que alcanzó las 23 horas. Esta diferencia en latencia es crítica para empresas que requieren datos actualizados al instante para la toma de decisiones y análisis en tiempo real. El ahorro en costos es otro factor decisivo al elegir una solución para la replicación de datos.

OLake se beneficia de ser una solución open source que puede ser desplegada en infraestructura ya existente o en nubes públicas bajo demanda. Las pruebas se llevaron a cabo en una máquina virtual con recursos significativos, alcanzando un costo operativo de menos de 75 dólares por 24 horas. En comparación, el uso de los servicios comerciales de Fivetran, Estuary y Airbyte para manejar volúmenes equivalentes resultó en costos que oscilan desde miles hasta decenas de miles de dólares, tanto en cargas iniciales como en CDC. Aunque Estuary mostró un costo por fila muy competitivo en la prueba de captura de cambios, su rendimiento y capacidad para procesar grandes volúmenes en tiempo razonable se ven limitados, lo que puede traducirse en cuellos de botella y retrasos operativos. OLake, con su enfoque a infraestructuras gestionadas por el propio usuario, permite una combinación ideal entre rendimiento, costo y control granular sobre cada aspecto del flujo de datos.

La importancia de contar con herramientas propias y flexibles radica en la diversidad y complejidad creciente de los ecosistemas de datos modernos. La arquitectura abierta y la modularidad de Apache Iceberg facilitan la gestión eficiente de grandes bases de datos en entornos de data lakes y análisis avanzados. OLake, adaptándose a estas tendencias, es capaz de ofrecer una conexión fluida y optimizada desde el tradicional sistema transaccional PostgreSQL hacia entornos analíticos de última generación. Además, la comunidad open source y el ecosistema que se forma alrededor de soluciones como OLake permiten un ciclo continuo de mejoras, adaptaciones y soporte colaborativo. Esto contrasta con las plataformas propietarias, donde las mejoras dependen exclusivamente del proveedor y pueden estar sujetas a modelos de negocios rígidos o costosos.

En términos técnicos, OLake aprovecha optimizaciones específicas para maximizar la transferencia y procesamiento de datos, utilizando técnicas avanzadas de paralelismo y gestión de recursos que contribuyen a su superioridad en benchmarks y pruebas prácticas. Su capacidad para mantener la integridad y coherencia de los datos durante las operaciones de replicación añade una capa vital de confiabilidad para aplicaciones empresariales críticas. La transparencia en la documentación y el acceso directo a los resultados de los benchmarks permiten a los equipos técnicos evaluar con precisión la idoneidad de OLake para sus proyectos, facilitando una toma de decisiones informada basada en datos reales y medibles. Con la creciente necesidad de integración eficiente entre bases de datos transaccionales y plataformas analíticas escalables, soluciones como OLake representan un cambio significativo en cómo las organizaciones abordan sus estrategias de replicación y sincronización de datos. Su balance entre rendimiento, costo y apertura la posiciona como una opción cada vez más atractiva frente a alternativas tradicionales.

En conclusión, para quienes buscan replicar datos de PostgreSQL a Apache Iceberg, OLake ofrece una combinación inigualable de velocidad, costo y flexibilidad. El resultado es un conector capaz de manejar proyectos de gran escala con una eficiencia operativa sobresaliente y un costo controlado, todo dentro del marco de una solución open source que fomenta la innovación y la adaptabilidad. El futuro de la replicación de datos en entornos híbridos y de gran volumen parece inclinarse hacia herramientas como OLake, que integran lo mejor del desarrollo colaborativo con la potencia de procesamiento necesaria para desafíos cada vez mayores. Para empresas, desarrolladores y arquitectos de datos, mantener un ojo en esta tecnología emergente puede marcar la diferencia entre un sistema eficiente y uno obsoleto en un mercado cada vez más competitivo y exigente.

![How China's Air Defence Let Pakistan Down? Full Analysis [video]](/images/19FDF511-EC24-46F0-A56D-FFCDE3750FEA)