En el mundo de la ingeniería de software, uno de los mayores desafíos sigue siendo la desconexión palpable entre el entorno controlado de desarrollo y la compleja, impredecible y a menudo caótica realidad de producción. Cada ingeniero que ha estado alguna vez de guardia sabe que los problemas que surgen en producción no siempre tienen una explicación sencilla o un historial claro en las pruebas realizadas previamente. Esta distancia entre la teoría y la práctica lleva a la inevitable pregunta: ¿y si en lugar de solo escribir código y realizar pruebas tradicionales, nos adaptáramos a un enfoque donde el motor de la simulación guíe toda la creación y validación del software? El desarrollo impulsado por simulación (Simulation-Driven Development, o SDD) surge como una respuesta innovadora a la complejidad inherente a los sistemas distribuidos y la naturaleza variable del mundo real. Para comprender la importancia de adoptar un enfoque impulsado por simulación, primero debemos analizar la brecha que existe entre los entornos de desarrollo y producción. En el desarrollo, los escenarios están cuidadosamente diseñados para que las pruebas se ejecuten en condiciones ideales: entornos limpios, dependencias controladas y cargas moderadas.

Sin embargo, en producción, los sistemas enfrentan fallos imprevisibles, cargas fluctuantes, actores externos con comportamientos inesperados y la presión constante del tiempo real. Es como aprender a conducir en un circuito cerrado y luego lanzarse al tráfico intenso de una autopista en hora punta. Esta disparidad es la raíz de muchos errores que solo se manifiestan durante incidentes reales. El coste de ignorar esta realidad es elevado, especialmente en aplicaciones distribuidas, donde la interacción entre nodos, la latencia de red y las condiciones de fallo no lineales pueden desencadenar errores sutiles y difíciles de reproducir. Por ejemplo, en un clúster grande como Apache Hadoop, una partición en la red puede provocar un estado inconsistente que termine paralizando el sistema al intentar reanudarse, como un famoso incidente que obligó a parchear y redistribuir códigos en pleno incidente, algo caótico y peligroso para la estabilidad del servicio en curso.

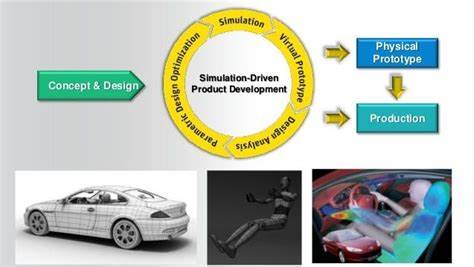

Frente a este reto, las pruebas convencionales se revelan insuficientes. La multiplicidad de variables —tipos de usuarios, métodos de pago, estados del inventario, opciones de entrega, monedas y promociones— generan tensiones combinatorias que hacen inviable cubrir todos los caminos con pruebas tradicionales. El número de casos de prueba crece de forma exponencial, y las combinaciones que provocan fallos pueden pasar inadvertidas hasta que el sistema está en producción, con consecuencias a menudo costosas. Para abordar esta complejidad, el desarrollo impulsado por simulación propone una metodología sistemática que se base en pruebas determinísticas con simulaciones que reflejen escenarios tanto de usuarios como del entorno. La clave está en crear un sistema donde todas las interacciones, ya sean internas o de red, se gestionen dentro de un aparato simulado único que elimina la dependencia de infraestructura externa, pero mantiene un alto grado de realismo en la interacción entre componentes.

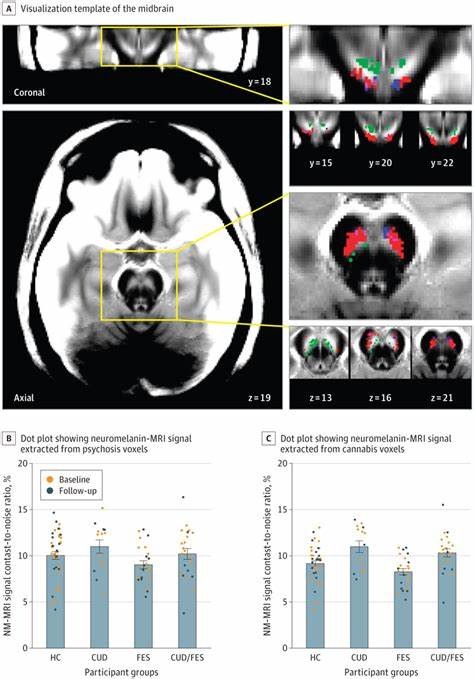

Una de las herramientas que dan vida a esta estrategia es la simulación determinística, que funciona con un ciclo de eventos controlado y reproducible, facilitando la depuración al garantizar que cada fallo pueda volver a reproducirse exactamente bajo las mismas condiciones. Esto soluciona uno de los mayores dolores en sistemas distribuidos: el error intermitente que ocurre sólo bajo circunstancias muy específicas e incontrolables. El enfoque de SDD también incorpora técnicas avanzadas de generación de pruebas, como el testing basado en propiedades, que permite a los desarrolladores crear casos de prueba con entradas aleatorias y validaciones automáticas de propiedades invariantes del sistema. En lugar de definir escenarios concretos, se generan una multitud de variaciones automáticas que ejercitan el sistema contra condiciones desconocidas o potencialmente dañinas. Esto beneficia desde pruebas unitarias hasta integraciones a gran escala, propiciando la detección temprana de errores y excepciones difíciles.

Pero la simulación no se limita a los usuarios; también se extiende a la simulación del “mundo” que afecta el sistema. Aquí es donde la inyección de caos toma protagonismo, al transformar el entorno simulado en uno lleno de incertidumbres reales como fallos en la red, latencias, desconexiones, sobrecargas, límites en dependencias externas e incluso comportamientos erráticos del hardware. Al practicar con fallos inducidos, los ingenieros pueden anticipar las condiciones adversas que de otro modo solo descubrirían bajo presión en producción. Este enfoque es particularmente valioso para sistemas construidos desde el inicio con intención de simular, ya que les concede control completo sobre el orden de ejecución, la planificación de tareas y las operaciones de entrada/salida. Algunos lenguajes como Rust ofrecen ventajas técnicas que facilitan la creación de estos sistemas simulados complejos gracias a ejecutores virtuales y control granular del hilo de ejecución, en contraste con las limitaciones que se enfrentan en entornos basados en máquinas virtuales como Java.

Sin embargo, esto no significa que proyectos ya existentes queden fuera de este paradigma. La estrategia también puede integrarse parcialmente mediante capas de abstracción, mocks inteligentes y simulaciones parciales. Por ejemplo, al simular un cliente HTTP que aleatoriamente devuelve errores o introduce retardos, se puede observar cómo reacciona la aplicación frente a fallos externos, ganando intuición y robustez sin necesidad de un rediseño completo. Varias empresas pioneras empiezan a implementar esta filosofía en sus procesos. Clever Cloud, por ejemplo, utiliza simulaciones intensivas sobre FoundationDB para su producto serverless Materia KV, ejecutando pruebas que simulan particiones aleatorias de red o reinicios de máquinas, lo que equivale a someter el sistema a las condiciones más extremas posibles durante horas de forma continua y reproducible.

Esta práctica no solo fortalece el producto, sino que genera un ambiente donde los desarrolladores aprenden y adquieren experiencia realista sin las consecuencias negativas del caos en producción. Desde la educación de los desarrolladores hasta la confianza en la calidad del software desplegado, el desarrollo impulsado por simulación redefine lo que significa probar una aplicación distribuida. Se aleja de la prueba puntual y estática para adoptar una visión dinámica, continua y basada en escenarios reales, a menudo imprevisibles, que moldean el comportamiento final del software. En última instancia, la adopción de esta metodología ayuda a cerrar la brecha entre Software Engineers y Site Reliability Engineers. Al permitir a los desarrolladores experimentar y comprender las complejidades y fallos que tradicionalmente sólo enfrentaban los equipos de operación, se promueve una cultura de colaboración y comprensión mutua, mejorando la resiliencia de los sistemas y reduciendo las alarmas nocturnas y parches de emergencia.

El llamado a cambiar hacia una era donde la simulación conduzca el desarrollo no es solo técnico sino cultural. Se trata de reconocer que el entorno de producción con todo su caos y presión no es un accidente sino la realidad indispensable para la que construimos. Rechazar esta realidad significa aceptar sorpresas costosas y fallos invisibles. Al hacerlo, ganamos no solo software más robusto sino equipos más preparados, satisfechos y confiados. El desarrollo impulsado por simulación abre una puerta al futuro de la ingeniería de software, donde la complejidad y la incertidumbre del mundo real se convierten en herramientas para mejorar, no en amenazas a evitar.

Adoptar esta práctica es invertir en calidad, en confianza y en la capacidad real de construir sistemas que resistan las tormentas del entorno productivo, con todas sus imperfecciones y desafíos. Un futuro donde la madrugada deje de sonar el teléfono del ingeniero con malas noticias puede estar más cerca gracias a la potencia de la simulación y la determinación para aprender de sus enseñanzas.