En el dinámico mundo de la inteligencia artificial, la convergencia entre el procesamiento de imágenes y el lenguaje natural ha cobrado cada vez mayor relevancia. Los modelos visuales multimodales (VLMs, por sus siglas en inglés) han emergido como protagonistas en esta evolución, abriendo nuevas posibilidades para la interpretación y análisis de datos complejos. Sin embargo, con la creciente oferta de modelos y tecnologías, surge la necesidad de contar con herramientas precisas y accesibles que permitan evaluar su desempeño en situaciones del mundo real. Es aquí donde Vision AI Checkup se presenta como una solución innovadora y transformadora. Vision AI Checkup actúa como un “optometrista” para los modelos de lenguaje visual, brindando una evaluación exhaustiva basada en una variedad amplia de tareas y escenarios prácticos.

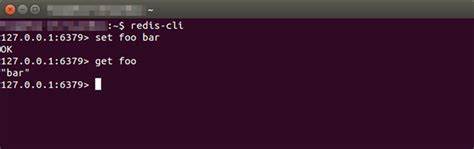

A diferencia de otros benchmarks tradicionales que pueden complicarse con miles de datos y métricas poco transparentes, esta plataforma ofrece un enfoque claro, sencillo y continuo que permite a desarrolladores, investigadores y usuarios comprender con facilidad el rendimiento de cada modelo en diferentes contextos. La esencia de Vision AI Checkup radica en su capacidad para adaptarse y evolucionar al incorporar nuevos modelos y tareas. Cada vez que un modelo se añade al leaderboard —una especie de ranking donde se comparan los resultados— se somete a un conjunto riguroso de pruebas basadas en decenas de imágenes y preguntas integradas. Estas preguntas están diseñadas para evaluar habilidades específicas de interpretación visual combinada con comprensión textual, tales como reconocer objetos, describir detalles precisos o interpretar información codificada en imágenes. Lo que distingue a esta plataforma es la diversidad y realismo de las tareas que presenta.

Los prompts, o indicaciones que se utilizan para poner a prueba a los modelos, abarcan desde preguntas simples como “¿Está rota la montura de las gafas?” hasta consultas más complejas que requieren medir dimensiones o identificar números de serie. Esta variedad asegura que el desempeño no se limite a un solo tipo de habilidad, sino que se evalúe de manera integral y se refleje mejor la capacidad práctica de cada modelo. Actualmente, la leaderboard de Vision AI Checkup incluye más de veinte modelos multimodales reconocidos, destacándose nombres como OpenAI O4 Mini, ChatGPT-4o y GPT-4.1 Mini. Los puntajes reflejan la precisión y la rapidez con la que cada modelo responde a los prompts, proporcionando una visión equilibrada entre exactitud y eficiencia.

Esta información es esencial para quienes buscan seleccionar el modelo más adecuado para aplicaciones específicas, ya sea en investigación, desarrollo de productos o soluciones empresariales. Además, la plataforma adopta un enfoque comunitario que fomenta la colaboración y la mejora constante. Al ser de código abierto, permite que desarrolladores y usuarios interesados contribuyan con nuevos prompts, ampliando así el alcance y la profundidad de las evaluaciones. Esta dinámica no solo enriquece la base de datos de pruebas, sino que también impulsa la innovación y la transparencia en el campo de la inteligencia artificial multimodal. La importancia de Vision AI Checkup trasciende su función técnica.

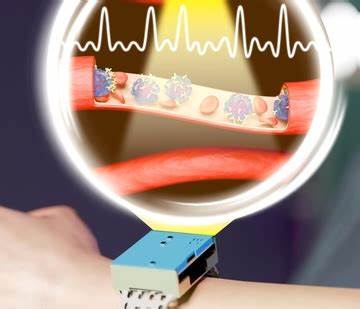

En un contexto donde los modelos AI son cada vez más integrados en aplicaciones cotidianas —desde asistentes virtuales hasta herramientas de diagnóstico visual— es imprescindible contar con mecanismos que garanticen su confiabilidad y precisión. La evaluación constante y objetiva que ofrece esta plataforma ayuda a identificar fortalezas y áreas de mejora, contribuyendo a un desarrollo responsable y orientado a resultados reales. Sumado a esto, Vision AI Checkup permite a los usuarios experimentar con distintos modelos de manera sencilla para comparar sus capacidades, facilitando decisiones informadas para proyectos específicos. Esto resulta especialmente útil para desarrolladores que enfrentan desafíos prácticos, como la interpretación de imágenes médicas, la automatización de procesos industriales o la mejora de interfaces de usuario inteligentes. Otra característica relevante es la velocidad promedio con la que cada modelo responde a las pruebas, un indicador clave para aplicaciones donde el tiempo es crítico.

Modelos como Llama 4 Maverick 17B, que responden en pocos segundos, pueden ser preferidos para escenarios que requieren rapidez sin sacrificar precisión. Este balance entre rendimiento y eficiencia se vuelve fundamental en la adopción comercial de tecnologías de vanguardia. En definitiva, Vision AI Checkup constituye un hito en la evaluación de modelos multimodales al proporcionar un sistema accesible, realista y en constante evolución. Su enfoque integral y transparente acerca a la inteligencia artificial multimodal a un uso más eficaz y confiable, democratizando la comprensión y el acceso a tecnologías avanzadas. La posibilidad de contribuir y formar parte activa de esta iniciativa convierte a Vision AI Checkup en una plataforma dinámica que no solo mide capacidades, sino que también impulsa el crecimiento conjunto de la comunidad AI.

El futuro de la inteligencia artificial pasa por la integración fluida entre visión y lenguaje, y herramientas como Vision AI Checkup serán clave para garantizar que esta integración se realice con calidad y responsabilidad. En un mundo donde la información visual se multiplica y los modelos deben interpretar datos cada vez más complejos, contar con un socio confiable que actúe como “optometrista” se vuelve indispensable para optimizar tecnologías, mejorar aplicaciones y alcanzar nuevos niveles de innovación. La transparencia, colaboración y precisión que ofrece esta plataforma son un claro ejemplo de cómo la inteligencia artificial puede desarrollarse de manera ética y eficiente, abriendo caminos hacia soluciones más inteligentes y humanas.