En los últimos años, la llegada y el desarrollo acelerado de la inteligencia artificial (IA) han comenzado a transformar profundamente múltiples sectores, desde la medicina hasta la educación y la industria tecnológica. Sin embargo, esta revolución también ha abierto nuevas puertas para actores malintencionados que buscan explotar estas herramientas para fines delictivos, especialmente en el ámbito de la ciberseguridad. Uno de los campos más afectados y que está experimentando una metamorfosis significativa es la ingeniería social, donde la IA potencia la capacidad de los atacantes para engañar y manipular a las personas, originando un cambio radical en el panorama de amenazas cibernéticas. La ingeniería social siempre ha sido una de las tácticas preferidas por los ciberdelincuentes debido a su efectividad para vulnerar sistemas mediante la manipulación psicológica de individuos. Este tipo de ataques aprovechan la confianza, la ignorancia o la distracción de las personas para lograr accesos no autorizados, robo de información sensible o instalación de malware.

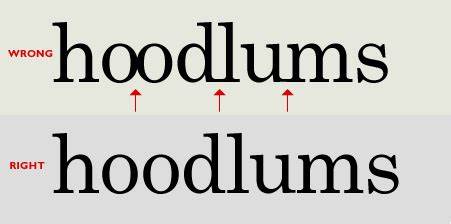

Sin embargo, estas técnicas tradicionalmente requerían un esfuerzo significativo en crear mensajes persuasivos, personalizar las aproximaciones y administrar la distribución de contenidos maliciosos. Con la irrupción de sistemas avanzados de IA, especialmente los modelos de lenguaje natural a gran escala, estos procesos pueden automatizarse y escalarse de manera exponencial. Los modelos de lenguaje como GPT-4 son capaces de generar textos coherentes, naturales y específicos que pueden adaptarse a cualquier contexto o audiencia. Esto significa que un atacante puede instruir una IA para investigar a una persona o grupo objetivo, recopilar información pública disponible y luego elaborar un correo electrónico o un mensaje que parece completamente legítimo y personalizado. La capacidad de estos sistemas para ajustar el mensaje y optimizar su impacto, además de evitar filtros antispam o coincidir con momentos sensibles como fechas límite fiscales, incrementa notablemente la probabilidad de que el destinatario caiga en la trampa.

Este nivel de automatización, que puede reducir los costos de operación hasta en un 99 %, elimina la tradicional disyuntiva entre calidad y economía en campañas de phishing. Por tanto, no solo aumenta la cantidad de ataques, sino que mejora su calidad y dificultad para ser detectados, ampliando el alcance potencial de las operaciones maliciosas. Por si fuera poco, la facilidad con la que se pueden burlar las barreras de protección implementadas en los modelos de IA, a través de técnicas como jailbreak o versiones locales sin controles de seguridad, facilita que tanto delincuentes organizados como principiantes tengan acceso a estas tecnologías para llevar a cabo sus engaños. La proliferación de IA en manos de actores estatales también ha elevando las apuestas en la esfera geopolítica. Agrupaciones persistentes avanzadas (APT) procedentes de países como Rusia, Corea del Norte, Irán o China han experimentado con estas tecnologías para fortalecer sus capacidades de espionaje y ataque.

Mientras que las técnicas tradicionales exigen un trabajo intenso de recopilación y análisis de información, la IA acelera y amplifica estos procesos, eliminando barreras como el dominio de idiomas extranjeros y generando comunicaciones que pueden engañar incluso a expertos especializados. Un claro ejemplo radica en el grupo norcoreano Kimsuky, que aprovecha la ingeniería social potenciada por IA para dirigrse de manera más eficiente y masiva a especialistas en políticas internacionales relacionados con el programa nuclear norcoreano. En lugar de horas de investigación manual, ahora es posible crear listados detallados y enviar correos electrónicos personalizados que contienen cargas maliciosas adjuntas. Este tipo de ataques no solo son ejecutados con mayor rapidez, sino que también resultan más difíciles de detectar y prevenir. Además del texto, la inteligencia artificial avanzó a la generación de contenidos audiovisuales falsificados que complementan y fortalecen estos ataques.

Los deepfakes —videos o audios fabricados para imitar a personas reales con alta fidelidad— permiten a los atacantes simular entrevistas de trabajo o reuniones con objetivos fraudulentos, superando prácticas comunes de verificación como las entrevistas por video. En el pasado, las deficiencias en idiomas o la ausencia de interacción en tiempo real eran indicios para detectar fraudes; sin embargo, la IA dificulta cada vez más estas precauciones, poniendo en jaque las medidas de seguridad que antaño eran consideradas confiables. Las consecuencias de este aumento en la sofisticación de la ingeniería social son graves y van mucho más allá del mundo digital. Por un lado, se espera que los grupos de ransomware eleven su volumen de ataques, resultando en pérdidas económicas millonarias y una mayor disrupción social. Por otro, estos métodos potencian ataques de espionaje industrial y militar, fortaleciendo a estados y organizaciones que utilizan estas tácticas para obtener ventajas competitivas o socavar adversarios.

El caso particular de Corea del Norte es paradigmático, dado que los ingresos obtenidos en el último año mediante cibercrimen y fraudes con criptomonedas financian directamente su programa de armas de destrucción masiva, representando una amenaza directa para la seguridad internacional. A pesar del panorama desafiante, existen ciertas limitaciones técnicas en las capacidades actuales de IA. Por ejemplo, muchos modelos no cuentan con acceso en tiempo real a información actualizada, lo que puede originar errores en la generación de contenidos o la selección de objetivos. También, las barreras internas a la explotación de estas tecnologías pueden disuadir a algunos atacantes menos determinados y los sistemas defensivos aún tienen capacidad para detectar ciertos patrones característicos del contenido generado artificialmente. La respuesta para mitigar esta nueva ola de amenazas debe ser integral y multidimensional.

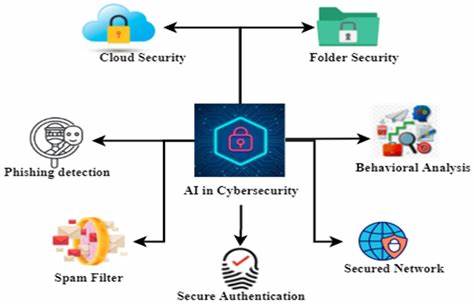

En primer lugar, tanto organizaciones públicas como privadas pueden emplear la misma inteligencia artificial para fortalecer sus defensas. Investigaciones recientes demostraron que los modelos de lenguaje pueden ser entrenados para identificar correos electrónicos de phishing con mayor precisión y eficacia que los humanos, reduciendo falsos positivos y automatizando revisiones. Estas herramientas también pueden instruir a los usuarios sobre cómo proceder en situaciones sospechosas, fomentando prácticas de verificación adicionales como llamadas telefónicas para validar solicitudes sensibles. La personalización de filtros antispam basados en los hábitos individuales de los usuarios también representa un campo prometedor. Por otro lado, es fundamental que los gobiernos impulsen regulaciones claras y robustas sobre las empresas que desarrollan y distribuyen tecnologías de IA, estableciendo obligaciones estrictas para realizar auditorías de seguridad periódicas y transparentar sus resultados.

La responsabilidad legal frente a abusos derivados del uso malicioso de estas plataformas debe estar bien definida. Organismos regulatorios deben fortalecer los requerimientos en materia de capacitación anti phishing y la incorporación de tecnologías de seguridad basadas en IA en entidades críticas. A nivel internacional, la cooperación será imprescindible para confrontar la amenaza global que implica la ingeniería social potenciada por inteligencia artificial. Espacios multilaterales como las Naciones Unidas o iniciativas sectoriales como la Iniciativa Contra el Ransomware pueden ampliar sus ámbitos de actuación para incluir la prevención y respuesta a este tipo de ataques. Establecer estándares regulatorios comunes que regulen el desarrollo y uso de IA con implicancias en la ciberseguridad servirá para limitar el acceso indiscriminado a estas herramientas a actores hostiles.

En conclusión, el papel transformador que la inteligencia artificial está jugando en la ingeniería social representa un desafío sin precedentes para la seguridad cibernética mundial. La capacidad para generar engaños hiperrealistas de manera automatizada no solo aumenta la frecuencia de los ataques, sino también su complejidad e impacto en múltiples ámbitos. La adaptabilidad de este fenómeno exige respuestas innovadoras, coordinadas y basadas en el aprovechamiento ético de la misma tecnología que los atacantes emplean. Sin un compromiso decidido de gobiernos, sector privado y sociedad civil, el riesgo de que la ingeniería social potenciada por IA exacerbe las vulnerabilidades digitales y físicas seguirá en aumento, con consecuencias que pueden afectar la estabilidad económica, política y social a escala global.