La inteligencia artificial (IA) ha emergido como una herramienta transformadora para las empresas en todo el mundo. Los agentes de IA, en particular, están cambiando la forma en que las organizaciones interactúan con sus clientes, automatizan procesos y toman decisiones en tiempo real. Sin embargo, junto con estos beneficios vienen riesgos significativos que no pueden ser ignorados. La seguridad de los agentes de IA se ha convertido en una prioridad para evitar que actores maliciosos comprometan la integridad, privacidad y operación de los sistemas empresariales. Los agentes de IA son programas autómatas diseñados para realizar tareas específicas o actuar en nombre de usuarios.

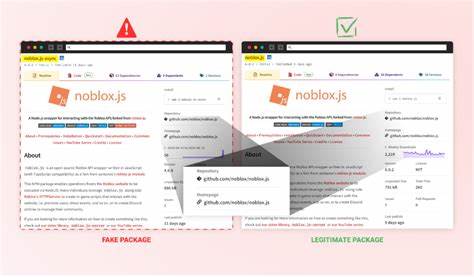

A diferencia de los chatbots convencionales o aplicaciones tradicionales, estos agentes pueden procesar grandes volúmenes de datos, adaptarse a contextos cambiantes e incluso aprender del entorno, ofreciendo respuestas personalizadas y automatización avanzada. Su capacidad para manejar información sensible y tomar decisiones automatizadas los convierte en blancos atractivos para ataques de ciberseguridad. Uno de los principales riesgos asociados con los agentes de IA es la posibilidad de filtración de datos. Dado que estos agentes trabajan con información confidencial, desde detalles personales hasta datos financieros, cualquier brecha puede tener consecuencias devastadoras para la privacidad de los clientes y la reputación de la empresa. Además, los hackers pueden manipular estos modelos para difundir información errónea o alterar su comportamiento.

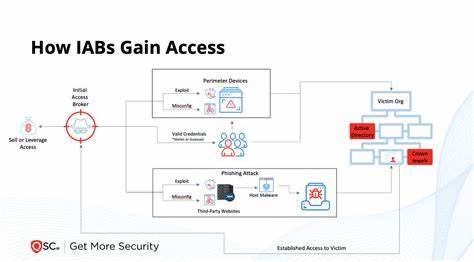

Estos escenarios subrayan la urgente necesidad de implementar medidas de seguridad robustas. El ataque adversarial es una de las amenazas más sofisticadas que enfrentan los agentes de IA. Los hackers pueden diseñar entradas maliciosas que engañan a los modelos para que tomen decisiones incorrectas o revelen datos protegidos. Este tipo de vulnerabilidad exige un enfoque proactivo en la validación y supervisión continua del desempeño de los agentes para detectar patrones anómalos y responder a incidentes a tiempo. La protección de la identidad es otro aspecto crítico.

Los agentes de IA suelen interactuar con múltiples sistemas y usuarios, lo que genera porosidades en las credenciales y accesos. La creación de identidades digitales ocultas o mal gestionadas puede ser explotada para infiltrar redes y robar información. Por ello, las empresas deben adoptar estrategias de seguridad basadas en la identidad con múltiples capas de autenticación y autorización, minimizando así los riesgos de acceso no autorizado. En cuanto a la defensa, la implementación de controles rigurosos sobre los datos que manejan los agentes de IA es fundamental. Esto incluye el cifrado de datos en tránsito y en reposo, la segmentación de redes para aislar sistemas críticos y la aplicación de políticas de gestión de riesgos actualizadas y orientadas a la IA.

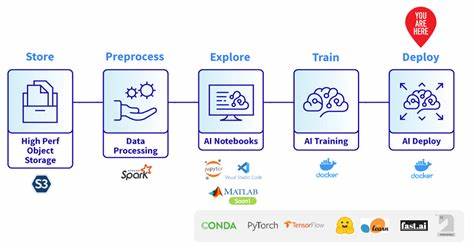

La formación del personal en ciberseguridad y la sensibilización sobre los posibles vectores de ataque también juegan un papel crucial para fortalecer la seguridad global. Herramientas y frameworks específicos para el aseguramiento de agentes de IA están en constante desarrollo. Estos recursos permiten analizar vulnerabilidades, detectar comportamientos desviados y aplicar medidas correctivas de manera automatizada. La integración de inteligencia artificial dentro de la propia estrategia de seguridad puede ofrecer ventajas competitivas, facilitando la detección temprana de amenazas y la respuesta rápida a incidentes. No debe considerarse la seguridad de los agentes de IA como un gasto, sino como una inversión estratégica que protege el valor de la empresa y su posición en el mercado.

La confianza de los usuarios, socios y clientes depende en gran medida de la capacidad de la organización para mantener sus sistemas a salvo. Por esta razón, tantas firmas reconocidas están priorizando webinars, talleres y formaciones especializadas para mantenerse actualizadas frente a las tácticas emergentes de los ciberdelincuentes. Otro aspecto a destacar es la regulación y cumplimiento normativo. Los negocios que emplean agentes de IA deben asegurarse de cumplir con las leyes de protección de datos y privacidad aplicables en sus jurisdicciones. Esto implica auditorías regulares, políticas claras sobre el uso de la IA y transparencia hacia los usuarios sobre qué datos se recopilan y cómo se protegen.

La falta de cumplimiento puede acarrear sanciones económicas y daños irreparables a la imagen corporativa. El futuro será cada vez más digital y automatizado, con agentes de IA desempeñando roles críticos en la toma de decisiones empresariales. Por ello, desarrollar una cultura organizacional que valore la seguridad desde el diseño y fomentarla durante todo el ciclo de vida de los agentes es esencial para mitigar riesgos. La implementación de buenas prácticas, actualización constante de protocolos y vigilancia activa del entorno tecnológico deben ser pilares fundamentales. En conclusión, desplegar agentes de inteligencia artificial en un entorno empresarial trae consigo beneficios indudables, pero también exige una responsabilidad gigantesca.

Entender las amenazas específicas que enfrentan estos sistemas y adoptar un enfoque integral de seguridad permitirá que las empresas aprovechen el potencial de la IA sin exponerse a ataques devastadores. Invertir en conocimiento, herramientas avanzadas y en un equipo capacitado contribuirá a blindar las operaciones y a mantener la confianza en un mercado cada vez más competitivo y desafiante.