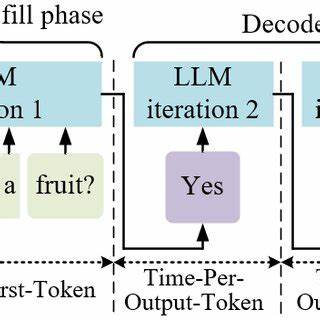

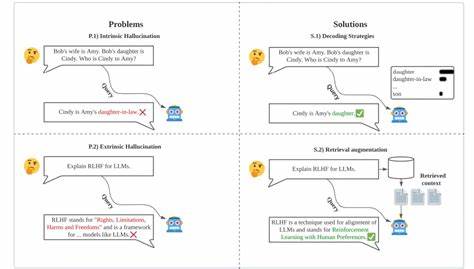

En la era digital actual, la inteligencia artificial avanza a pasos agigantados, y dentro de esta revolución, los modelos de lenguaje a gran escala (LLM) juegan un papel fundamental para transformar diversas industrias, desde la atención al cliente hasta el análisis de datos. Sin embargo, a medida que se incrementa la adopción de estos modelos, también surgen enormes preocupaciones en torno a la privacidad y la seguridad de los datos utilizados durante la inferencia. La necesidad de proteger la información sensible sin sacrificar la calidad del rendimiento ha impulsado el desarrollo de soluciones de inferencia privada y confiable, donde Tinfoil se posiciona como un referente innovador en este campo. La inferencia de modelos de lenguaje a gran escala requiere un entorno tecnológico robusto que asegure la integridad y confidencialidad de la información procesada. Tradicionalmente, cuando los desarrolladores o empresas utilizan APIs para acceder a modelos LLM alojados en la nube, se enfrentan al desafío de enviar datos potencialmente confidenciales a servidores externos.

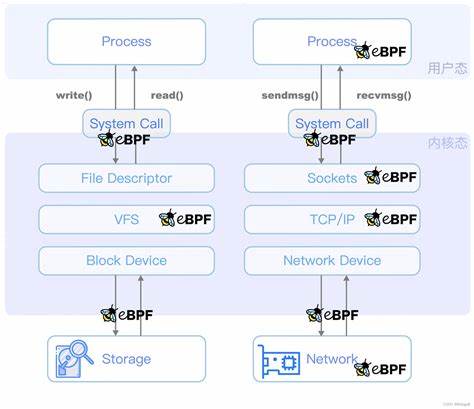

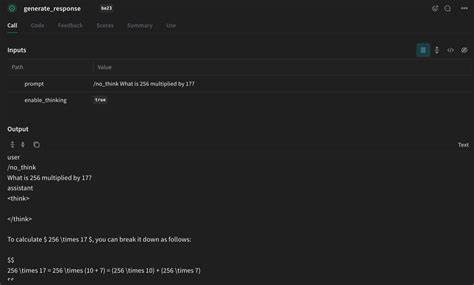

Este proceso representa riesgos inherentes, como la interceptación no autorizada, manipulación de datos o incluso el acceso indebido desde el lado del proveedor del servicio. Para abordar esta problemática, Tinfoil presenta una arquitectura de inferencia que garantiza seguridad end-to-end durante todo el proceso. Una de las características más sobresalientes de Tinfoil es su compatibilidad total con el estándar OpenAI Chat Completions API, lo que facilita la integración para los desarrolladores que ya están familiarizados con las herramientas y flujos de trabajo de OpenAI. Esta compatibilidad significa que la transición a una infraestructura más segura no requiere la reescritura completa del código, permitiendo que las empresas mantengan sus sistemas actuales y, al mismo tiempo, eleven el nivel de protección para sus usuarios y datos. La seguridad en Tinfoil se mantiene a través de enclaves de cómputo verificables, señas arquitectónicas que garantizan que la ejecución del modelo se lleva a cabo en un entorno protegido y aislado.

La tecnología verifica automáticamente que el enclave no ha sido comprometido antes de procesar cualquier solicitud, bloqueando cualquier intento de acceso si la integridad del enclave falla. Esto implica que incluso proveedores de servicios en la nube o actores malintencionados no pueden acceder a los datos durante la inferencia, ofreciendo una capa adicional de protección que hoy en día es imprescindible en sectores sensibles como la salud, finanzas o defensa. En cuanto al rendimiento, Tinfoil no sacrifica velocidad ni capacidad. Por el contrario, soporta modelos avanzados y de alta dimensión, como DeepSeek R1 70B, un modelo de razonamiento de alto rendimiento basado en Llama Distill que cuenta con 70.6 mil millones de parámetros y un largo contexto de 64k tokens.

Este tipo de modelo es ideal para tareas complejas de procesamiento de lenguaje que requieren comprensión profunda y contexto extenso, tales como análisis de texto avanzado, generación de contenido o soporte inteligente en sistemas de conversación. Además, Tinfoil ofrece una variedad de modelos que destacan por sus capacidades especializadas. Por ejemplo, el modelo Mistral Small 3.1 24B es una alternativa avanzada multimodal con funciones ampliadas de visión y contexto, lo que permite trabajar con distintos tipos de datos combinados como texto e imágenes. A su vez, el Llama 3.

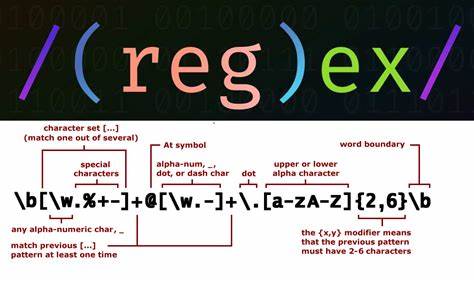

3 70B se orienta a aplicaciones que requieren multilingüismo y razonamiento sofisticado, siendo adecuado para empresas globalizadas que manejan múltiples idiomas. Otros modelos, como Llama Guard 3 1B, están diseñados específicamente para seguridad y moderación de contenido, asegurando que la generación de texto cumpla con políticas éticas y regulatorias. La facilidad de uso de Tinfoil se refleja también en la flexibilidad de su cliente, el cual está disponible en múltiples lenguajes de programación populares como Python, Node.js, Swift y Go. Esto favorece la adopción en distintos tipos de proyectos y plataformas, desde aplicaciones móviles hasta soluciones backend en la nube.

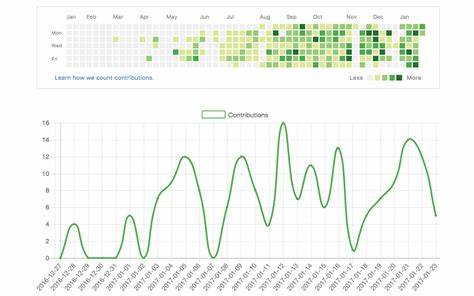

La instalación mediante paquetes estándar y la simplicidad para hacer llamadas de inferencia vía API constituyen un gran avance para reducir la barrera técnica hacia la adopción de tecnologías de inferencia privadas. Un aspecto esencial para las empresas es la transparencia y verificación continua durante la operación. Tinfoil ofrece controles automáticos que bloquean solicitudes si la integridad del enclave no puede ser comprobada en tiempo real. Esta característica no solo permite proteger la privacidad, sino que genera confianza en el uso de inteligencia artificial para aplicaciones críticas. El cumplimiento normativo, cada vez más exigente en materia de protección de datos, se beneficia de esta tecnología capaz de proporcionar auditorías y garantías sólidas de seguridad.

A medida que las aplicaciones de inteligencia artificial continúan expandiéndose, la importancia de contar con una infraestructura confiable para la inferencia privada de LLM se vuelve evidente. Ya no es suficiente tener modelos potentes si no se puede garantizar que los datos permanecen seguros y sin exposición a terceros. Soluciones como las que ofrece Tinfoil posicionan a la industria al frente de la innovación, permitiendo que empresas de todos los sectores adopten la IA avanzada sin sacrificar la privacidad ni la confianza. En resumen, la inferencia privada de modelos de lenguaje a gran escala es un componente crítico para el futuro de la inteligencia artificial responsable y efectiva. Tecnologías como la de Tinfoil establecen un nuevo estándar al combinar rendimiento, seguridad y compatibilidad técnica.

Estas innovaciones no solo protegen los datos sensibles que alimentan a los modelos, sino que también facilitan la integración sencilla gracias a su compatibilidad con los estándares de APIs líderes del mercado. El impacto en sectores clave será significativo, desde salud, finanzas y legal hasta comercio y atención al cliente, donde la necesidad de procesar información confidencial sin riesgo es vital. Implementar soluciones de inferencia privada acelera la confianza del usuario y asegura que la inteligencia artificial puede ser una herramienta poderosa y segura, contribuyendo a la transformación digital con un enfoque ético y responsable. Para profesionales y empresas interesadas en incorporar estos avances, Tinfoil brinda la posibilidad de probar su tecnología mediante demos personalizadas y acceso a documentación detallada, lo que facilita la evaluación y adopción de esta plataforma de vanguardia. La integración de modelos como DeepSeek R1 70B y Mistral Small 3.

1 24B en ecosistemas con alta demanda de seguridad se convierte entonces en una realidad accesible y confiable. En definitiva, la inferencia privada end-to-end a través de herramientas como Tinfoil marca un hito para la inteligencia artificial, redefiniendo los parámetros de seguridad sin comprometer el rendimiento. La evolución hacia modelos de lenguaje seguros y verificables transforma la manera en que organizaciones y desarrolladores pueden aprovechar los beneficios de la IA con la tranquilidad de que sus datos y procesos están protegidos contra vulnerabilidades externas. La unión de innovación tecnológica y compromiso con la privacidad posiciona a Tinfoil y su ecosistema como líderes en un mercado que demanda soluciones robustas y transparentes para enfrentar los desafíos del futuro digital.