La vida a veces nos sorprende con lecciones inesperadas que trascienden los ámbitos en los que habitualmente creemos desempeñarnos. Un ejemplo fascinante es el aprendizaje que ofrece el estudio y la identificación de mosquitos, un proceso que, aparentemente, pocos relacionarían con el mundo de la informática y el diseño de algoritmos. Sin embargo, en medio de la rutina diaria en un laboratorio de entomología, puede surgir una analogía profunda y reveladora acerca de cómo diseñar algoritmos eficientes y adaptados a necesidades concretas. En este viaje, veremos cómo la observación y el trabajo con estas diminutas criaturas llevaron a cuestionar y mejorar métodos clásicos basados en estructuras computacionales, desafiando conceptos abstractos para aterrizarlos en la práctica cotidiana. Todo comenzó en el marco de un servicio nacional obligatorio, donde la tarea asignada consistía en “medicina preventiva” y “biodefensa”, eufemismos que en la realidad se tradujeron en monitorear y estudiar mosquitos.

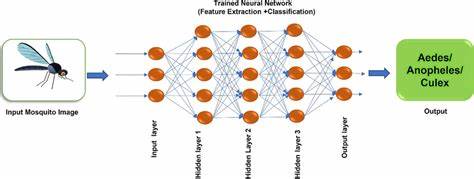

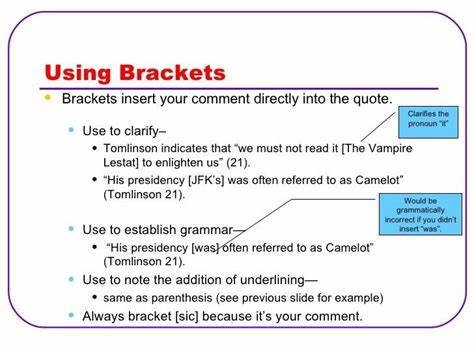

La labor no solo implicaba salir al campo para capturar ejemplares sino también identificarlos meticulosamente bajo un microscopio, tarea que parecía simple pero estaba lejos de serlo. La herramienta principal para esta identificación era una clave taxonómica dichotómica, una especie de árbol de decisiones que funcionaba mediante una serie de preguntas binarias de sí o no, diseñadas para terminar en una especie específica. Desde un punto de vista computacional, esta clave representaba un árbol binario “sesgado a la derecha”, lo que implicaba que en el peor de los casos se tenía que recorrer toda la lista de especies, es decir, el algoritmo de identificación tenía un coste lineal. En programación, como en teoría de algoritmos, este tipo de estructuras son conocidas por su ineficiencia en el peor escenario, y por eso, motivado por el conocimiento recién adquirido en clases de ciencias de la computación, surgió la idea de balancear este árbol para reducir su profundidad y, en consecuencia, su complejidad temporal a orden logarítmico. La solución implicó diseñar una clave policlave, un sistema que en cada paso permitía dividir el conjunto de especies posibles en varias ramas — no solo dos — y que en teoría reducían significativamente el número total de pasos necesarios para identificar un mosquito.

En la práctica, el cambio traía consigo la promesa de acelerar la identificación, liberar tiempo y hacer el proceso más eficiente. Sin embargo, pronto aparecieron los primeros desafíos que demostraron que la teoría no siempre se traduce directamente en la optimización práctica. Uno de los aprendizajes más importantes fue comprender que no todas las preguntas o pasos dentro del proceso tienen el mismo coste. Algunas preguntas eran sencillas y rápidas de responder, como observar si el probóscide del mosquito estaba doblado o recto, mientras que otras requerían manipulación delicada, ajuste de microscopios y podían llevar varios minutos por cada ejemplar. Este diferencial en costo operativo no se refleja en la sencilla medida de complejidad Big O, que asume cada paso con el mismo peso, sino que plantea la necesidad de ponderar también los costes reales y no solo los teóricos.

Asimismo, observar que la mayoría de los mosquitos que realmente se encontraban correspondían a unas pocas especies comunes llevó a otra conclusión reveladora: el diseño de la clave dichotómica original estaba optimizado para acelerar la identificación en la práctica, porque estas especies frecuentes se reconocían muy pronto, en apenas unos pasos. Esto significa que el peor caso, es decir, encontrar especies raras que tardan mucho en identificarse, era un evento poco común. De esta forma, el algoritmo, aunque lineal en el peor caso, era altamente eficiente para el 90% de los mosquitos que realmente importaba procesar rápido. Esta filosofía es la misma que rige en estructuras informáticas como las tablas hash, que aunque tienen un coste peor caso relativamente elevado, ofrecen tiempos promedio muy rápidos mediante el conocimiento del comportamiento predominante de los datos. Un aspecto igualmente fascinante que emerge de esta experiencia es la importancia del contexto y la escala.

Con un universo cerrado y limitado de especies, en el orden de 48 géneros, la diferencia entre un algoritmo de orden lineal y uno logarítmico no resulta tan significativa en términos absolutos. El tiempo y esfuerzo invertidos en diseñar un algoritmo óptimo para casos extremos no se traducía en una mejora tangible durante el trabajo rutinario. Aquí aparece el concepto del punto de cruce o crossover point en análisis de algoritmos, que señala en qué momento el crecimiento asintótico pasa a ser relevante. Para problemas pequeños o medianos, la sobrecarga constante, la complejidad añadida y otros factores pueden hacer que la solución «teóricamente» óptima no sea la mejor en la práctica. Además, literalmente observar cómo interactuar con la realidad de las muestras — el delicado movimiento para ajustar iluminación, la manipulación de insectos tan frágiles que pueden romperse o deformarse — llevó a entender que en la vida real muchos factores oxidan o afectan la eficiencia de un método que, en papel, parecía perfecto.

La analogía con la informática es clara: el coste de acceder a memoria, las pérdidas por acceso a caché, el impacto de punteros y estructuras dinámicas pueden hacer que operaciones con baja complejidad se vuelvan prohibidamente lentas en ejecución real si no se toman en cuenta esas variables. Este ejercicio también resalta la importancia de ir más allá del análisis puramente matemático y de prestar atención a los datos y patrones reales. En la identificación de mosquitos, entender cuáles especies aparecen con mayor frecuencia y qué preguntas pueden responderse con facilidad permite diseñar un algoritmo que funcione rápido para lo usual y reserve el esfuerzo para lo excepcional. Esta es una lección fundamental para cualquier desarrollador o científico de datos: optimizar para el caso común y aceptar las rarezas como un costo menor, dentro de un diseño integral. Finalmente, hay un valor intrínseco en la paciencia, la observación detallada y la experimentación, tanto en el laboratorio con los mosquitos como en la formulación y prueba de algoritmos.

La práctica enseña que los análisis secuenciales, la validación constante y la adaptación ante el terreno real son insustituibles. El conocimiento teórico, la abstracción, las grandes ideas y las fórmulas acompañan y guían, pero no bastan por sí solas. Y en esta tensión entre teoría y praxis se encuentran las oportunidades para mejorar, innovar y alcanzar resultados verdaderamente útiles. En conclusión, la experiencia de trabajar con mosquitos y tratar de mejorar la clave taxonómica para su identificación ofrece una metáfora perfecta para el diseño de algoritmos y la optimización en general. Nos recuerda que las soluciones deben ajustarse no solo a la teoría sino también al contexto, que el coste real de las operaciones puede diferir drásticamente del previsto y que el conocimiento profundo del uso habitual puede guiar a mejores decisiones.

Esta historia inesperada conecta dos mundos con una enseñanza valiosa: diseñar algoritmos no es solo buscar la menor complejidad asintótica, sino entender profundamente el problema, los datos y las variables que impactan en el rendimiento real, factores que solo se descubren con la experiencia y la observación directa.

![Presidential Task Force on Combating Antisemitism and Anti-Israeli Bias [pdf]](/images/0FB09318-E63D-45B9-AE7C-131725F425D0)