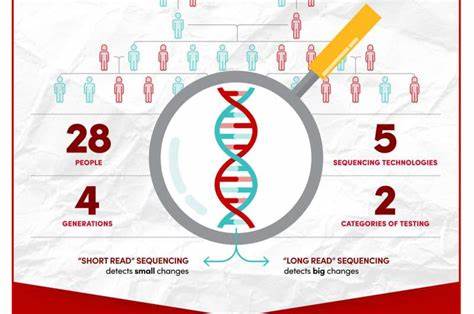

La inteligencia artificial ha experimentado avances impresionantes gracias a los modelos de lenguaje a gran escala (LLM), que requieren infraestructuras cada vez más avanzadas para su ejecución eficiente. En este contexto, vLLM ha surgido como una solución revolucionaria, diseñada para ofrecer un motor de inferencia y servicio con alta eficiencia y rendimiento. Su reciente incorporación como proyecto oficial bajo el paraguas de la Fundación PyTorch marca un hito importante que impulsa aún más el ecosistema de inteligencia artificial. vLLM fue creado por el equipo de la Universidad de California en Berkeley con la ambición de resolver los complejos desafíos asociados a la ejecución de LLMs, que pueden contar con cientos de miles de millones de parámetros. Con su innovador algoritmo PagedAttention y su capacidad para integrarse profundamente con PyTorch, vLLM ofrece una plataforma que no solo mejora la velocidad de respuesta, sino que también optimiza el uso de memoria para maximizar la eficiencia computacional.

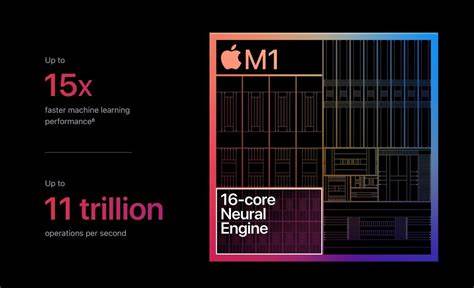

La decisión de la Fundación PyTorch de acoger vLLM como proyecto hospedado refleja la importancia estratégica y la creciente relevancia que tiene esta tecnología para la comunidad de desarrolladores y empresas que apuestan por la inteligencia artificial avanzada. Este vínculo institucional asegura que vLLM se beneficie de una gobernanza neutra, apoyo continuo para su mantenimiento y ampliación, y un compromiso firme con la transparencia y el desarrollo colaborativo abierto. Uno de los aspectos más destacados de vLLM es su amplia compatibilidad de hardware. Gracias a su integración con PyTorch, vLLM puede ejecutarse en una variedad de aceleradores y plataformas de computación, incluyendo GPUs de NVIDIA y AMD, TPUs de Google, CPUs y GPUs de Intel, así como aceleradores especializados como los HPUs de Intel Gaudi y AWS Neuron. Esta arquitectura flexible garantiza que los usuarios puedan desplegar sus modelos en diferentes entornos sin perder rendimiento ni funcionalidad.

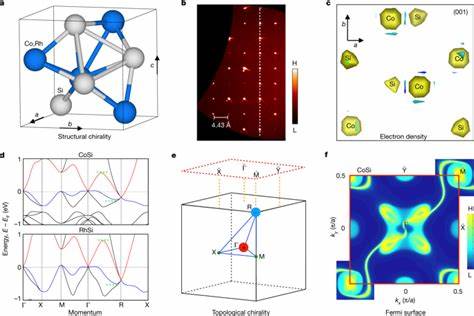

El motor vLLM soporta más de cien arquitecturas de modelos, incluyendo no solo modelos de texto, sino también aquellos con capacidades multimodales para procesamiento de imágenes y video. Además, permite la incorporación de arquitecturas especializadas, tales como sparse attention, Mamba, BERT, Whisper, y modelos dedicados a embeddings o tareas de clasificación. Esta versatility posiciona a vLLM como una herramienta indispensable para investigadores y desarrolladores que buscan acelerar la innovación en múltiples áreas del aprendizaje profundo. Más allá de su soporte extensivo para modelos y hardware, vLLM se distingue por su enfoque en optimizaciones técnicas que mejoran tanto la latencia como el rendimiento en escala. Algoritmos como la decodificación especulativa, el almacenamiento en caché de prefijos, la cuantización y la aceleración mediante CUDA graph contribuyen a reducir significativamente los tiempos de respuesta al generar textos, una ventaja crucial para aplicaciones en tiempo real.

Paralelamente, técnicas de paralelismo tensorial y en pipeline aseguran un throughput máximo, especialmente relevante para implementaciones a nivel empresarial. La integración con frameworks de aprendizaje por refuerzo desde retroalimentación humana (RLHF) resulta también un elemento diferenciador. Esta capacidad permite que modelos continúen mejorándose con base en la interacción y supervisión de usuarios, lo que es fundamental para el desarrollo de sistemas de IA cada vez más precisos y adaptativos. Con la acogida de vLLM, la Fundación PyTorch amplía su cartera de proyectos para incluir una tecnología que impulsa la adopción de PyTorch en un espectro diverso de hardware, fortaleciendo su posición como líder en la comunidad de inteligencia artificial. Esta colaboración implica que el equipo de PyTorch mejora constantemente elementos clave como torch.

compile y FlexAttention para optimizar la experiencia y el desempeño de vLLM. Asimismo, la sinergia con librerías nativas como TorchTune, TorchAO y FBGEMM refuerza la capacidad de los desarrolladores para construir soluciones personalizadas y altamente eficientes. Un punto trascendental de esta asociación es el soporte y mantenimiento a largo plazo que la Fundación PyTorch ofrece a vLLM. La garantía de contar con una comunidad activa, respaldada por una estructura de gobernanza abierta y profesional, favorece la evolución continua con lanzamientos frecuentes, incorporación de nuevas funcionalidades y atención a la seguridad. Este entorno produce un entorno de confianza para empresas que requieren despliegues robustos y confiables en producción.

El impacto de vLLM trasciende la comunidad técnica. Su capacidad para habilitar clusters de inferencia distribuidos con gestión inteligente del cache de claves y rutas optimizadas permite que organizaciones de cualquier tamaño puedan escalar sus sistemas IA sin comprometer eficiencia o control. Además, las estrategias para disgregar etapas de prefill y decodificación facilitan un reparto más fino de las cargas, mejorando el aprovechamiento de recursos y reduciendo costos. En cuanto a la comunidad, vLLM ha demostrado ser un proyecto dinámico y en constante expansión, acumulando más de 46,500 estrellas en GitHub y contando con más de 1,000 colaboradores. Este nivel de participación refleja el entusiasmo global por una herramienta que simplifica la complejidad que implica ejecutar LLMs a gran escala sin perder en calidad ni rendimiento.

La formación y recursos educativos también son parte integral del ecosistema que rodea a vLLM y PyTorch. Los desarrolladores tienen a su disposición documentación completa, tutoriales de diferentes niveles, y acceso a foros donde pueden resolver dudas y compartir conocimientos. Este apoyo promueve una adopción más amplia y una comunidad más inclusiva que acelera la innovación colectiva. Con la llegada al panorama oficial de la Fundación PyTorch, vLLM está posicionado para liderar la próxima generación de motores de inferencia para inteligencia artificial. Su diseño orientado a la eficiencia, flexibilidad y competencia técnica avanzada garantiza que su evolución continuará marcada por la excelencia, actualización constante y adaptación a nuevas tendencias del sector.

En definitiva, el proyecto vLLM abre un camino prometedor para quienes buscan ejecutar LLMs de manera escalable, rápida y penetrando una variedad de aplicaciones tanto industriales como académicas. Su integración con PyTorch y los recursos que eso implica convierten a vLLM en una referencia indispensable para el desarrollo de soluciones futuras en inteligencia artificial. La colaboración entre ambas comunidades ofrece un futuro en el que los límites de la computación y el modelado inteligente se expanden hacia nuevas fronteras, generando un impacto profundo en todos los ámbitos donde la IA es protagonista.