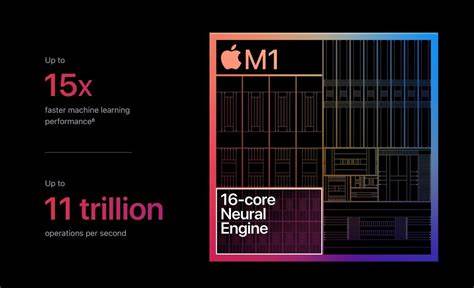

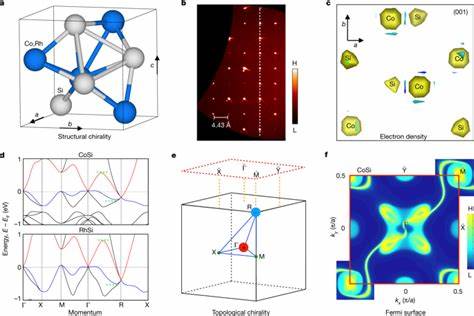

En la era actual de la inteligencia artificial, los grandes modelos de lenguaje (LLMs) han cobrado una importancia sin precedentes, facilitando avances en áreas como el procesamiento del lenguaje natural, la generación de texto y la interacción conversacional. Sin embargo, el despliegue eficiente de estos modelos en dispositivos con recursos limitados, especialmente en dispositivos móviles y de borde, sigue siendo un gran desafío. Aquí es donde entra en juego ANEMLL, el Artificial Neural Engine Machine Learning Library, un proyecto de código abierto que busca optimizar y acelerar la implementación de grandes modelos de lenguaje en el Apple Neural Engine (ANE). ANEMLL representa una innovación clave para usuarios y desarrolladores interesados en aprovechar las capacidades del hardware dedicado de Apple para inteligencia artificial, permitiendo que los modelos entrenados, como los populares modelos LLAMA y sus variantes, funcionen directamente en dispositivos iOS y macOS sin necesidad de conexión a internet. Este enfoque no solo mejora la privacidad y seguridad al mantener los datos localmente sino que también disminuye la latencia, permitiendo una experiencia de usuario ágil y fluida.

Uno de los mayores retos en la integración de LLMs en dispositivos mobiliarios, como iPhones y MacBooks equipados con ANE, es la conversión y optimización de modelos originalmente entrenados en plataformas estándar con altos requerimientos computacionales. ANEMLL facilita este proceso mediante una tubería completamente abierta y accesible, que transforma los modelos desde el repositorio Hugging Face en formatos compatibles con CoreML, la tecnología nativa de Apple para machine learning. Este proceso tiene en cuenta las limitaciones de memoria y ejecución de los dispositivos, optimizando tanto el uso de la memoria, como la eficiencia de cálculo y la distribución de los componentes del modelo. El proyecto no se limita a la conversión técnica, sino que también ofrece herramientas para integrar estos modelos de forma sencilla en aplicaciones nativas de iOS y macOS utilizando Swift o C/C++. Esto representa un avance significativo para desarrolladores que desean incorporar capacidades avanzadas de lenguaje natural sin depender de servidores remotos ni comprometer la experiencia del usuario.

Mediante ejemplos prácticos y documentación accesible, ANEMLL allana el camino para que las soluciones de inteligencia artificial sean más incluyentes y estén disponibles en contextos donde la conectividad es limitada o la privacidad, fundamental. Entre las optimizaciones aplicadas por ANEMLL destaca la división especializada de modelos para ajustarse a las restricciones de memoria específicas de cada entorno: aproximadamente 1GB en dispositivos iOS y hasta 2GB en sistemas macOS. Esta estrategia garantiza que los modelos puedan ejecutarse sin interrupciones y con un rendimiento optimizado, manejando de manera eficiente los distintos componentes críticos de los modelos, tales como embeddings, redes feedforward y la capa final de lenguaje (LM Head). Estos módulos son esenciales para comprender y generar texto de manera coherente y precisa. Además de la optimización y conversión, ANEMLL incorpora herramientas para la inferencia que facilitan la interacción con los modelos a través de interfaces de chat listas para usar.

Estas interfaces no solo permiten evaluar el desempeño del modelo en tiempo real, sino que incluyen funcionalidades como el manejo del historial de conversación, gestión del contexto para mantener coherencia en diálogos prolongados, y supervisión del rendimiento para detectar posibles cuellos de botella o errores. Esta es una ventaja crucial para aplicaciones autónomas, donde el feedback inmediato y la capacidad de adaptación mejoran considerablemente la experiencia del usuario. En cuanto a requisitos técnicos, ANEMLL está diseñado para funcionar de manera óptima en dispositivos que ejecutan macOS Sequoia con Apple Neural Engine integrado, necesitándose al menos 16GB de memoria RAM y versión Python 3.9 para facilitar la conversión y ejecución de los modelos. Estos requerimientos muestran un equilibrio adecuado entre potencia y accesibilidad, ya que muchos dispositivos Apple modernos cumplen o superan estas especificaciones.

La última versión alfa, la 0.1.1, incluye avances significativos para desarrolladores y usuarios finales. Entre las mejoras se encuentra la conversión de modelos en un solo proceso, simplificación de la configuración de modelos, automatización en la preparación para la distribución a través de Hugging Face y una experiencia de chat mejorada con manejo de errores más sofisticado. Además, la optimización del modelo LLaMA incorpora técnicas de prefill que agilizan la preparación del modelo para su ejecución, lo que se traduce en una reducción del tiempo de respuesta y mayor eficiencia computacional.

El impacto de ANEMLL va más allá de la pura innovación técnica. Al permitir la ejecución en dispositivos de borde sin dependencia de conexión a internet, responde a una creciente demanda por soluciones que respeten la privacidad del usuario, minimicen la exposición de datos sensibles y reduzcan los costos asociados con la infraestructura en la nube. Estas características son vitales para sectores como la salud, finanzas, educación y la automatización de procesos legítimamente preocupados por la seguridad y confidencialidad. De cara al futuro, ANEMLL se perfila como un catalizador para la adopción masiva de inteligencia artificial conversacional y sistemas de lenguaje natural en dispositivos Apple. La naturaleza open source del proyecto invita a la comunidad global a colaborar, mejorar las herramientas existentes, expandir la compatibilidad con nuevos modelos y fomentar casos de uso innovadores.

Este espíritu colaborativo es clave para mantener el desarrollo del ecosistema, superar limitaciones técnicas y democratizar el acceso a tecnologías avanzadas. En resumen, ANEMLL representa un paso trascendental en la evolución de los modelos de lenguaje, adaptándolos al contexto del cómputo en dispositivos móviles y de borde con protección de datos inherente. La combinación de conversión simplificada, optimización profunda, herramientas de inferencia integradas y un enfoque centrado en la privacidad y el rendimiento posicionan a ANEMLL como una solución ideal para desarrolladores y empresas que buscan llevar capacidades avanzadas de inteligencia artificial a los usuarios finales en plataformas Apple. En un mundo donde la interacción natural con la tecnología es cada vez más valorada, proyectos como ANEMLL allanan el camino para un futuro en el que la inteligencia artificial esté más integrada, accesible y segura.