En el mundo actual, donde la inteligencia artificial (IA) se ha convertido en una herramienta fundamental para transformar múltiples industrias, la preocupación por la privacidad y el control de los datos se ha incrementado significativamente. En este contexto, el desarrollo de agentes de IA locales utilizando tecnologías como Ollama y Spring AI emerge como una solución innovadora que permite a desarrolladores y empresas mantener el control total de sus aplicaciones de IA, garantizando seguridad, ahorro de costos y optimización en el rendimiento. La popularidad de los servicios en la nube para inteligencia artificial no puede ser discutida, pues ofrecen la ventaja de infraestructura potente y disponibilidad constante. Sin embargo, estos servicios suelen requerir la transferencia de datos sensibles a terceros, además de generar costes significativos por uso y limitar la interacción debido a la latencia. Por ende, la idea de crear agentes de IA que funcionen completamente en el equipo local abre un nuevo horizonte para aplicaciones personalizadas y seguras.

Ollama es una de las herramientas más destacadas en esta emergente categoría. Proporciona un ecosistema capaz de ejecutar grandes modelos de lenguaje (LLM) de código abierto directamente desde el equipo del desarrollador. La facilidad de configuración, junto con un sistema similar a un registro de contenedores, permite gestionar, descargar y ejecutar diversos modelos sin conexión a internet, eliminando las barreras relacionadas con la privacidad de la información y la dependencia de servicios remotos. Por su parte, Spring AI, una extensión del ampliamente conocido framework Spring Boot, ofrece una capa de abstracción elegante y eficiente para integrar modelos de IA y construir agentes capaces de interactuar y realizar tareas complejas. Su arquitectura brinda a los desarrolladores una experiencia fluida para configurar, ampliar y personalizar sus agentes mediante una sencilla configuración en archivos YAML y una API intuitiva.

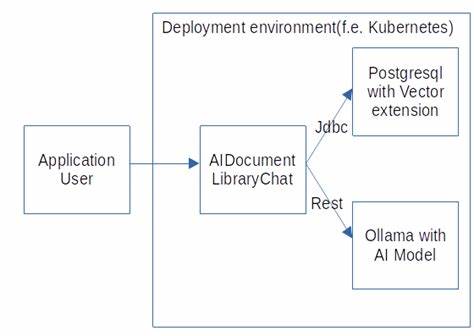

La combinación de Ollama con Spring AI representa un matrimonio perfecto, permitiendo a los desarrolladores crear agentes de IA altamente funcionales que se ejecutan localmente y disponen de herramientas para ampliar sus capacidades. Un ejemplo claro es el uso de modelos como "mistral-small3.1", un modelo pequeño pero potente, capaz de realizar búsquedas en la web o enviar correos electrónicos, funciones que llevan a los agentes más allá de simples chatbots pasivos convirtiéndolos en asistentes activos con agencia propia. El proceso para configurar este entorno comienza con la instalación y puesta en marcha del cliente Ollama, desde donde se levantan los modelos que funcionarán localmente. La interfaz es sencilla y accesible, habilitando el registro, descarga y administración de los diferentes LLM.

Esto permite que, una vez descargados, los modelos puedan ejecutarse sin necesidad de conexión a internet, un aspecto fundamental para operaciones que impliquen datos confidenciales o entornos con restricciones de conectividad. En paralelo, con Spring AI, se configura un proyecto basado en Maven que incluye las dependencias necesarias para habilitar el soporte para Ollama y las capacidades de los agentes. La magia ocurre al definir en el archivo de configuración application.yml parámetros clave como la URL base del cliente Ollama, el modelo a usar, la temperatura de generación y la cantidad máxima de tokens. Además, Spring AI permite la incorporación de herramientas externas mediante el protocolo MCP (Model Control Protocol), que facilita la integración de funcionalidades específicas como realizar búsquedas con el motor de Brave o enviar correos vía Gmail, ejecutándose desde contenedores Docker o servidores locales Python como FastMCP.

El uso del protocolo MCP es clave para dotar de agencia a los agentes. Gracias a él, el agente no solo responde con texto estático sino que puede interpretar comandos, preguntar al usuario antes de ejecutar acciones y realizar esas tareas de manera autónoma. Con esta arquitectura, el agente puede gestionar información dinámica y brindar respuestas contextualizadas con referencias actualizadas. El código para la integración en Spring es limpio y eficiente. Mediante una clase de configuración se genera un bean ChatClient que enlaza el modelo Ollama y los clientes MCP.

Este cliente se enriquece con un prompt sistemático que define su comportamiento, tal como solicitar confirmación previa para el uso de herramientas y dar referencias en sus respuestas. La simplicidad de esta configuración permite que cualquier desarrollador Spring pueda implementar un agente inteligente con capacidades avanzadas sin un esfuerzo excesivo ni conocimiento profundo en IA. Un aspecto muy importante en esta arquitectura es la capacidad de profundizar en la memoria del agente, facilitada por componentes como MessageChatMemoryAdvisor, que permite al agente recordar el contexto de las interacciones, haciendo que las conversaciones sean más naturales y coherentes. Esta característica potencia la experiencia de usuario, haciendo que el agente actúe como un verdadero asistente personal. El ejemplo de integración con FastMCP es ilustrativo porque muestra cómo en Python se puede crear un servidor local que expone herramientas que el agente puede invocar.

Con funciones documentadas y con parámetros nombrados, como el caso de enviar correos electrónicos por SMTP usando Gmail, la inteligencia del modelo se potencia para saber cuándo y cómo llamar a estas herramientas, guiando las interacciones para obtener resultados exitosos. Para las empresas, esta propuesta tecnológica aporta un valor significativo. Primero, al evitar enviar datos sensibles fuera de su infraestructura, se mitigan riesgos de seguridad y se cumple con regulaciones cada vez más estrictas en materia de privacidad. Segundo, al operar sin conexión a servicios externos, se eliminan costos por uso de API y se reduce la latencia, mejorando la experiencia del usuario final. Además, el enfoque local permite la personalización total de los agentes.

Se pueden entrenar modelos específicos, afinar comportamientos o desarrollar herramientas a la medida, todo sin las limitaciones impuestas por plataformas comerciales. Esta flexibilidad abre oportunidades para crear soluciones innovadoras en sectores como salud, finanzas, educación o administración pública. En términos tecnológicos, el ecosistema Spring ofrece robustez, escalabilidad y el respaldo de una comunidad sólida y activa. Integrar Spring AI en este entorno representa aprovechar toda esa experiencia para construir aplicaciones modernas, seguras y orientadas al futuro. La sinergia con Ollama lleva la IA a un nivel tangible y práctico para desarrolladores Java, facilitando la adopción masiva de agentes inteligentes.

Desde la perspectiva del desarrollo, esta metodología promueve el paradigma de código declarativo y limpio. La configuración mediante YAML y el patrón builder para ChatClient reducen la complejidad y acortan los tiempos de puesta en marcha. Esto permite a los equipos centrarse en mejorar la lógica de negocio y ofrecer experiencias diferenciadas en lugar de luchar con los aspectos técnicos de bajo nivel. En resumen, la creación de agentes de IA locales con Ollama y Spring AI marca un avance importante para el desarrollo de IA personalizada, privada y eficiente. Rompe con las barreras de costo, latencia y privacidad que han limitado hasta ahora la adopción de asistentes inteligentes en entornos profesionales.

Para los desarrolladores interesados en explorar estas tecnologías, los recursos disponibles son accesibles y la comunidad está formada por profesionales entusiastas que comparten sus experiencias y mejoras continuas. El futuro de la inteligencia artificial pasa por soluciones locales y seguras, y Ollama junto a Spring AI ofrecen el camino ideal para llegar allí sin sacrificar funcionalidad ni calidad. Explorar, practicar y adaptar estas tecnologías permitirá que las capacidades de la IA se integren plenamente en las aplicaciones cotidianas y en los procesos de negocio, abriendo posibilidades casi ilimitadas para la innovación y la excelencia operativa en todos los sectores.