En los últimos años, la inteligencia artificial (IA) se ha consolidado como una herramienta indispensable en múltiples áreas, revolucionando la forma en que interactuamos con la tecnología. Entre los avances más destacados está ChatGPT, un modelo de lenguaje desarrollado por OpenAI, que ha captado la atención tanto de usuarios como de expertos por su capacidad para generar texto con un nivel de coherencia y fluidez sorprendente. Sin embargo, junto con su gran popularidad, han surgido muchas preocupaciones sobre el impacto ambiental y energético que podría tener su uso masivo. ¿Cuánta energía realmente consume cada consulta a ChatGPT? ¿Es un gasto desmedido que contribuye significativamente al cambio climático o se ha sobreestimado este coste? A continuación, analizamos a fondo el consumo energético de ChatGPT, basándonos en información actualizada y estudios recientes, para arrojar luz sobre esta cuestión. Uno de los mitos más difundidos es que cada consulta a ChatGPT consume alrededor de 3 vatios-hora (Wh) de electricidad, una cifra que ha sido utilizada para comparar este consumo con el de actividades cotidianas y para generar preocupación sobre el impacto ambiental de la inteligencia artificial.

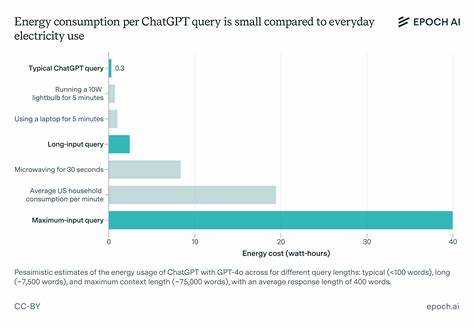

Sin embargo, investigaciones más recientes y detalladas sugieren que esta cifra es probablemente una sobreestimación considerable. Estudios actuales estiman un consumo aproximado de 0.3 vatios-hora por consulta, lo que equivale a una décima parte de la cifra inicialmente reportada. Esta notable reducción se debe a mejoras en la eficiencia tanto del hardware como de los modelos implementados, así como a una evaluación más precisa de los tokens generados durante una interacción promedio. Para entender mejor qué supone este consumo, es importante conocer cómo funcionan los modelos de lenguaje como GPT-4o, la versión en la que se basa ChatGPT.

Estos sistemas trabajan con unidades llamadas tokens, que representan fragmentos de texto equivalentes en promedio a tres cuartos de una palabra. Generar cada token implica realizar un gran número de operaciones matemáticas conocidas como operaciones en punto flotante (FLOP). En el caso de GPT-4o, se estima que hay alrededor de 200 mil millones de parámetros, aunque no todos se activan simultáneamente gracias a una arquitectura conocida como «mezcla de expertos» (MoE), que optimiza la eficiencia computacional activando solo una parte de los parámetros según la necesidad. Cuando un usuario hace una consulta, ChatGPT procesa la información y genera una respuesta que puede rondar los 500 tokens, equivalente a unas 400 palabras. Para producir estos tokens, se realizan aproximadamente 100 mil millones de operaciones por token, lo que implica miles de millones de FLOP para cada respuesta.

Este nivel de computación requiere sistemas especializados, en este caso principalmente unidades de procesamiento gráfico (GPU) Nvidia H100, consideradas las más eficientes hasta la fecha para tareas de IA. En cuanto al consumo de energía, cada GPU puede requerir hasta 1500 vatios en operación máxima, aunque en la práctica, debido al uso compartido, la eficiencia y la gestión de recursos, el consumo promedio suele ser menor. Además, la eficiencia real del sistema viene marcada por la tasa de utilización del hardware, que en inferencia suele ser alrededor del 10%. Considerando estas variables y el tiempo necesario para procesar una sola consulta, se calcula un gasto energético aproximado de 0.3 Wh, muy por debajo de los 3 Wh que han circulado durante años.

Cabe señalar que esta estimación ya es prudente y es probable que algunos usuarios, con consultas más simples o más cortas, consuman niveles energéticos aún menores. Por otro lado, el costo energético cambia considerablemente si incrementan las características de la interacción. Por ejemplo, cuando las entradas no son simples preguntas sino documentos extensos o textos largos cargados al sistema, el consumo puede llegar a ser más alto. Al procesar entradas de hasta 10.000 tokens, la energía requerida por consulta puede subir hasta 2.

5 Wh, y en casos extremos con entradas que superan los 100.000 tokens (equivalentes a un libro de más de 200 páginas) puede alcanzar hasta 40 Wh por procesamiento único. Es importante destacar que este costo elevado se asigna principalmente a la fase de preprocesamiento y que, una vez cargada una entrada extensa, las interacciones posteriores no repiten esta carga energética de forma individualizada. Otra fuente habitual de confusión está en comparar ChatGPT con otros servicios como las búsquedas en Google. Un dato histórico indica que una búsqueda en Google consume alrededor de 0.

3 Wh, cifra muy similar a la de una consulta promedio de ChatGPT en su versión actual. Sin embargo, es imprescindible considerar que la tecnología y arquitectura de cada servicio son diferentes y avanzan constantemente, por lo que esas comparaciones solo ofrecen un panorama general y deben interpretarse con prudencia. Es fundamental también comprender que el uso de la energía no se limita a responder consultas. La fase de entrenamiento del modelo requería una inversión considerablemente más alta en recursos eléctricos. Entrenar modelos como GPT-4o puede durar alrededor de tres meses y consumir un poder equivalente a 20-25 megavatios, comparable al uso eléctrico de miles de hogares.

No obstante, este gasto se amortiza a lo largo del tiempo que el modelo está disponible y en uso para millones de usuarios, haciendo que el costo energético marginal por consulta sea relativamente bajo. En cuanto al impacto ambiental indirecto, es necesario tener en cuenta también la construcción y fabricación del hardware usado en centros de datos, conocidas como emisiones «embodied» o incorporadas. Aunque estos costos son difíciles de cuantificar exactamente, varios estudios indican que representan una fracción considerablemente menor en comparación con la energía consumida durante la operación de la IA. Las gigantescas demandas energéticas y de procesamiento han impulsado avances en la eficiencia tecnológica y operativa. Desde nuevas generaciones de chips con mejores rendimientos por vatio hasta algoritmos optimizados que reducen las operaciones necesarias durante la generación de texto, la industria está en constante búsqueda de balancear poder computacional con sostenibilidad.

Además, se están explorando y adoptando métodos como la predicción de múltiples tokens a la vez o técnicas de decodificación especulativa que acortan tanto el tiempo de procesamiento como el coste energético por consulta. Mirando hacia el futuro, el panorama del consumo energético en IA es incierto y dual. Por un lado, se espera que la eficiencia técnica continúe mejorando, con hardware más especializado y modelos que logren resultados comparables o superiores con menos operaciones. Por otro lado, la demanda de capacidades cada vez más sofisticadas y tamaños de modelos crecientes puede llevar a un incremento en el gasto energético total, si el crecimiento en complejidad no se compensa con optimizaciones efectivas. Finalmente, la transparencia y la disponibilidad de datos reales sobre consumo y eficiencia por parte de las empresas de IA será crucial para evaluar con precisión el impacto ambiental de estas tecnologías.

Hasta ahora, la información disponible proviene mayormente de estimaciones y metodologías indirectas, lo que contribuye a la proliferación de mitos y exageraciones. Un acceso más abierto a datos reales ayudaría a desmitificar el tema, fomentar buenas prácticas y orientar regulaciones y estrategias para minimizar el impacto ambiental sin frenar la innovación tecnológica. En conclusión, mientras que ChatGPT y tecnologías similares sí consumen una cantidad significativa de energía para funcionar, los costos marginales por consulta individual son relativamente bajos, especialmente si se comparan con otras actividades diarias y con las primeras estimaciones publicadas. La clave estará en equilibrar un crecimiento sostenible de la inteligencia artificial con un compromiso serio hacia la optimización energética y la mitigación del impacto ambiental, garantizando que los beneficios de esta revolución tecnológica puedan disfrutarse sin comprometer el futuro del planeta.