En el ámbito del desarrollo de software, especialmente en la verificación formal de sistemas operativos, es común encontrar estadísticas que, si bien aparentan ser útiles, pueden prestarse a interpretaciones erróneas. La llamada “relación prueba-a-código” (proof-to-code ratio) es uno de los indicadores que con mayor frecuencia se presenta en publicaciones técnicas y ponencias como un atisbo de eficiencia y progreso en la verificación. Sin embargo, esta métrica, lejos de ser sólida, es en realidad un truco estadístico que puede inducir a conclusiones injustificadas y, en el peor de los casos, a la desinformación de la comunidad técnica y académica. Este fenómeno encaja dentro de lo que se conoce como “crímenes de benchmarking”, prácticas poco rigurosas o irresponsables en la presentación y comparación de datos de rendimiento o esfuerzo técnico. Más allá de la simple búsqueda de cifras impresionantes, es crucial entender por qué la relación entre el tamaño del código y el tamaño de las pruebas formales no solo es una medida engañosa, sino que además puede resultar completamente irrelevante si no se contextualiza con otros factores esenciales.

Para ilustrar este fenómeno, tomaremos como punto de partida un ejemplo práctico y accesible: la especificación y verificación formal de una función de ordenamiento, conocida comúnmente como sort(). Esta función, que organiza una lista de números enteros en orden ascendente, puede parecer sencilla para analizar; sin embargo, el nivel de detalle necesario para definir lo que significa que la función esté “correctamente” implementada puede variar profundamente, afectando directamente al tamaño y complejidad de la prueba formal requerida. La especificación formal de sort() puede involucrar varios niveles progresivos de requerimientos. Primeramente, se establece que la función debe retornar una lista de enteros que tenga la misma longitud que la lista original. Esto, aunque evidente, no constituye una garantía real de corrección.

Luego, se agrega la condición de que la lista resultante esté ordenada, lo que podría parecer el núcleo principal del problema. Sin embargo, un paso posterior y crucial es asegurar que los elementos presentes en la lista de salida sean exactamente los mismos que los de entrada, sin perder ni añadir elementos, preservando multiplicidades. Este último punto es fundamental para evitar resultados falsamente válidos desde el punto de vista del ordenamiento, pero incorrectos en cuanto a la integridad de los datos. Este ejemplo demuestra que simplemente contar líneas de código frente a líneas de prueba resulta insuficiente para medir el esfuerzo o complejidad real involucrada. Desde el primer nivel al último, el código no cambia, pero la especificación sí, y con ello, la profundidad y tamaño de la prueba se incrementan significativamente.

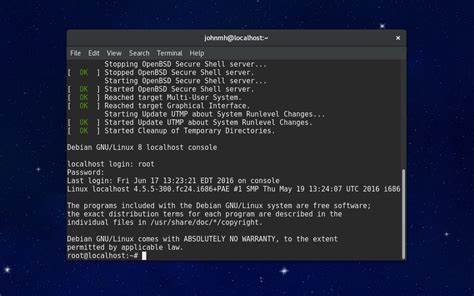

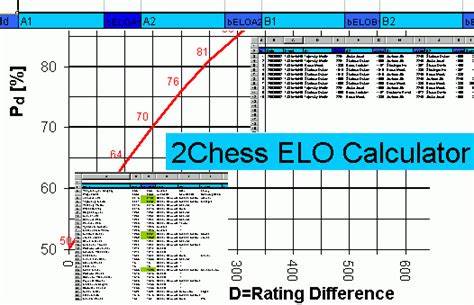

Por tanto, comparar proyectos o sistemas solo por la proporción de pruebas sobre código sin considerar la riqueza y rigor de las especificaciones es una práctica falible y poco confiable. Un aspecto adicional que incide en la complejidad y tamaño de la prueba es el propio diseño del algoritmo o sistema. En el caso de sort(), diferentes algoritmos pueden implementar la misma funcionalidad con códigos de tamaños muy diversos. Esto implica también una variabilidad en la cantidad y dificultad de las pruebas necesarias. Las herramientas de verificación interactivas (ITP) donde el usuario participa en el proceso de prueba manual suelen requerir más esfuerzo que las automatizadas (ATP) apoyadas en solvers SMT, capaces de automatizar parte de la verificación.

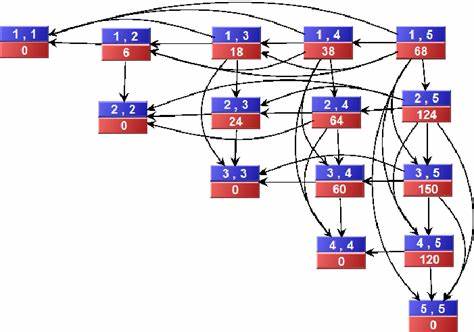

Sin embargo, la automatización no es una varita mágica que elimina la complejidad, especialmente en sistemas con especificaciones muy amplias o sofisticadas. Estadísticas más reveladoras muestran que la complejidad del sistema se relaciona en mayor medida con el tamaño de la especificación formal, no simplemente con el del código fuente. Resultados de estudios indican que la complejidad de la prueba puede crecer de manera cuadrática en función del tamaño de la especificación, una relación que desafía la idea errónea de que simplemente aumentar las líneas de código generará un aumento lineal en el esfuerzo de verificación. La importancia de esta relación no puede subestimarse, ya que subraya cómo enfoques simplistas en benchmarking omiten variables esenciales y llevan a conclusiones engañosas. La modularidad emerge como un principio crucial para manejar la complejidad en ingeniería de software, y es razonable pensar que su aplicación debería simplificar también la verificación formal.

Descomponer un sistema global en partes más pequeñas y bien definidas idealmente reduciría el costo total de la verificación si la complejidad globalmente se distribuye y se gestiona adecuadamente. Sin embargo, en sistemas altamente integrados y con dependencias globales, como es el caso del microkernel seL4, la modularidad es difícil de aplicar sin sacrificar propiedades esenciales como rendimiento o generalidad. Esto indica que la mera división en módulos no siempre es una estrategia efectiva para reducir el esfuerzo de verificación en casos prácticos. Desde otra perspectiva, las investigaciones muestran que sistemas verificados con métodos automáticos requieren considerablemente menos esfuerzo, al menos en conjunto, que los basados en métodos interactivos. Pero esta diferencia viene con la limitación de la complejidad de las especificaciones que los sistemas automáticos pueden abordar.

Por tanto, la elección del método de verificación debe considerar el balance entre la capacidad de expresar especificaciones ricas y la practicidad del esfuerzo invertido. El análisis crítico de datos y métricas en la verificación formal debe ser mucho más riguroso para evitar caer en lo que se denomina “crímenes de benchmarking” — interpretación errónea y mal representada de estadísticas para favorecer supuestos avances o comparaciones de métodos. Es crucial que la comunidad técnica fomente un enfoque transparente basado en especificaciones claras, métricas relevantes y un entendimiento profundo de lo que realmente implica verificar sistemas complejos. En resumen, centrarse exclusivamente en la relación líneas de prueba frente a líneas de código no solo obvia factores decisivos, sino que puede desvirtuar la percepción real del avance tecnológico en verificación formal. Para mejorar la calidad metodológica y fortalecer la confianza en resultados futuros, la comunidad debe promover evaluaciones holísticas que contemplen la complejidad y tamaño de las especificaciones, el uso de técnicas interactivas o automáticas, y la estructura modular o monolítica de los sistemas.

Entender estos matices no solo beneficia a expertos y académicos, sino también a quienes desarrollan software crítico en sectores como industria, defensa y seguridad, donde la correcta verificación formal puede ser la diferencia entre sistemas confiables y vulnerables. Al final, avanzar en verificación formal es un desafío multifacético que demanda rigor, transparencia, y sobre todo, una adecuada interpretación de los datos, dejando de lado atajos estadísticos que solo confunden más que ayudan.