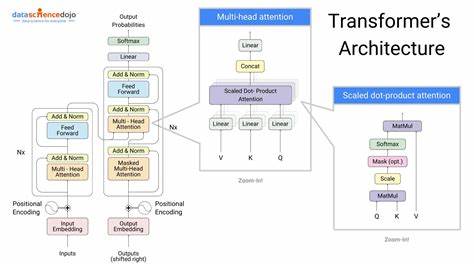

En la última década, los modelos transformer han marcado un cambio significativo en el campo de la inteligencia artificial, especialmente en el procesamiento del lenguaje natural (PLN). Su arquitectura innovadora ha permitido avances impresionantes en tareas como traducción automática, generación de texto, análisis de sentimiento y más. Sin embargo, más allá de los modelos tradicionales como el famoso Transformer original presentado por Vaswani et al., emergen versiones inusuales y creativas que desafían la norma al ofrecer nuevas perspectivas y funcionalidades en el mundo del aprendizaje automático. Los modelos transformer poco convencionales, a veces apodados como «modelos de transformer no autoregresivos» o variantes encoders, están adoptando enfoques distintos que pueden acelerar el entrenamiento, mejorar la eficiencia o incluso abrir nuevas posibilidades en tareas específicas.

A diferencia de los transformers clásicos que procesan secuencias de manera autoregresiva, estos modelos suelen buscar maneras de predecir varias partes de la salida simultáneamente, lo que puede reducir el tiempo computacional sin sacrificar precisión. Uno de los conceptos que ha ganado atención es la idea del transformer encoder-only. Este enfoque se centra únicamente en la parte del codificador dentro de la arquitectura original de transformer. En lugar de generar texto de manera secuencial, un encoder-only puede ofrecer una representación profunda y contextualizada de los datos de entrada, que luego puede usarse en tareas que requieren comprensión del contenido, como clasificación o extracción de información. El desarrollo de estos transformers inusuales ha sido facilitado por la comunidad de código abierto, donde desarrolladores y entusiastas comparten sus experimentos y descubrimientos a través de plataformas como GitHub y foros especializados.

Estos recursos revelan implementaciones innovadoras que contienen módulos experimentales con mejoras en la eficiencia y adaptabilidad de la arquitectura transformer. Además, plataformas de lanzamiento de proyectos como Show HN en Hacker News permiten mostrar prototipos y modelos funcionales, lo que fomenta un flujo constante de ideas frescas y colaboraciones. Entre los desafíos que enfrentan los transformers tradicionales está la necesidad de enorme poder computacional para entrenar y ejecutar modelos extensos. Esto puede ser problemático para investigadores y startups con recursos limitados. Los modelos inusuales introducen técnicas que buscan optimizar tanto la velocidad como la memoria requerida.

Algunas implementaciones recurren a la simplificación de componentes internos, mientras que otras adoptan enfoques híbridos combinando elementos de transformers con otras arquitecturas como redes convolucionales o mecanismos basados en atención más ligeros. El código abierto también impulsa la personalización, permitiendo que estos modelos sean adaptados a nichos específicos o tipos de datos poco convencionales. Por ejemplo, en dominios como la bioinformática, la música o los datos visuales secuenciales, los modelos transformer mezclan innovaciones para manejar la naturaleza particular de la información. La flexibilidad garantizada por los intercambios comunitarios posibilita que un modelo inicialmente pensado para texto pueda transformarse para operar con éxito en otros formatos, ampliando el espectro de aplicaciones posibles. Es importante destacar que el entrenamiento de estos modelos requiere no solo recursos computacionales, sino también una comprensión profunda de la configuración y sintonización de hiperparámetros.

Aquellos que crean modelos inusuales suelen experimentar con diferentes optimizadores, funciones de pérdida y estrategias de regularización para evitar el sobreajuste y mejorar la generalización. La iteración constante sobre los diseños y parámetros es clave para alcanzar resultados competitivos y estables. Además, la documentación y el código disponible también reflejan una filosofía pedagógica que busca democratizar el conocimiento del machine learning. A través de descripciones claras, comentarios en el código y scripts de entrenamiento reproducibles, los desarrolladores emergentes pueden aprender y contribuir con mayor facilidad. Esto ayuda a acelerar la adopción de estas nuevas arquitecturas y a promover un ecosistema más colaborativo y abierto.

La inclusión de modelos transformer poco convencionales en entornos empresariales también empieza a vislumbrarse con creciente interés. Empresas que requieren procesamientos rápidos o que manejan grandes volúmenes de datos en tiempo real pueden beneficiarse de estas optimizaciones. La personalización de modelos permite adaptar soluciones concretas, desde asistentes virtuales hasta sistemas de recomendación o análisis predictivo en sectores como finanzas, salud y comercio electrónico. Desde el punto de vista académico, la publicación constante de nuevos estudios y benchmarks ha alimentado el debate sobre la eficacia y aplicabilidad de estas variantes. Algunos argumentan que, a pesar de los avances, los transformers estándar todavía ostentan un liderazgo en términos de rendimiento general.

Sin embargo, los modelos inusuales abren un mundo paralelo donde la innovación continúa y plantea preguntas pertinentes sobre la interpretación de resultados y la escalabilidad de los sistemas. Otra área donde estos modelos han demostrado valor es en la reducción del sesgo y el mejor manejo de datos desequilibrados. Al modificar la manera en que se representan y procesan las secuencias, los diseñadores pueden lograr sistemas más neutrales y justos, abordando uno de los grandes retos éticos que enfrenta la inteligencia artificial actual. En definitiva, la experimentación con transformers inusuales está configurando un nuevo capítulo de la inteligencia artificial donde la creatividad técnica y la colaboración comunitaria juegan roles fundamentales. El camino hacia modelos más eficientes, versátiles y accesibles no solo potencia la capacidad de las máquinas para entender y generar contenido, sino que también expande las posibilidades para la innovación en múltiples disciplinas.

El futuro de los transformers, entendido desde la óptica de estos desarrollos novedosos, parece prometedor y lleno de potencial. A medida que más actores se sumen a este movimiento y compartan sus avances, es probable que veamos surgir nuevas aplicaciones sorprendentes que hoy solo imaginamos, revolucionando la manera en que interactuamos con la tecnología y los datos en nuestra vida cotidiana.