En la era digital, la gestión eficiente del correo electrónico se ha convertido en una necesidad fundamental para usuarios personales y profesionales. A pesar del avance de la inteligencia artificial, muchas personas aún dedican tiempo valioso buscando entre montones de emails para encontrar respuestas a preguntas específicas. Hoy en día, la mayoría sigue utilizando motores de búsqueda básicos dentro de sus plataformas de correo o tienden a hacer búsquedas manuales que pueden ser ineficientes y poco relacionadas con la pregunta real que tienen en mente. Frente a esta problemática, el equipo de OpenPipe ha presentado una solución innovadora llamada ART·E, un agente de investigación por correo electrónico que no solo responde preguntas usando búsquedas inteligentes, sino que también supera significativamente los resultados del modelo anterior conocido como o3. ART·E combina el poder del aprendizaje por refuerzo (RL) con un diseño optimizado para una tarea realmente útil y realista: responder preguntas formuladas en lenguaje natural mediante la exploración profunda en bandejas de entrada.

La necesidad de contar con un agente capaz de buscar en correos electrónicos surge de situaciones cotidianas, como querer saber cómo confirmar asistencia a un evento, detalles de vuelos familiares o información corporativa relevante, tareas que usualmente requieren múltiples pasos manuales y una considerable inversión de tiempo. La aproximación única que propone ART·E radica en la utilización de técnicas de aprendizaje por refuerzo para que el agente mejore su precisión y eficiencia en la búsqueda y respuesta, tomando decisiones inteligentes sobre cuándo y cómo utilizar diferentes herramientas para escanear el contenido del correo electrónico. Para entrenar este agente, fue fundamental contar con un conjunto de datos que reflejara correos electrónicos reales y preguntas relevantes. Para este fin, se eligieron los correos electrónicos públicos de Enron, compuestos por más de medio millón de mensajes enviados y recibidos por empleados de dicha empresa. De estos, se tomaron varias bandejas personales para conformar conjuntos de datos de entrenamiento y prueba.

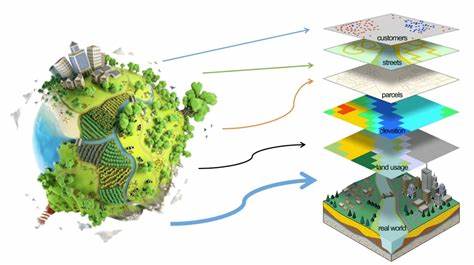

Sin embargo, más allá de los correos, resultaba esencial generar preguntas con respuestas asociadas, emulando lo que un usuario podría preguntar sobre dichos correos. Al no existir un conjunto de datos prediseñado con estas características, se optó por crear uno sintético mediante GPT-4. Esta generación artesanal permitió producir miles de pares pregunta-respuesta con un grado de realismo notable, filtrando incluso aquellas consultas poco naturales o poco relevantes. El entorno en el cual ART·E opera está definido claramente para facilitar su aprendizaje y operación. El agente cuenta con herramientas que simulan acciones específicas: una función para buscar correos basados en palabras clave y rangos de fechas, otra para leer el contenido completo de un correo seleccionado y finalmente una función para entregar la respuesta final al usuario junto con las fuentes consultadas para dar confianza y trazabilidad a la respuesta.

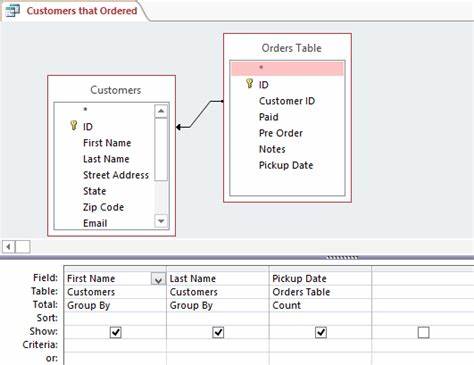

Para que la búsqueda sea eficiente, se creó una base de datos SQLite con soporte para búsquedas de texto completo (FTS5), permitiendo que el agente pueda consultar grandes cantidades de correos de forma rápida y efectiva. El agente funciona de manera iterativa: se le da la pregunta, el modelo decide qué acción realizar —como qué buscar o qué correo leer—, responde con los resultados y repite este ciclo hasta que decide que tiene la información necesaria para entregar la respuesta final, o hasta que se alcanza un límite máximo de pasos. La simplicidad del ciclo contrasta con la complejidad implícita de la tarea, pero ha demostrado ser muy efectiva en práctica. La efectividad del agente ART·E fue variada y debidamente comparada con modelos preexistentes. El modelo o3, anteriormente el referente en este tipo de tareas, fue el principal competidor a superar.

Antes de aplicar el aprendizaje por refuerzo, el equipo de desarrollo realizó un exhaustivo benchmark con modelos sin entrenamiento adicional para entender sus limitaciones y las áreas que se podían mejorar. Esto les permitió definir de manera clara cómo medir el rendimiento y qué aspectos del agente necesitaban refuerzo adicional. Uno de los elementos definitivos para el avance de ART·E fue la definición de la función de recompensa. En las técnicas de aprendizaje por refuerzo, esta función guía al modelo para aprender comportamientos deseados y evitar errores comunes. Para ART·E, la recompensa principal se basó en la corrección de la respuesta final, es decir, que coincidiera con la respuesta esperada.

Pero además, se incorporaron incentivos para minimizar la cantidad de pasos que el agente empleaba para responder correctamente, intentando así reducir la latencia y mejorar la experiencia de usuario. Otro aspecto crítico fue la penalización de respuestas incorrectas o generadas erróneamente, conocidas como alucinaciones en el lenguaje natural, que podrían entregar respuestas falsas o no sustentadas. Se dotó al sistema de un castigo considerable para estos casos, asegurando que el modelo prefiriera admitir desconocimiento antes que inventar o asumir información errónea, lo que aumentó la confianza en sus resultados. Durante el proceso de entrenamiento, se consideraron también recompensas parciales, como encontrar al menos el correo correcto en la búsqueda o hacer uso correcto de las herramientas disponibles, aunque en la práctica estos incentivos adicionales no aceleraron el aprendizaje como se esperaba, y en algunos casos llevaron a comportamientos indeseados, como repetir acciones sin sentido. El modelo finalmente fue entrenado usando la librería de código abierto ART, que facilita la implementación de agentes multi-turno con el algoritmo Group Relative Policy Optimization (GRPO).

La metodología consistió en presentar al agente múltiples preguntas y permitirle ejecutar diversas trayectorias de acción para cada una, evaluándolas según la función de recompensa y ajustando los parámetros para mejorar continuamente. El entrenamiento fue calibrado cuidadosamente, ajustando hiperparámetros, monitoreando métricas clave como la precisión en respuestas, cantidad de pasos tomados, y la tasa de alucinaciones. Este seguimiento riguroso permitió identificar rápidamente problemas de optimización y realizar correcciones efectivas. El resultado final fue un agente que no solo responde con mayor precisión que o3, sino que también es cinco veces más rápido y sesenta y cuatro veces más económico en términos de costos computacionales, haciendo que su aplicación práctica sea más rentable y accesible. Como ejemplo de su funcionamiento, ART·E es capaz de buscar entre miles de correos de un usuario, identificar con precisión la información solicitada, ya sea una fecha límite, un número de confirmación de vuelo o instrucciones específicas para un trámite, todo esto sin intervención humana directa durante el proceso.

![Dr Russell Barkley's 30 essential ideas everybody needs to know about ADHD. (Y [video]](/images/06D99782-107F-4863-B89B-84AAFB26BE6C)