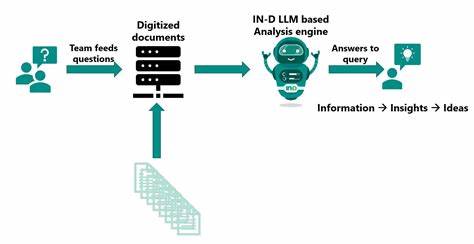

Los grandes modelos de lenguaje (LLMs) como ChatGPT, Claude y Gemini Flash han revolucionado la forma en la que interactuamos con las tecnologías de inteligencia artificial. Sin embargo, a medida que estas herramientas se han popularizado, han surgido preocupaciones relacionadas con su impacto ambiental y económico, especialmente en torno a cuánto cuesta realmente realizar una consulta a estos modelos. ¿Es verdad que detrás de cada pregunta que hacemos hay un consumo exorbitante de electricidad y agua? ¿O son solo exageraciones? En este análisis detallado, desentrañaremos los mitos y presentaremos una visión realista del costo energético y ambiental asociado a cada consulta que se hace a un LLM. Cuando hablamos del coste verdadero de los modelos de inteligencia artificial, es fundamental diferenciar entre dos etapas: el entrenamiento del modelo y la inferencia, que es el proceso de responder a las consultas. Entrenar un modelo como ChatGPT implica un gasto energético enorme, pues se procesa una cantidad monumental de datos durante semanas o meses usando cientos o miles de GPUs de alto rendimiento.

Este proceso consume electricidad a nivel industrial y, en algunas instalaciones, se requiere una cantidad significativa de refrigeración, que a su vez consume recursos hídricos y energéticos adicionales. Sin embargo, este entrenamiento es un evento puntual o recurrente cada cierto tiempo, y no se repite con cada consulta. Por otro lado, la inferencia o la fase de consulta, aunque complementaria, es mucho menos intensiva en recursos por cada interacción individual. Esto es clave para entender los debates actuales, ya que muchos de los temores que circulan en redes sociales acerca del elevado consumo energético y agua detrás de cada consulta parecen mezclar estos dos procesos. Por ejemplo, circula un meme que insinúa que cada consulta a ChatGPT implica el uso de una a tres botellas de agua para refrigeración, una afirmación que, si bien evocadora, no se sostiene bajo un análisis riguroso.

Para poner en perspectiva, un usuario destacado reportó el consumo energético de un dispositivo MacBook M4 Max al ejecutar localmente un modelo Gemini de tamaño mediano, que corresponde aproximadamente a 32 mil millones de parámetros. Cuando el equipo se pone a trabajar en inferencia, el consumo de energía aumenta en cerca de 120 vatios desde el estado de reposo. Este MacBook es capaz de generar alrededor de 70 tokens por segundo y suele tardar entre 10 a 20 segundos para completar una respuesta. Si calculamos rápidamente, esto equivale aproximadamente a medio vatio-hora para una respuesta promedio, lo que comparativamente es muy bajo. Para llevarlo a términos más tangibles, se estima que una batería típica de laptop tradicional puede administrar unas 200 respuestas antes de agotarse, suficiente para considerar viable su uso para tareas comunes.

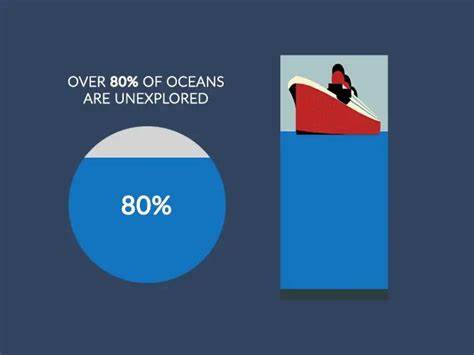

Ahora bien, los servidores industriales que operan LLMs en la nube, como los centros de datos de OpenAI o Google, utilizan GPUs mucho más potentes que el hardware de un solo computadora portátil doméstica. Estos servidores están diseñados para optimizar el rendimiento y la eficiencia energética, y utilizan sistemas avanzados de refrigeración que también han mejorado significativamente con los años para reducir el consumo de agua y energía. A pesar de esto, el costo energético total por consulta sigue siendo relativamente bajo, especialmente cuando se evalúa la escala masiva en la que estos servicios se utilizan. Lo interesante es comparar este consumo con otras actividades cotidianas digitales, para poner en contexto el impacto. Por ejemplo, ver cinco minutos de video en YouTube o realizar una búsqueda en Google también genera un consumo energético considerable, pero a menudo ignorado en el debate público.

Estudios independientes sugieren que el consumo energético de una consulta a un LLM está en un rango similar o incluso inferior al consumo generado por búsquedas web intensivas o transmisión de video corto. En términos de huella de carbono, la infraestructura de servidores usada para los LLMs representaría solo una fracción del gasto energético global de Internet, que en su conjunto supera ampliamente otras industrias. Otro aspecto a considerar es el hecho que las compañías desarrolladoras de estos modelos están invirtiendo en energía renovable y en la optimización de sus sistemas para minimizar el impacto ambiental. Servicios en la nube como los de Google o Microsoft, socios clave en la operación de LLMs, están comprometidos con objetivos ambiciosos para operar con energía 100% renovable en un futuro cercano. Por ello, la conversación sobre el impacto ambiental no puede desligarse del contexto más amplio de la industria tecnológica, sus avances ecológicos y el aumento en la eficiencia del hardware.

Desde el punto de vista económico, aunque entrenar un LLM representa cientos de miles o millones de dólares, el coste por consulta individual es notablemente bajo. Esto se traduce en que el acceso a estos modelos puede ser masivamente escalable y que el precio para el usuario final o para empresas que los integran sigue bajando con la mejora en la tecnología y la optimización continua de los modelos. La tecnología tampoco es estática. Los desarrolladores trabajan constantemente para mejorar la eficiencia de los modelos sin sacrificar su calidad. Técnicas como la cuantización o la poda de parámetros permiten reducir el consumo energético durante la consulta sin afectar dramáticamente el desempeño, lo que ayuda a reducir aún más el impacto por interacción.

En conclusión, aunque no se puede negar que la creación y operación de grandes modelos de lenguaje tiene un costo energético real, muchas de las afirmaciones alarmistas alrededor del consumo individual por consulta no tienen fundamento sólido y se basan más en malentendidos de cómo funciona la tecnología. En realidad, el mayor gasto reside en la fase de entrenamiento, que es un proceso esporádico y optimizado, mientras que la ejecución cotidiana de consultas genera un consumo mucho más controlado y comparable con otras actividades digitales comunes. Es importante mantener un diálogo informado y equilibrado, criticar constructivamente y fomentar innovaciones que garanticen el desarrollo de la inteligencia artificial de forma responsable y sostenible. La tendencia apunta a que con el avance tecnológico lograrán disminuir aún más el consumo energético, reforzando la idea de que el acceso a poderosas herramientas basadas en IA es viable y puede coexistir con un compromiso auténtico con la sostenibilidad ambiental.