En el mundo actual donde la información y los datos crecen a una velocidad exponencial, la capacidad de buscar y relacionar contenidos de manera eficiente es fundamental. Las bases de datos vectoriales han emergido como una tecnología clave para enfrentar esta necesidad, especialmente cuando se trata de manejar grandes volúmenes de información en formatos complejos como texto, imágenes y sonidos. Pero, ¿qué es exactamente una base de datos vectorial y cómo podemos construir una propia desde cero? Para abordar esta cuestión, es imprescindible entender algunos principios básicos y las estructuras de datos que hacen posible una búsqueda precisa y rápida en espacios de alta dimensión. Las bases de datos vectoriales almacenan y gestionan vectores, que en términos simples, son arreglos de números que representan datos. Estos vectores pueden tener cientos o miles de dimensiones, como 768, 1024 o 1536, y se utilizan comúnmente para representar conceptos derivados de modelos de aprendizaje automático, conocidos como embeddings.

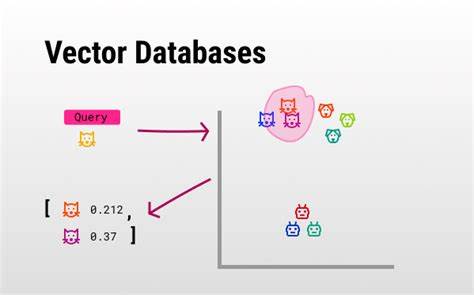

Por ejemplo, una frase o imagen puede ser transformada en un vector numérico que captura su significado o características esenciales, permitiendo comparaciones y búsquedas basadas en similitud. El objetivo principal de una base de datos vectorial es encontrar, dado un vector de consulta, los K vectores más cercanos a él entre millones o incluso miles de millones almacenados. Esta tarea es fundamental en aplicaciones como motores de búsqueda semánticos, recomendadores de contenido personalizado o detección de anomalías. Sin embargo, llevar a cabo esta búsqueda en espacios de alta dimensión presenta desafíos únicos que requieren soluciones eficientes y sofisticadas. Una de las primeras aproximaciones para la búsqueda de vecinos cercanos es dividir el espacio en regiones, por ejemplo, mediante una cuadrícula.

Aunque este método puede funcionar en dos dimensiones, como localizar parcelas en un mapa usando latitud y longitud, no escala bien cuando el espacio es de alta dimensión o cuando la densidad de puntos varía significativamente. Además, decidir el tamaño adecuado de cada región en el grid es complejo, ya que un área muy pequeña puede generar demasiadas subdivisiones, mientras que una muy grande puede incluir muchos datos no relevantes. En el caso real, la distribución de los datos no es uniforme. Ciudades densamente pobladas como Nueva York tienen miles de propiedades muy cercanas unas de otras, mientras que áreas como Wyoming tienen escasos puntos de interés. Por lo tanto, la búsqueda vectorial necesita adaptarse a la densidad y distribución de los datos para ser efectiva, lo que complica mucho las simples divisiones espaciales.

Una estrategia importante para manejar esta variabilidad es la cuantización, que permite reducir la precisión de los vectores para ahorrar espacio y mejorar la velocidad, aunque a costa de perder algo de exactitud. Más allá de una reducción lineal, es posible redefinir las coordenadas para reflejar mejor la densidad del espacio, un proceso similar a crear un cartograma que distorsiona áreas en función de la población. Esta técnica permite que la representación de los datos sea más sensible a las regiones densas o escasas, facilitando búsquedas más pertinentes. Otra limitante de las simples cuadrículas es que ignoran la estructura real de los datos. Para solucionarlo, se recurre al agrupamiento o clustering, donde se identifican centros representativos (centroides) que agrupan puntos similares.

Por ejemplo, con métodos como k-means, se configuran varios centroides que se ajustan para minimizar la distancia a los datos reales que representan. Al buscar un vector, se identifica primero el grupo al que probablemente pertenece, para luego restringir la búsqueda a los vectores dentro de ese cluster. Así, en vez de explorar todo el conjunto de datos, se limita la búsqueda a zonas relevantes, mejorando la eficiencia. Sin embargo, los clusters pueden ser insuficientes cuando se requiere flexibilidad en la búsqueda y una estructura que facilite exploraciones dinámicas más allá de divisiones rígidas. Aquí es donde entran en escena las estructuras de grafos, en particular Hierarchical Navigable Small Worlds (HNSW), la base de los sistemas más efectivos en búsqueda vectorial como Weaviate, Elasticsearch o OpenSearch.

El gráfico, en este contexto, conecta nodos donde cada nodo representa un vector almacenado. Los nodos se enlazan con sus vecinos más cercanos formando una red donde la recorrida se hace buscando caminos hacia la proximidad del vector de consulta. Este proceso es análogo a navegar por un mapa, donde partimos de un punto de entrada y nos movemos a los vecinos que nos acercan a nuestro destino. Gracias a la topología del grafo, es posible realizar búsquedas eficientes, sin tener que explorar toda la base de datos. Programar la lógica básica de este tipo de búsqueda implica construir una clase Nodo que almacenará el vector y sus vecinos, y otra clase para el grafo que contendrá esos nodos.

La búsqueda comienza desde un nodo inicial y, mientras se visitan los vecinos que estén más cerca al vector de consulta, se mantiene un registro de los nodos ya visitados para evitar repeticiones y ciclos. Para optimizar la selección de los nodos más cercanos, se utiliza una estructura tipo heap que mantiene sólo los mejores candidatos, facilitando una búsqueda eficiente en términos computacionales. Incorporar un nuevo vector al grafo implica hallar la posición donde conectarlo, por ejemplo, buscar su vecino más cercano y establecer enlaces mutuos que permitan la navegabilidad futura para búsquedas similares. Aunque esta es una versión simplificada, en la práctica, HNSW añade múltiples mejoras para evitar cuellos de botella y mejorar la precisión. Dos parámetros clave que impactan el comportamiento de esta estructura son ef y M.

Ef determina la cantidad de caminos explorados durante la búsqueda, mientras que M controla el número máximo de conexiones o vecinos que puede tener un nodo. Ajustar estos parámetros permite balancear la velocidad y precisión; un grafo muy conectado (alto M) y con muchas exploraciones (alto ef) suele ser más preciso pero costoso computacionalmente. La jerarquía es otra innovación fundamental en HNSW, que se inspira en cómo nos movemos en redes físicas. Para viajar entre ciudades distantes, no recorremos calle por calle, sino que usamos autopistas o vías rápidas que conectan regiones. De forma similar, HNSW organiza los nodos en capas, donde las superiores conectan regiones amplias con menos detalles, y las inferiores están más detalladas.

Durante la búsqueda, se parte de las capas altas para hacer saltos grandes y, progresivamente, se desciende para afinar la búsqueda, lo que garantiza eficiencia para grandes volúmenes de datos. Más allá de la teoría y el código inicial, construir una base de datos vectorial funcional y eficaz implica afrontar muchos retos. Estos incluyen limitaciones en el número de vecinos por nodo para evitar grafos excesivamente densos, estrategias para asegurar buena conectividad múltiple y mecanismos para manejar la evolución y crecimiento continuo del grafo sin pérdida de calidad. Además, en aplicaciones reales, resulta indispensable integrar estas bases con sistemas de almacenamiento robustos, escalabilidad horizontal y compatibilidad con otros servicios de consulta y análisis. La optimización de consultas, la gestión de índices y el balance entre precisión y rendimiento son elementos críticos.

En resumen, el camino para construir una base de datos vectorial propia comienza por entender qué son los vectores, cómo representan información compleja y por qué encontrar vecinos cercanos en espacios multidimensionales es un problema complejo. A partir de ahí, explorar las limitaciones de métodos simples como subdivisiones espaciales, y adoptar técnicas avanzadas como cuantización, clustering y especialmente la navegación en grafos con estructuras jerárquicas como HNSW, permite construir sistemas potentes que sobresalen en velocidad y exactitud. Aprender a implementar y ajustar estos conceptos no solo abre puertas a crear motores de búsqueda semánticos o sistemas de recomendación, sino que también prepara el terreno para innovar en áreas donde el análisis de datos complejos y masivos es fundamental en la actualidad y el futuro cercano.