En el ámbito del procesamiento de alto rendimiento y el aprendizaje automático, CUDA ha sido durante años la plataforma predominante para el desarrollo de aplicaciones aceleradas por GPU, especialmente en dispositivos Nvidia. Sin embargo, debido a diversas razones técnicas, comerciales y estratégicas, muchos desarrolladores y empresas están evaluando o incluso emprenden la migración de sus proyectos desde CUDA hacia otras alternativas. Este análisis ofrece una visión completa sobre las experiencias, herramientas y consideraciones en este proceso de migración. CUDA, acrónimo de Compute Unified Device Architecture, es un conjunto de herramientas, librerías y compiladores creados por Nvidia para facilitar el desarrollo de aplicaciones paralelas que aprovechan la capacidad de cálculo masivo de sus GPUs. Su amplio uso se justifica por la madurez del ecosistema, la optimización específica para arquitecturas Nvidia y el soporte para frameworks populares, como PyTorch y TensorFlow.

Sin embargo, su principal limitación es el bloqueo tecnológico, ya que está ligado exclusivamente al hardware de Nvidia, lo que puede restringir la flexibilidad y aumentar la dependencia del fabricante. Conforme la industria informática se diversifica y aparecen GPUs de diferentes fabricantes, se incrementa la demanda hacia soluciones compatibles con estándares abiertos que permitan mayor interoperabilidad. Tecnologías como ROCm de AMD o el estándar OpenCL representan alternativas que buscan romper con la hegemonía de CUDA. Además, recientes herramientas como CANN 6.0 (Compute Architecture for Neural Networks), desarrolladas por operadores distintos a Nvidia, anuncian capacidades para facilitar la migración de código CUDA con supuesta compatibilidad elevada, especialmente en marcos de trabajo como PyTorch, tradicionalmente optimizados para CUDA.

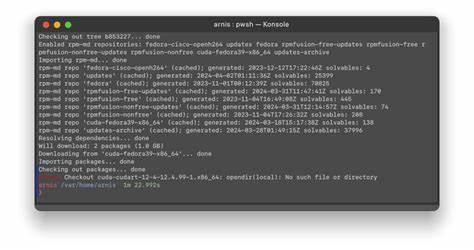

El proceso de migración puede ser complejo y está sujeto a varios factores. Por un lado, la compatibilidad del código fuente, puesto que muchas aplicaciones CUDA contienen código optimizado o utilizan funciones específicas de Nvidia. Por otro, el soporte de frameworks y librerías que permitan seguir aprovechando beneficios como la aceleración en entrenamientos y despliegues de modelos de inteligencia artificial. Además, la estabilidad y el mantenimiento a largo plazo son críticos para minimizar interrupciones en procesos industriales o de investigación. Diversas experiencias de usuarios en comunidades técnicas como Hacker News destacan que la transición hacia plataformas basadas en CANN 6.

0 y ROCm aún está en evolución. Aunque la promesa de 'migración con un solo clic' resulta atractiva, la realidad práctica implica realizar ajustes manuales y pruebas exhaustivas para asegurar que los modelos se ejecuten eficientemente. En particular, se señala que la compatibilidad con PyTorch ronda el 95% en ciertos escenarios, pero puede variar dependiendo de la complejidad del código y las versiones involucradas. Además, los desarrolladores han señalado que el rendimiento tras la migración debe evaluarse cuidadosamente, ya que la equivalencia funcional no siempre se traduce en equivalencia en velocidad de cómputo o eficiencia energética. Herramientas que automatizan la conversión pueden facilitar la identificación de fragmentos de código problemáticos, pero la supervisión humana y el ajuste fino continúan siendo fundamentales.

El ecosistema de aprendizaje profundo, especialmente, se ha beneficiado históricamente del soporte de CUDA dado que PyTorch y TensorFlow ofrecen optimizaciones específicas para estas GPUs. Por ello, la comunidad activa ha comenzado a contribuir en adaptadores y extensiones que soportan nuevas plataformas y licencian compatibilidad creciente para acelerar la adopción. La adopción de estándares más abiertos y multiplataforma puede fomentar una mayor innovación y reducir la dependencia tecnológica. En términos prácticos, quienes consideren esta migración deben plantear un plan detallado que contemple la evaluación del código actual, la identificación de funciones exclusivas de CUDA, la selección de la plataforma de destino y las pruebas rigurosas para asegurar que los resultados del cómputo sean correctos y con el rendimiento esperado. Entender el soporte del framework de aprendizaje automático en la plataforma seleccionada es también esencial para garantizar una transición exitosa.

Finalmente, es crucial tomar en cuenta que la industria se encuentra en un período dinámico donde la competencia entre fabricantes de hardware y desarrolladores de software está impulsando innovaciones en la computación acelerada. Migrar desde CUDA puede representar una estrategia para diversificar, reducir costos o aumentar flexibilidad, pero el proceso necesita planificación, conocimiento técnico profundo y una integración cuidadosa para evitar problemas estructurales en los pipelines de desarrollo y producción. En conclusión, migrar desde CUDA es una tarea viable pero compleja que debe abordarse con cuidado. Herramientas como CANN 6.0 prometen simplificar esta transición, especialmente en entornos enfocados en inteligencia artificial y aprendizaje profundo, pero la madurez e impacto real dependerán de la evolución constante del ecosistema.

El balance entre la fidelidad en la conversión, la compatibilidad con frameworks y el rendimiento determinarán el éxito o fracaso de la migración y su adopción en distintos sectores.