En el fascinante mundo del aprendizaje automático y la inteligencia artificial, la creación de modelos de lenguaje a gran escala (LLM, por sus siglas en inglés) ha revolucionado la forma en que las máquinas procesan y entienden el lenguaje humano. Un componente esencial para el éxito de estos modelos es el mecanismo conocido como atención, especialmente la atención múltiple o multi-head attention. Sin embargo, detrás de esta técnica compleja, existe una verdad sorprendente: cada una de las cabezas de atención es, en realidad, bastante simple o “tonta”. Esta aparente contradicción es la que exploraremos en profundidad. La atención en sí misma es un mecanismo matemático que permite que el modelo se “fije” en diferentes partes de una secuencia de datos al procesar texto, por ejemplo, al leer una oración.

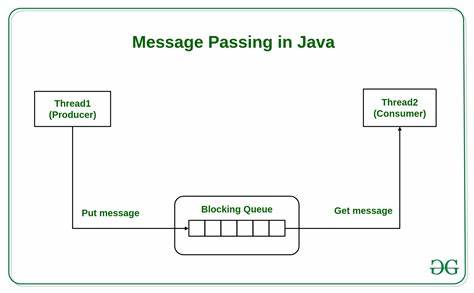

Los modelos de lenguaje utilizan este mecanismo para determinar cuáles palabras o tokens son más relevantes en un contexto específico y así entender mejor el significado general. Lo que a menudo se pasa por alto es que cada cabeza de atención individual no procesa significados profundos ni complejos. En lugar de ello, cada cabeza realiza una tarea de emparejamiento o comparación muy simple: identificar patrones básicos o relaciones locales entre palabras o posiciones en la secuencia. Cada una “busca” algo muy específico y limitado, sin comprender la oración en su totalidad. El verdadero poder y sofisticación emergen cuando múltiples cabezas de atención trabajan en conjunto, distribuyéndose distintas tareas y especializaciones.

Esta multiplicidad permite que el modelo capte diversas relaciones dentro de una oración o texto más extenso, desde coincidencias gramaticales como artículos y sustantivos, hasta patrones basados en la posición de las palabras o dependencias semánticas más sutiles. Sumado a esto, las capas sucesivas en un modelo transformer permiten que cada nueva capa refine y combine la información de la anterior. De este modo, lo que comienza como operaciones simples y aisladas en una primera capa, se transforma gradualmente en representaciones ricas y complejas que reflejan significados y contextos cada vez más profundos. Podemos pensar en ello como el equivalente a las capas en redes neuronales convolucionales para imágenes, donde las primeras capas detectan bordes, las siguientes formas básicas y las últimas detalles semánticos como rostros o objetos. Un ejemplo ilustrativo para entender mejor esta simplicidad relativa de las cabezas es imaginar una cabeza de atención entrenada para relacionar artículos definidos como “el” o “la” con los sustantivos que acompañan.

En una frase como “el gato gordo se sentó en la estera”, esta cabeza no comprende realmente el sentido completo, sino que reconoce en qué posiciones están los artículos y los sustantivos, generando puntuaciones de atención que reflejan estas relaciones. Este proceso se basa en convertir las representaciones iniciales de cada palabra, conocidas como embeddings, a través de proyecciones en espacios distintos llamados espacios de consultas (query) y claves (key). En un espacio de consultas, la posición y naturaleza del token se expresan en un espacio embebido que indica “lo que se busca”. En el espacio de claves, cada token se describe como “lo que es”. Calculando un producto punto entre estos vectores, el modelo obtiene una puntuación que indica la semejanza o relevancia entre tokens.

Lo curioso es que aunque los espacios de consulta y clave pueden parecer complejos, en muchos casos para cabezas individuales son espacios muy simplificados y especializados que solo consideran detalles clave muy limitados para sus tareas específicas. Por ejemplo, distinguir entre un artículo y un sustantivo, o considerar la cercanía posicional de tokens. Las puntuaciones finales son normalizadas para determinar cuánta “atención” debe prestarse a cada palabra durante el procesamiento. Esta simplicidad ayuda a evitar que una sola cabeza de atención intente realizar un análisis demasiado complejo, lo cual sería ineficiente y poco efectivo. En lugar de eso, la fuerza del modelo radica en la cooperación y combinación de muchas cabezas.

Cada una aporta pequeñas piezas del rompecabezas del lenguaje que, cuando se ensamblan a través de múltiples capas, entregan una comprensión profunda y contextualizada. Además de la capacidad de aprender estos patrones con datos masivos, este diseño evita el problema del “cuello de botella” fijo presente en modelos previos basados en redes recurrentes. Antes, los modelos tenían que comprimir toda la información relevante en un vector de tamaño fijo, dificultando el manejo de secuencias largas. La atención múltiple sobre múltiples capas permite que la representación crezca proporcionalmente con la longitud del input, ofreciendo mayor flexibilidad y capacidad para contextos amplios. Por supuesto, las cabezas de atención no operan bajo reglas predefinidas por humanos, sino que aprenden sus patrones y proyecciones específicas durante el entrenamiento mediante optimización por descenso de gradiente.

Esto significa que lo que una cabeza aprende puede ser muy diferente de nuestras intuiciones lingüísticas y, a menudo, resulta en representaciones abstractas y altamente específicas para la tarea. En síntesis, lo que se podría definir como un sistema sencillo a nivel micro se convierte en un mecanismo altamente potente y flexible a nivel macro. La combinación de cabezas de atención especializadas y capas apiladas permite a los modelos de lenguaje modernas construir representaciones del lenguaje que incorporan contexto, significado y relaciones complejas, transformando así la forma en que las máquinas comprenden y generan texto. Esta perspectiva también motiva futuras exploraciones sobre cómo optimizar la cantidad de cabezas, su dimensionalidad y el número de capas para maximizar la eficiencia y eficacia del modelo. Entender que las cabezas de atención son “dumb” o simples ayuda a desmitificar el proceso y concentrar esfuerzos en diseñar arquitecturas balanceadas y entrenamientos efectivos.

Finalmente, la comprensión de este mecanismo es fundamental para quienes desean construir modelos de lenguaje desde cero, así como para investigadores que buscan mejorar algoritmos existentes. Aunque la atención múltiple puede parecer misteriosa y compleja al principio, su base en comparaciones sencillas y combinaciones en profundidad revela una elegancia mecánica que impulsa los avances en inteligencia artificial conversacional y computación lingüística.