La evolución de las herramientas que apoyan a los programadores ha sido vertiginosa durante las últimas décadas, pero la promesa de los agentes de programación basados en inteligencia artificial aún parece estar en una etapa temprana, casi como si estuvieran atrapados en una fase intermedia entre el potencial y la excelencia. Un analista veterano en programación ha trazado una paralela fascinante entre los agentes de programación actuales y los motores de búsqueda en la era pre-Google, sugiriendo que estas tecnologías podrían estar a un solo salto innovador —un “PageRank”— de alcanzar su punto óptimo. Para comprender esta comparación, es esencial volver a los años noventa y analizar cómo las personas encontraban información en internet antes de que Google revolucionara el campo. En aquel entonces, dos métodos dominaban la navegación en la red: navegar por directorios web y realizar búsquedas en motores poco precisos. El primero, ejemplificado por Yahoo! con su amplio sistema de categorías jerárquicas, imponía un recorrido arduo y poco intuitivo para descubrir contenido.

Aunque efectivo para temas populares, este método fallaba estrepitosamente cuando se trataba de consultas especializadas o muy técnicas que requerían profundizar en niveles específicos de la jerarquía. El segundo recurso eran los motores de búsqueda, que entonces presentaban reto tras reto. Existía una amplia variedad de estos, pero cada uno ofrecía resultados erráticos y poco fiables. El usuario debía invertir muchas horas refinando consultas, cambiando entre plataformas y modificando términos, sin garantía alguna de hallar la respuesta esperada. En esencia, la experiencia representaba un ejercicio de paciencia y habilidad en la formulación de búsquedas.

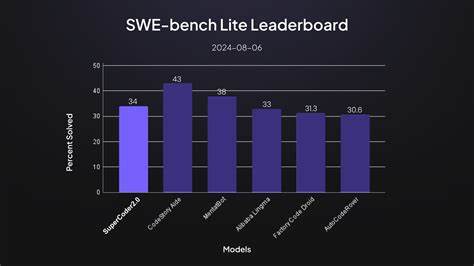

La innovadora aportación de Google fue un algoritmo llamado PageRank, que transformó completamente la manera en que se posicionaban los resultados. Este enfoque consideraba la relevancia y popularidad de las páginas web mediante enlaces, lo que permitió que las búsquedas fueran no solo más rápidas, sino también mucho más precisas y confiables. Rápidamente, Google se impuso como el estándar, dejando atrás a una multitud de competidores y literalmente cambiando la forma en que se interactúa con la red. Al aplicar esta historia al ámbito de los agentes de programación, surgen similitudes evidentes. Actualmente, estas inteligencias artificiales destinadas a asistir en tareas de codificación operan como los motores de búsqueda pre-Google: prometedoras, pero aún lejos de ser una herramienta que simplemente “funcione” sin complicaciones.

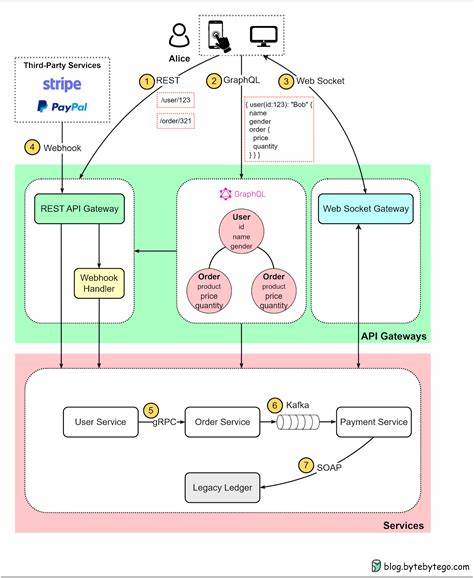

Estas plataformas, que se basan en modelos de lenguaje y procesamiento avanzado, requieren que el usuario domine el arte de la formulación de consultas —los famosos “prompts”— para conseguir resultados valiosos, y no siempre estos llegan en la primera interacción. Un ejemplo concreto es la experiencia con herramientas como Cursor, un agente que integra generación automática de código en el flujo de trabajo de desarrollo. Aunque ofrece una interfaz amigable y puede producir fragmentos funcionales rápidamente, la realidad es que, cuando se trata de problemas específicos o procesos multi-etapa, a menudo fracasa en entender el contexto completo o las complejidades del sistema, lo que obliga al desarrollador a realizar múltiples intentos y ajustes. Este estado intermedio genera una sensación ambivalente: por un lado, el agente está cerca de entregar lo esperado; por otro, la diferencia entre éxito y frustración puede depender de factores menores en la formulación de la consulta o en la optimización interna del modelo. La precisión y efectividad de estas inteligencias artificiales están, por tanto, ligadas a la calidad de los prompts, al tipo de modelo de lenguaje utilizado y, fundamentalmente, a cómo interpretan y manejan la información contextual.

El paralelismo con la situación pre-Google no es una casualidad. En aquella época, la falta de un sistema de ranking efectivo era la barrera principal para el acceso rápido y fiable a la información. Hoy, la carencia puede estar en mecanismos que permitan a los agentes de programación interpretar correctamente las necesidades complejas del proceso de desarrollo y adaptarse dinámicamente a las respuestas recibidas, algo parecido a cómo un humano inteligente simplificaría un problema a través de preguntas aclaratorias y ajustes iterativos. Un aspecto crucial que podría representar ese “PageRank” faltante es la implementación de sistemas que permitan a los agentes realizar preguntas aclaratorias antes de generar código. Actualmente, la mayoría responde directamente a la consulta recibida, sin verificar si han comprendido adecuadamente el problema.

En entrevistas técnicas, por ejemplo, los humanos tienden a formular preguntas para precisar requerimientos o posibles restricciones antes de proponer una solución. Un agente que incorporara ese comportamiento no solo mejoraría la exactitud de sus respuestas sino que promovería interacciones más productivas y menos frustrantes. Otra consideración es el potencial subutilizado de la instrucción previa al modelo, conocida como prompt de sistema o “system prompt”. Compartir y estandarizar mejores prácticas para establecer estos prompts, que guían el comportamiento de la inteligencia artificial durante la sesión, podría elevar considerablemente la calidad del código generado. Hay iniciativas que sugieren colecciones de indicaciones diseñadas para optimizar la simplicidad, claridad y documentación del código emitido, pero en muchas plataformas esta capacidad aún no se aplica automáticamente.

En cuanto a los recursos computacionales invertidos en la generación, la hipótesis de que los agentes “son demasiado perezosos” también resuena. Tal como los desarrolladores humanos, quizá estos modelos no se “esfuerzan” suficientemente en las primeras respuestas para optimizar resultados, debido a limitaciones de coste o diseño. Permitir sesiones más extensas o el uso de algoritmos que simulen un razonamiento más profundo podría marcar la diferencia. Sin embargo, aumentar simplemente la escala o el tamaño del modelo parece no ser la solución definitiva. Las mejoras en las últimas generaciones de modelos se han encaminado a reducir errores como las alucinaciones y a incrementar la coherencia general, pero estas no necesariamente garantizan una solución universal para contextos complejos o poco definidos que caracterizan muchas tareas de programación.

Finalmente, es interesante reflexionar sobre cuál será el impacto en distintos segmentos de desarrolladores. Los ingenieros experimentados, con conocimiento profundo y capacidad para resolver problemas de forma tradicional, podrían no sentirse motivados a depender completamente de agentes de inteligencia artificial que aún requieren supervisión constante. Por otro lado, la generación emergente de programadores podría encontrar en estos agentes una herramienta esencial para acelerar el aprendizaje y la ejecución, incluso si ello implica dominar nuevas formas de interacción con la máquina, que incluyen la elaboración precisa de prompts y el análisis crítico del código generado. Este fenómeno podría significar que la verdadera revolución en el uso de agentes de codificación llegará cuando estos sistemas alcancen un nivel de robustez y usabilidad tal que cualquier usuario, sin importar su nivel previo, pueda obtener resultados culminales con poca fricción. Para lograrlo, la industria podría necesitar un cambio profundo, alimentado por una innovación que permita entender mejor el contexto, colaborar en tiempo real, y priorizar la precisión a través de mecanismos similares a un ranking interno o un sistema de retroalimentación eficaz.