Los modelos de lenguaje grandes, conocidos comúnmente como LLMs (Large Language Models), han revolucionado la manera en que las máquinas entienden y generan texto en múltiples idiomas con una fluidez sorprendente. Detrás de esta capacidad aparentemente mágica, existe un complejo entramado de procesos matemáticos y computacionales basados en redes neuronales y millones – e incluso miles de millones – de parámetros. Recientemente, una animación ha cobrado relevancia al mostrar de forma clara y visual cómo estos modelos construyen y ajustan sus parámetros de red, facilitando así una mejor comprensión de su funcionamiento interno tanto para expertos como para entusiastas de la inteligencia artificial. En este análisis detallado, abordaremos qué son estos parámetros, por qué son fundamentales, cómo se crean y ajustan durante el entrenamiento, y el impacto que esto tiene en su desempeño y evolución tecnológica. Para entender la implicación de la animación que ilustra el proceso, primero es necesario explicar qué son los parámetros en el contexto de un LLM.

Los parámetros son valores numéricos internos que la red neuronal utiliza para transformar y manipular la información de entrada para producir salidas coherentes y útiles. En esencia, son como los diales que la red ajusta para capturar patrones lingüísticos, relaciones contextuales y estructuras gramaticales del texto. Estos parámetros se dividen generalmente en pesos y sesgos, y la habilidad del modelo para aprender está determinada por la manera en que estos valores se sintonizan durante el entrenamiento. El proceso de creación y ajuste de los parámetros comienza con una inicialización, un punto de partida donde los valores suelen asignarse de forma aleatoria o mediante algún esquema que facilite el aprendizaje. Luego, a través de un enorme conjunto de datos de texto – que puede incluir libros, artículos, páginas web y otros recursos escritos –, el modelo se expone de manera reiterativa a las secuencias textuales.

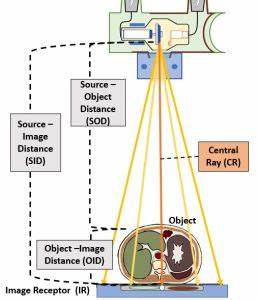

En cada paso, el modelo intenta predecir la siguiente palabra o completación lógica. Si la predicción falla o es inexacta, una técnica computacional conocida como retropropagación se encarga de modificar los parámetros internamente para reducir al mínimo el error detectado. La animación que acompaña esta explicación ilustra cómo las conexiones entre neuronas (representadas como nodos) se fortalecen o debilitan a medida que los pesos se reajustan, llevando a una red más precisa. Entender visualmente este aprendizaje es impactante porque da forma a una abstracción muy compleja. La animación juega un papel fundamental mostrando cómo cada conexión entre las neuronas recibe una 'modificación' específica de acuerdo con algoritmos que buscan minimizar la diferencia entre las predicciones y la realidad del dato.

Los patrones emergentes en esta representación expucelen el difícil proceso de aprendizaje del modelo, donde parámetros suficientes y correctamente ajustados permiten captar sutilezas complejas del lenguaje natural. El tamaño de estos modelos ha crecido exponencialmente en los últimos años. Por ejemplo, algunos LLMs cuentan con decenas o cientos de miles de millones de parámetros, un volumen que hace que su entrenamiento requiera supercomputadoras y largos períodos de tiempo. La animación permite captar, a pesar de esta inmensa escala, cómo los fundamentos matemáticos y computacionales permanecen constantes en esencia. La interconexión y el reajuste continuo forman la base del éxito del modelo en tareas diversas como traducción automática, generación de texto, resumen de documentos, entre otras.

Un aspecto importante que destaca la animación es la influencia del aprendizaje profundo en este proceso. En esencia, los modelos utilizan múltiples capas de neuronas artificiales para procesar la información en diferentes niveles de abstracción. Cada capa realiza transformaciones de los datos recibidos, aplicando sus parámetros para detectar desde características básicas hasta conceptos más complejos. La animación muestra esta jerarquía y la manera en que la información fluye a través de la red, ayudando a explicar por qué los LLMs pueden comprender y generar texto de forma tan sofisticada. Más allá del entrenamiento inicial, el ajuste de parámetros no termina.

Existen técnicas como el 'fine-tuning' o ajuste fino, donde modelos ya entrenados se especializan en tareas concretas al continuar el entrenamiento con datos específicos. La animación también puede ilustrar cómo esta segunda fase modifica livianamente los parámetros, conservando lo aprendido pero adaptándose para mejorar el rendimiento en circunstancias particulares. Esto ha sido clave para movimientos recientes en inteligencia artificial que buscan adaptar modelos generales a entornos específicos de manera eficiente. La animación acerca a muchos usuarios el núcleo técnico de los LLMs, desmitificando la inteligencia artificial y fomentando una comprensión más accesible de cómo funciona esta tecnología que se está integrando en múltiples ámbitos de la vida cotidiana. Desde asistentes de voz hasta aplicaciones educativas y herramientas de contenido automatizado, conocer el proceso de creación y ajuste de parámetros abre la puerta a una valoración más profunda y crítica respecto a sus alcances y limitaciones.

En definitiva, la animación que muestra cómo un LLM genera y ajusta sus parámetros es una poderosa herramienta educativa para visualizar un proceso que, por su complejidad matemática y tecnológica, resulta muchas veces inaccesible o abstracto. A través de esta representación gráfica, tanto investigadores como estudiantes y profesionales pueden observar en tiempo real el funcionamiento que convierte datos en conocimiento lingüístico, ayudando a entender por qué estos modelos han sido capaces de transformar el panorama de la inteligencia artificial y procesamiento del lenguaje natural. Se espera que futuras animaciones y simulaciones sigan profundizando el acceso a esta información, potenciando la alfabetización digital y fomentando avances en la construcción de modelos aún más sofisticados que redefinirán nuestra interacción con las máquinas.

![Animation of how LLMs make their network parameters [video]](/images/AF8DCC91-EADE-4082-B0DD-A80BDE11EAF5)