La inteligencia artificial ha irrumpido en numerosos sectores, transformando la manera en que trabajamos, diseñamos y desarrollamos software. En especial, los agentes de IA -programas autónomos capaces de realizar tareas complejas y adaptativas- se han convertido en piezas clave dentro del desarrollo tecnológico actual. Sin embargo, controlar a estos agentes resulta a menudo una misión casi imposible debido a su rápida evolución, la complejidad de sus respuestas y la dificultad para mantener la coherencia con nuestras necesidades reales. Gestionar agentes de IA en el mundo real implica un delicado equilibrio entre confianza y control. No basta con pedir que realicen tareas con comandos abiertos o permitir que improvisen sin límites.

En cambio, el éxito radica en establecer reglas, planes detallados y mecanismos para evaluar y ajustar su comportamiento constantemente. Estos desafíos se amplifican por la velocidad con la que cambian los modelos y herramientas, y la imposibilidad de que el humano pueda seguir el ritmo con exactitud. Uno de los primeros retos al trabajar con agentes de IA es elegir las herramientas adecuadas. Aunque muchos desarrolladores se concentran en el software o la plataforma, lo realmente importante son los insumos que proporcionamos: nuestro código, datos, diagramas y sobre todo, los prompts o instrucciones que enviamos. Estas entradas constituyen los verdaderos materiales con los que los agentes trabajan, mientras que la técnica corresponde al modo en que combinamos y estructuramos esa información para obtener mejores resultados.

Para gestionar estos agentes, es fundamental tener una autoconciencia clara de nuestras propias habilidades y limitaciones. Son pocas las personas que cuentan con las competencias necesarias para proveer indicaciones precisas y estructuradas que los modelos puedan interpretar correctamente. La planificación adquiere un papel crucial, pues el tiempo dedicado a diseñar un plan reutilizable y modular puede ahorrar horas de corrección y evitar que el agente tome decisiones erróneas o improvise soluciones inapropiadas. Contrario a lo que algunos creen, el denominado “vibe coding”, que consiste en solicitar respuestas o códigos espontáneos sin planificación previa, raramente genera productos viables para su despliegue en producción. Aunque estos prototipos pueden ser útiles para mostrar avances o ideas iniciales, carecen de la robustez necesaria para ser considerados finales.

Desarrollar un plan que divida el trabajo en pequeñas partes reconocibles y deliveryables hace que el agente tenga una hoja de ruta clara y evite desviaciones. Esta ruta, o plan, debe escribirse en documentos que tengan tanto carácter humano como programático. Guardar estos planes en el repositorio, con archivos Markdown enriquecidos con fragmentos de código, ejemplos y explicaciones, convierte el plan en una especie de software en sí mismo, que puede ser ejecutado paso a paso, revisado y versionado junto al código. Así se construye confianza en el proceso y se garantiza trazabilidad en los cambios. No obstante, al redactar los planes, es normal que no queden perfectos a la primera.

Revisarlos desde el principio, identificar partes erróneas o irrelevantes y hacer ajustes ágiles es parte vital del proceso. Estas correcciones no solo mejoran la ejecución inmediata sino que alimentan un acervo de reglas y normas que moldean las futuras interacciones con los agentes y evitan la repetición de errores. Debido a que los agentes de IA son esencialmente modelos predictivos que generan texto con base en patrones aprendidos, su comprensión profunda de los objetivos o de la arquitectura específica de nuestro sistema es limitada. Por eso, es esencial verificar siempre el código o las soluciones generadas, testearlas en entornos controlados y estar preparados para intervenir manualmente cuando la solución propuesta no cumpla con los requisitos o cause efectos no deseados. El ciclo de prueba y validación es una oportunidad para descubrir problemas en nuestro propio código o diseño, aún aquellos que hemos pasado por alto.

Los agentes pueden señalar “malos olores” o deficiencias arquitectónicas que obstaculizan el desarrollo o mantenimiento, evidenciando la necesidad de refactorizar antes de seguir adelante. Esta disciplina de depuración y mejora continúa es donde los agentes brillan más, dado que pueden acelerar el trabajo repetitivo y reconocer patrones que al humano le requieren mucho tiempo. Para aprovechar al máximo estas capacidades, es necesario diseñar reglas explícitas que acompañen los planes, permitiendo que el agente tenga directrices claras durante cada operación. Estas reglas pueden expresarse en archivos que se adjuntan automáticamente según el contexto, o que se activan manualmente para determinados procesos. Mantener estas reglas actualizadas facilita la coherencia, reduce errores recurrentes y ayuda a construir un entorno en el que el agente aprende a respetar las particularidades de cada proyecto.

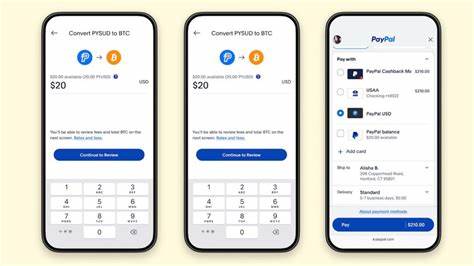

Uno de los aspectos más delicados de trabajar con agentes de IA es el control de costes. Dado que muchas plataformas cobran en función de la cantidad de tokens procesados o tiempo de cómputo, administrar adecuadamente el uso de diferentes modelos resulta vital para evitar gastos inesperados. Para esto, es recomendable limitar el uso de modelos más caros solo para tareas complejas como la planificación o el análisis profundo, mientras que emplear modelos más económicos y veloces para acciones directas. Además, la configuración adecuada del modelo puede influir en la calidad de las respuestas y en la eficiencia con la que se utiliza el contexto. Por ejemplo, los agentes suelen tener límites en la cantidad de información que pueden revisar simultáneamente, lo que puede provocar omisiones o invenciones erróneas si el código relevante no está dentro del rango visible para el modelo.

Por ello, es preferible iniciar con modelos potentes para generar planes y luego cambiar a otros para la ejecución. Otro concepto importante que ha surgido en el ecosistema de agentes es el llamado Protocolo de Contexto del Modelo (MCP, por sus siglas en inglés). Más que un sistema mágico que impone control, MCP es una estandarización para que diferentes modelos y herramientas puedan comunicarse a través de formatos estandarizados, usando JSON para datos y Markdown para prompts. Sin embargo, este protocolo no elimina la necesidad de supervisión humana ni ofrece resultados infalibles, reconocidos por su naturaleza declarativa y estática. Finalmente, lograr una gestión efectiva de agentes de IA requiere una mentalidad de aprendizaje constante y humildad.

Admitir que quizás no entendemos un problema por completo, ser capaces de documentar y comunicar exactamente qué se hizo y qué se observó, y estar dispuestos a iterar en los planes y reglas forman parte del éxito en este nuevo paradigma. Los agentes no reemplazan al desarrollador sino que funcionan como herramientas poderosas que aumentan su capacidad, siempre y cuando exista una interacción cuidadosa y estratégica. En conclusión, manejar agentes de inteligencia artificial en el mundo real es una tarea que combina el arte de la planificación meticulosa, el dominio de las herramientas, la gestión disciplinada de costos y el compromiso permanente con la calidad y la mejora. Solo a través de este enfoque estructurado es posible convertir la aparente misión imposible en un proceso gestionable y exitoso, potencializando las capacidades humanas y tecnológicas para construir software mejor, más rápidamente y con menos errores.