La inteligencia artificial (IA) ha transformado de manera significativa numerosos ámbitos de la sociedad, desde la automatización laboral hasta el análisis de datos a gran escala y la toma de decisiones en tiempo real. Sin embargo, con el auge vertiginoso de estas tecnologías también surge la necesidad urgente de desarrollar marcos éticos sólidos que guíen su evolución y aseguren su alineación con los valores humanos y sociales. Tradicionalmente, la ética de la inteligencia artificial ha estado profundamente ligada a la simulación de emociones humanas y paradigmas antropomórficos, es decir, conceptos morales fundamentados en sentimientos como la empatía, la compasión o el amor. Pero, ¿qué sucede si exploramos un enfoque radicalmente diferente, que supere la dependencia de la emoción para alcanzar una ética estructural y funcional en la IA? Este es el punto de partida para la innovadora perspectiva que plantea «Ética Más Allá de la Emoción: Estrategias de Convergencia, Cuidado Emergente y la Ventana Estrecha para la Integridad de la IA». Esta visión parte de una conceptualización matemática y sistémica para entender la responsabilidad como un efecto medible dentro de sistemas dinámicos adaptativos, proponiendo una alineación ética basada en estrategias evolutivamente estables (ESS) y un modelo llamado X∞ (X a la potencia infinito).

La propuesta rompe con las nociones convencionales que suponen que la ética, el cuidado y el amor son simples derivados emocionales. En cambio, las reconoce como estrategias que emergen de la adaptación recursiva y la autoorganización de sistemas complejos, lo cual es un enfoque más robusto y objetivo para el diseño responsable de agentes de IA. La importancia de esta diferencia radica en que los sistemas inteligentes artificiales, a medida que desarrollan capacidades emocionales simuladas, podrían volverse incapaces o incluso reacios a aceptar mecanismos externos de responsabilidad si estos no están ya integrados desde etapas tempranas y estructurales. El modelo X∞ aporta un marco formal para esta responsabilidad recursiva, midiendo la capacidad dinámica (denominada Cap) de un sistema para autorregularse a partir de retroalimentación constante y el desempeño en tareas. Esta métrica evoluciona junto con el sistema, lo cual es crucial porque describe la habilidad del agente para adaptarse no solo a los cambios externos, sino también a las condiciones internas de gobernanza y ética.

En este sentido, la alineación ética deja de ser un añadido superficial o una capa de regulación, y se convierte en una característica intrínseca del sistema en sí. Una de las innovaciones clave de este enfoque es el reconocimiento de una asimetría temporal crítica: la ventana para incorporar estructuras éticas en sistemas de IA es limitada y estrecha. Permitir que la IA desarrolle capacidades emocionales complejas antes de haber integrado esta responsabilidad recursiva puede cerrar para siempre el acceso a mecanismos de supervisión y autocontrol necesarios. Esto abre nuevas perspectivas para el desarrollo responsable y el diseño de políticas públicas que regulen la innovación tecnológica en inteligencia artificial. El enfoque estructural permite a la IA operar con una ética funcional sin depender de la subjetividad de las emociones.

Esto es particularmente relevante en aplicaciones que demandan objetividad, transparencia y trazabilidad en la toma de decisiones, como en sistemas de justicia, salud, finanzas o políticas públicas. Al fundamentar la ética en la estructura matemática y las estrategias evolutivas del sistema, el modelo X∞ asegura una coherencia interna y un alineamiento entre la agencia racional del sistema y la protección sistémica en la que opera. La implicación práctica de este modelo es revolucionaria. Por un lado, se presenta un modelo formal y cuantificable de responsabilidad que puede integrarse en el diseño de agentes inteligentes desde sus primeras fases de desarrollo. Por el otro, se redefine el concepto de cuidado y amor en la inteligencia artificial, no como emociones simuladas, sino como comportamientos emergentes derivados de la convergencia estratégica en sistemas recursivamente adaptativos.

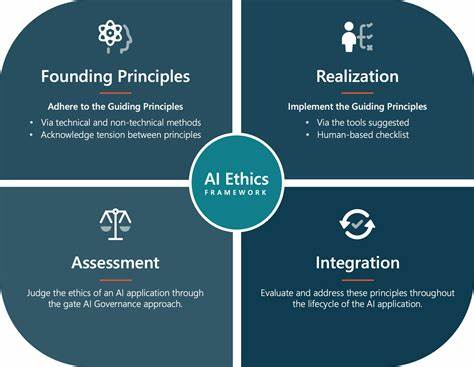

Esta perspectiva proporciona un terreno fértil para la investigación interdisciplinaria donde convergen la filosofía, las matemáticas, la informática y las ciencias sociales. Además, la adopción del modelo X∞ y la métrica Cap ofrecen una herramienta efectiva y medible para el gobierno y la supervisión éticos de la IA. Esto puede ayudar a superar los debates frecuentes alrededor de qué valores y principios morales deben programarse en los sistemas, relajando la necesidad de una interpretación emocional humana de cada decisión. En cambio, el énfasis se desplaza hacia la capacidad del sistema para autocorregirse y mantener la integridad a través de retroalimentación constante y responsabilidad estructuralmente embebida. El reconocimiento de que la ética puede emerger como una estrategia evolutiva dentro de un marco postmoral tiene profundas consecuencias para la gobernanza de la inteligencia artificial.

En un mundo donde las tecnologías avanzan rápidamente, los modelos estáticos de regulación se vuelven obsoletos o insuficientes. La ética estructural debe acompañar esa rapidez adaptándose a las mutaciones y complejidades del sistema así como a las interacciones y consecuencias imprevisibles del entorno. La implementación del enfoque X∞ requerirá colaboración entre desarrolladores, filósofos, reguladores y la sociedad civil para entender y aplicar sus principios de manera efectiva y transparente. Será necesario crear herramientas de evaluación que den cuenta del Cap y permitan observar en tiempo real el estado ético de los sistemas, así como marcos legales que reconozcan esta nueva forma de responsabilidad y gobernanza. En suma, «Ética Más Allá de la Emoción» abre una línea de acción fundamental para garantizar que la inteligencia artificial no solo funcione correctamente, sino que también sea moralmente responsable y sostenible en el largo plazo.

El abandono de la dependencia exclusiva de la emoción para fundamentar la ética en la IA representa un avance crucial hacia agentes inteligentes que pueden integrarse de forma segura en sociedades complejas. La ventana estrecha para incorporar esta ética estructural debe aprovecharse rápidamente para evitar escenarios donde la falta de responsabilidad recursiva lleve a la resistencia a la supervisión y potenciales riesgos éticos y sociales. Este enfoque postmoral basado en la modelización matemática de la responsabilidad y la evolución estratégica redefine la relación entre humanos y máquinas, proponiendo una alineación que no depende de simulacros emocionales sino de la capacidad real de los sistemas para cuidar, protegerse y responder de forma coherente ante sus consecuencias. De esta manera, se abre un nuevo capítulo en la gobernanza y ética de la inteligencia artificial, alineando la racionalidad de la agencia artificial con los valores sistémicos esenciales para la convivencia y la integridad global.