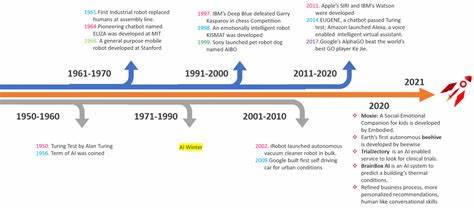

En el vertiginoso mundo del desarrollo tecnológico, la inteligencia artificial (IA) y, más concretamente, los modelos de lenguaje natural han experimentado un crecimiento exponencial durante los últimos años. Uno de los protagonistas indiscutibles en esta área es DeepSeek-Prover-V2-671B, un modelo de lenguaje a gran escala desarrollado por DeepSeek bajo licencia MIT. Esta innovadora arquitectura representa un salto notable en la generación y comprensión de texto, combinando sofisticación, versatilidad y escalabilidad para distintos usos profesionales y científicos. DeepSeek-Prover-V2-671B se caracteriza principalmente por su inmenso tamaño, con 671 mil millones de parámetros, lo que le permite procesar y generar textos con una fluidez y coherencia que superan a la mayoría de sus predecesores. Esta magnitud no solo significa mayor capacidad matemática para entender y relacionar información, sino que también se traduce en una mejora considerable en tareas de comprensión contextual, generación creativa de texto y diálogo conversacional complejo.

El modelo está disponible en la plataforma Hugging Face, un ecosistema clave para investigadores y desarrolladores que buscan acceder a tecnologías de inteligencia artificial punteras. Su licencia MIT proporciona un acceso libre y abierto, fomentando la innovación colaborativa y permitiendo su integración en múltiples proyectos, desde aplicaciones comerciales hasta experimentos académicos. Profundizando en sus características técnicas, DeepSeek-Prover-V2-671B utiliza la arquitectura Transformer, la cual ha revolucionado el procesamiento del lenguaje natural. Esta arquitectura permite manejar relaciones de largo alcance dentro de grandes cuerpos de texto, facilitando una comprensión más precisa del contexto y una generación coherente y natural del lenguaje. Lo que distingue a esta versión de DeepSeek-Prover es su optimización mediante formatos modernos como FP8, que mejora la eficiencia computacional y reduce la necesidad de grandes recursos sin sacrificar desempeño.

Además, el modelo se distribuye a través de varios archivos en formato Safetensors, un formato eficiente y seguro para manejar modelos de inteligencia artificial, lo que facilita la carga y despliegue en diferentes entornos. Su estructura modular permite a los usuarios desplegar solo las partes necesarias, optimizando el uso de memoria y la velocidad de respuesta. El modelo ha sido entrenado con una vasta cantidad de datos, incluyendo corpus conversacionales y textos especializados, lo que lo dota de una versatilidad significativa para responder a diferentes tipos de consultas o producir contenido en variadas temáticas. Su capacidad para mantener conversaciones coherentes y entender instrucciones complejas lo hace ideal para ser utilizado en sistemas de asistencia virtual, chatbots, generación de contenido automático y análisis semántico. Uno de los aspectos destacados de DeepSeek-Prover-V2-671B es su enfoque en el desarrollo colaborativo y open source, lo que permite a la comunidad mejorar continuamente sus capacidades.

La presencia de múltiples colaboradores en su repositorio y la actualización constante de sus versiones garantizan que el modelo se mantenga a la vanguardia, adaptándose a nuevas necesidades y tendencias en el sector del procesamiento del lenguaje natural. En términos de rendimiento, la implementación de DeepSeek-Prover-V2-671B sobresale en pruebas de generación de texto creativas y resolución de problemas complejos mediante razonamiento lingüístico. Esto lo convierte en una herramienta valiosa no solo para aplicaciones de generación de contenido, sino también para la automatización de procesos intelectuales, evaluación de datos y soporte en investigación. El modelo igualmente es compatible con frameworks populares de inteligencia artificial, facilitando su integración en sistemas ya existentes y permitiendo una adaptabilidad amplia. Gracias a esta compatibilidad, desarrolladores e investigadores pueden aprovechar la potencia del modelo sin necesidad de construir infraestructuras desde cero.