La llegada de la inteligencia artificial (IA) al ámbito tecnológico ha marcado un punto de inflexión que pocos podrían haber anticipado. El auge de los agentes de IA, esos asistentes automatizados que pueden escribir código, gestionar proyectos o incluso tomar decisiones complejas, ha abierto un abanico de posibilidades para desarrolladores, gestores y empresas en general. Sin embargo, gestionar estas herramientas aún parece una misión imposible para muchos, en parte por la velocidad a la que evoluciona esta tecnología y la complejidad que implica mantener un control efectivo sobre su comportamiento y resultados. En el núcleo de esta nueva frontera tecnológica se encuentra la necesidad de entender que los agentes de IA no son ni mágicos ni infalibles. Funcionan basándose en modelos de lenguaje entrenados con millones de líneas de código y textos, lo que significa que replican patrones y tendencias, no comprenden el contexto ni intuyen el propósito real de cada tarea.

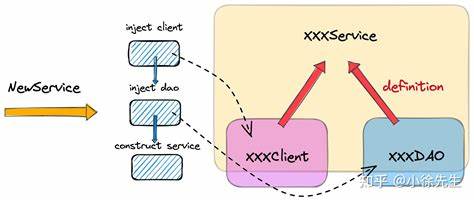

Así, para lograr resultados óptimos, la interacción humana con estos sistemas debe ser precisa, estructurada y cargada de buenas prácticas. Uno de los aspectos más importantes para manejar agentes de IA es la calidad de los insumos. Estos agentes procesan el código, los diagramas, los datos y, sobre todo, los prompts o instrucciones que reciben. Estos insumos son los materiales reales con los que trabajan, mientras que el software y las interfaces son solo herramientas. Por ello, la atención debe centrarse en cómo se redactan y estructuran estas solicitudes, procurando que sean claras, detalladas y adecuadamente contextuales.

Es fundamental aceptar que la técnica, es decir, el modo en que se combinan y presentan estos insumos, determina en gran medida la eficacia del agente. No basta con usar la última herramienta o modelo de IA; es necesario aprender a plantear las preguntas correctas, a segmentar las tareas en partes pequeñas y manejables, y a planificar de forma que el agente entienda cada paso sin confusión ni suposiciones erróneas. Aunque la idea de dejar que el agente resuelva cualquier problema automáticamente puede resultar tentadora, es un error común confiar en lo que se conoce como “vibe coding”, donde se pide al agente que genere código o soluciones sin un plan claro. Este método suele producir resultados superficiales o poco fiables, útiles solo para prototipos o demostraciones, pero no para productos finales. La solución está en fomentar el diseño de planes reutilizables, escritos en formatos legibles tanto por humanos como por máquinas, guardados y versionados junto con el código fuente.

Un plan bien elaborado no solo mejora la precisión del agente, sino que también sirve como documentación viva y referencial, facilitando futuras modificaciones o extensiones. Si el plan falla, el agente estará perdido durante su ejecución, creando código incoherente o incluso dañino para el proyecto. Por tanto, es responsabilidad del desarrollador o gestor supervisar, revisar y corregir estos planes antes de asignarlos al agente. Otra consecuencia de una buena planificación es evitar la sobrecarga de contexto que puede confundir al modelo de IA. Cuanto mayor sea la cantidad de información irrelevante o mal estructurada que se le ofrece, mayor será la probabilidad de fallos o desviaciones.

Por eso, es preferible limitar la extensión de los prompts al mínimo indispensable, utilizando referencias a planes o documentos externos para aportar detalles que el agente pueda consultar según sea necesario. Cuando se seleccionan las tareas adecuadas para los agentes de IA, también se debe tener en cuenta la naturaleza del cambio o el desarrollo. Modificaciones pequeñas y inmediatas suelen ser mejor hechas manualmente, mientras que para cambios complejos, repetitivos o refactorizaciones profundas, el agente se convierte en un aliado invaluable. Sin embargo, en estos casos se requiere que la arquitectura del código esté suficientemente bien diseñada para permitir intervenciones modulables y sin riesgos mayores. La integridad de la arquitectura también es vital para evitar esas trampas o “hoop jumping” donde el agente debe sortear obstáculos innecesarios debido a un diseño deficiente.

Por eso, no se debe intentar forzar al modelo a trabajar alrededor de malas decisiones técnicas: lo recomendable es corregir esos problemas estructurales con ayuda de la IA en modo exploración o investigación, limpiando el escenario para que las acciones futuras sean más eficaces y menos propensas a errores. En esta labor el desarrollador debe adoptar una actitud crítica y analítica, comprendiendo que todo fallo detectado apunta primero a la calidad del propio código y de las indicaciones dadas al agente, no únicamente a un posible “error” del sistema de IA. La transparencia, el autocuestionamiento y la disposición a iterar sobre planes y reglas con paciencia serán las mejores herramientas para superar esos obstáculos. Uno de los avances que ha potenciado la gestión de agentes de IA en entornos de trabajo colaborativos es la creación y manejo de archivos de reglas y planes que el agente puede consultar de forma automática o cuando se le indique. Estos archivos permiten introducir normas de estilo, patrones comunes, restricciones específicas y lineamientos que el agente usará durante su operación, asegurando coherencia y reduciendo riesgos de desviaciones dañinas.

Además, los planes no son simplemente listas secuenciales de pasos; suelen incluir ejemplos de código en múltiples lenguajes, anotaciones detalladas y formatos enriquecidos para que sean minuciosamente comprensibles y fácilmente editables. Guardar estos planes dentro del repositorio con mensajes claros en los commits facilita la trazabilidad y el control de versiones, clave para el mantenimiento a largo plazo. En cuanto a las pruebas y validación, confiar solamente en la capacidad del agente para testear su propio código es poco recomendable. Es mejor que el desarrollador realice las pruebas manuales, verifique los resultados en entornos controlados y utilice los fallos detectados para pedir un plan de corrección al agente. Este enfoque, aunque laborioso, evita que se perpetúen errores ocultos o falsamente solucionados con datos ficticios.

La gestión económica de estos sistemas también es una parte crítica. El coste por uso de modelos que operan en la nube puede aumentar rápidamente si no se configuran adecuadamente los límites de gasto y se seleccionan modelos según las necesidades específicas de cada tarea. Es preciso mantener un balance inteligente entre modelos más económicos para acciones directas y modelos más costosos y potentes para planificar o procesar tareas complejas. El famoso concepto del “Master Control Program” o MCP, que en la cultura popular sugiere un ente capaz de controlar a todos los agentes de IA, no es otra cosa que un protocolo estándar para comunicar modelos y herramientas entre sí. Este protocolo facilita la integración y coordinación, pero no ofrece un control absoluto ni mago a la hora de supervisar la conducta de cada agente.

Por último, la eficacia en la gestión de agentes de inteligencia artificial dependerá de la capacidad humana para combinar la comprensión técnica, la comunicación clara y la disciplina en el desarrollo. Los agentes no reemplazan al programador ni al arquitecto de software, sino que amplifican su potencial, permitiendo realizar tareas repetitivas, optimizar refactorizaciones y generar documentación actualizada. La transición hacia un futuro donde las máquinas colaboren activamente en el desarrollo de software exige nuevas formas de pensar y trabajar, alejadas del proceso intuitivo tradicional y orientadas hacia métodos meticulosos, documentados y escalables. Los profesionales que adopten esta mentalidad lograrán no solo aprovechar las herramientas actuales, sino estar preparados para las innovaciones que inevitablemente llegarán. En resumen, gestionar agentes de IA en el mundo real resulta un desafío multifacético que va desde la planificación detallada hasta la revisión constante, pasando por la selección adecuada de modelos y el control de costos.

Aunque parece una misión imposible, con las estrategias y herramientas correctas es posible conducir estas tecnologías para obtener resultados sólidos, reutilizables y económicamente viables. La clave está en controlar el contexto, conocer a fondo las herramientas y no abandonar nunca el rigor humano que garantiza calidad y coherencia.