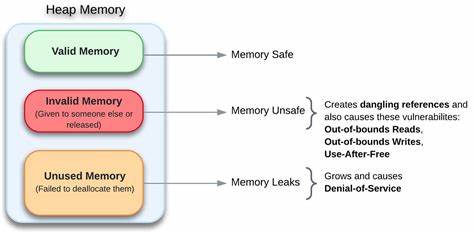

En el ecosistema tecnológico actual, la seguridad de la memoria se ha convertido en una preocupación central para desarrolladores, ingenieros y profesionales de la seguridad. La creciente dependencia de sistemas informáticos complejos y la magnitud de las amenazas que enfrentan exigen enfoques rigurosos para minimizar los errores de memoria que pueden ser explotados fácilmente por atacantes. La memoria, que es el alma del cómputo moderno, también es su punto más vulnerable, convirtiendo su protección en una prioridad ineludible. El concepto de seguridad de la memoria no es nuevo, pero su importancia se ha intensificado debido a la naturaleza cambiante del software y las arquitecturas de hardware que lo sustentan. Tradicionalmente, los lenguajes de programación como C y C++ han sido relegados a la categoría de “no seguros” por permitir manipulaciones directas de punteros, accesos fuera de límites y errores de gestión de memoria.

Sin embargo, estos lenguajes siguen siendo cruciales para sistemas de bajo nivel y software de alto rendimiento, lo que plantea un verdadero desafío a la hora de garantizar la seguridad sin sacrificar eficiencia. A pesar de las críticas, la garantía absoluta de seguridad no recae únicamente en la elección del lenguaje. La seguridad de la memoria representa un campo interdisciplinario que fusiona la ciencia computacional con la teoría de la complejidad, y requiere un enfoque multifacético que combine diseño de lenguajes, soporte de herramientas, técnicas de análisis estático y dinámico, así como rigurosas prácticas de ingeniería. Además, el auge de lenguajes de programación diseñados para ser inherentemente seguros, tales como Rust, ha aportado nuevas herramientas a la mesa, pero no son la panacea definitiva. Reescribir grandes bases de código para migrarlas a estos lenguajes seguros es un proceso costoso, complejo y que en muchos casos no es factible.

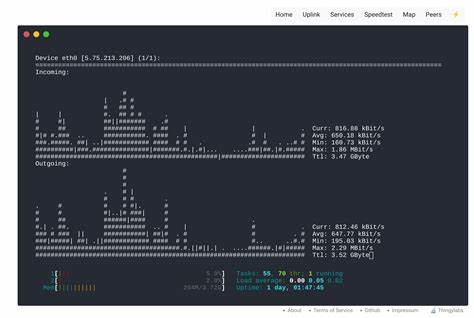

Muchas aplicaciones críticas y bibliotecas aún dependen de ecosistemas que no pueden ser migrados rápidamente. Por lo tanto, la solución realista involucra la coexistencia y mejora progresiva de sistemas existentes con prácticas y mecanismos complementarios. En proyectos como HardenedLinux, se ha apostado por fortalecer las bases de sistemas GNU/Linux aplicando metodologías avanzadas para mitigar riesgos asociados a la memoria, aprovechando distribuciones comunitarias con mantenedores expertos. La implementación extendida de sanitizadores y fuzzers ha revolucionado el ciclo de aseguramiento de calidad, permitiendo detectar y corregir vulnerabilidades antes de que dichas brechas puedan ser explotadas. Los fuzzers, herramientas que ejecutan pruebas de estrés enviando entradas aleatorias o maliciosas para identificar errores, junto con sanitizadores, que detectan comportamientos inseguros durante la ejecución, forman una línea de defensa sofisticada capaz de alcanzar altos niveles de cobertura de código.

Esto es especialmente visible en componentes críticos como el kernel de Linux, donde se han contribuido mejoras significativas a herramientas de fuzzing con el desarrollo de modelos basados en estados y funcionalidades de filtrado, dando lugar a proyectos emblemáticos como VaultFuzzer. Se debe resaltar que, aunque estas pruebas pueden alcanzar porcentajes elevados de cobertura, empíricos valores como el 72% en el caso de partes de la pila de protocolos de red, una proporción restante de código permanece sin explorar totalmente. Frente a esta realidad, es fundamental implementar estructuras de mitigación que puedan actuar en el tiempo de ejecución, generando capas adicionales de protección que limiten el impacto de posibles vulnerabilidades que no hayan sido detectadas en fases previas. Más allá de la detección proactiva, existen diversas técnicas de mitigación orientadas tanto a nivel hardware como software. Los procesadores modernos integran características como NX (No Execute), CET (Control-flow Enforcement Technology) y BTI (Branch Target Identification), que son vitales para contener exploits.

Complementariamente, medidas en compiladores y runtime, tales como canarios de pila, pilas sombra, fortalecimiento de fuentes, asignaciones de memoria con ASLR y protección de flujo de control, han demostrado ser herramientas esenciales para robustecer la seguridad del software. En el ámbito del software escrito en C/C++, innovadoras iniciativas como Fil-C, de Epic Games, representan una evolución destacable. Esta solución adapta el compilador Clang/LLVM para incorporar verificaciones avanzadas que ilimitan los tipos más comunes de errores de memoria desde la raíz, facilitando la compilación de componentes críticos sobre un runtime independiente con garantía de seguridad desde el punto de vista de la exploitabilidad. Aunque actualmente aún está en desarrollo y mejora continua, su avance podría transformar la manera en que se aborda la seguridad en proyectos que dependen altamente de estos lenguajes. Sin embargo, la pregunta sobre la necesidad o no de abandonar el código legado por completo en favor de lenguajes seguros sigue siendo recurrente en el debate técnico.

La realidad indica que la sustitución total e inmediata no es práctica ni económica, y la experiencia demuestra que aún proyectos líderes en el desarrollo, como Google o OpenSSL, enfrentan desafíos en alcanzar una cobertura perfecta. Por esta razón, independientemente de la tecnología adoptada, la responsabilidad de implementar prácticas seguras y emplear herramientas que detecten defectos en las fases tempranas de desarrollo es una tarea colectiva y necesaria. Esta filosofía ha llevado a HardenedLinux y otros actores a exhortar a los desarrolladores de software libre y de código abierto a incorporar en sus ciclos de desarrollo el uso sistemático de sanitizadores en builds de depuración y testing. Esta iniciativa no solo ayuda a mejorar la calidad sino que se presenta como el camino de menor costo para consolidar un ecosistema más seguro, brindando beneficios considerables a la comunidad global de desarrollo. Para los proyectos que sí decidan avanzar hacia la reescritura de sus componentes en lenguajes con garantizada seguridad de memoria, existe una opción añadida en escenarios específicos.

Tras la mirada histórica, lenguajes como Lisp/Scheme, a pesar de ser antiguos, poseen características que los hacen interesantes para ciertas tareas por su manejo de memoria y su flexibilidad, aunque requieren evaluación cuidadosa según los requerimientos técnicos y de rendimiento. En conclusión, el camino hacia la seguridad de la memoria es inevitable y exige un enfoque integral. No corresponde solamente a los compiladores o al tiempo de ejecución, sino a la combinación de diseño robusto de lenguajes, análisis estático y dinámico, esfuerzos de mantenimiento disciplinado y mitigación continua. Solo con esta convergencia será posible alcanzar sistemas que resistan los ataques cada vez más sofisticados que afectan el núcleo mismo de la informática moderna. Proteger la memoria es proteger la integridad, confidencialidad y disponibilidad de los sistemas.

En un mundo dependiente de la tecnología, la seguridad de la memoria ya no es un lujo, sino una necesidad ineludible para asegurar un futuro digital confiable y resistente a la amenaza constante de vulnerabilidades.

![Switch 2 confirms the use of the T239 chip [video]](/images/7FAD982A-0479-4C41-AD84-DA859B56B4CE)