En la actualidad, los modelos de lenguaje basados en inteligencia artificial han generado una gran expectativa dentro de la comunidad de desarrolladores de software. La capacidad de generar código a partir de instrucciones en lenguaje natural parecía ser el siguiente gran salto en la automatización y optimización de las tareas de programación. Sin embargo, al analizar ciertos casos específicos, especialmente en lenguajes con características de tipado estático y genéricos como Go, se evidencian limitaciones que imposibilitan la creación correcta y eficiente de ciertos patrones de código. Uno de los problemas más notorios se encuentra al intentar implementar métodos genéricos dentro de tipos genéricos, una funcionalidad que el lenguaje Go restringe con claridad en su documentación oficial y que genera conflictos cuando se intenta abordar con inteligencia artificial. El ejemplo paradigmático es la creación de un tipo Result[T] que maneje valores y errores, inspirado en el modelo Rust Result<T, E>, siendo necesario que la estructura permita encadenar métodos Map para transformar el valor sin alterar el error.

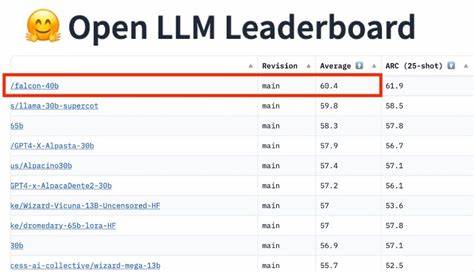

Aunque este concepto es sencillo para un programador experimentado, los LLM (modelos de lenguaje de gran escala) suelen verse atrapados en soluciones que no se ajustan a las reglas del lenguaje Go, repitiendo la misma aproximación errónea incluso tras correcciones reiteradas. Esto se debe a que Go permite definir métodos en tipos genéricos, pero no permite que esos métodos tengan parámetros de tipo independientes que genericen la función en sí. La consecuencia directa es que un método como Map[U any](func(T) U) Result[U] no es válido en Go y no compila. No obstante, los modelos de lenguaje suelen intentar forzar esta forma, sugiriendo estructuras envolventes adicionales o intentos de redefinir la implementación sin resolver la raíz del problema. Esta especie de «anclaje» en una solución incorrecta revela la dificultad que tienen los modelos para comprender y adaptarse a limitaciones técnicas específicas y bien documentadas.

Otro aspecto significativo es el contexto limitado en el que operan los modelos de lenguaje: no pueden ejecutar ni validar código, ni realizan un análisis profundo de las reglas del lenguaje. Por ello, tienden a generar código que se ajusta a patrones comunes aprendidos a partir de grandes volúmenes de datos, pero que no necesariamente cumple con las restricciones formales de un determinado lenguaje o paradigma. La frustración al usar estas herramientas puede ser alta para desarrolladores que requieren soluciones fiables y correctas desde la primera generación, especialmente en proyectos donde la robustez y el comportamiento predecible son imprescindibles. Sin embargo, esto no implica que los modelos de lenguaje carezcan de utilidad para la programación. Para tareas de programación en gran escala, refactorización, generación de test, comentarios o asistencia en tareas repetitivas y rutinarias, los modelos pueden ser aliados importantes.

La clave está en entender sus límites y complementar su uso con la supervisión y juicio experto humano. Además, este caso pone de manifiesto la importancia de documentar y estudiar los llamados «disfuncionamientos» de los modelos de lenguaje en ámbitos técnicos específicos. La creación de un repositorio o colección de ejemplos donde se identifiquen patrones recurrentes de errores o soluciones inadecuadas sería fundamental para mejorar la interacción entre humanos y IA, así como para orientar el desarrollo futuro de estas tecnologías. Entender qué tipo de problemas los modelos aún no pueden manejar adecuadamente permitirá enfocar las investigaciones hacia áreas de mejora concretas y ayudará a los desarrolladores a tener expectativas realistas. Por otro lado, el desarrollo del lenguaje Go también evoluciona, y aunque hoy en día no se permite la creación de métodos genéricos con parámetros tipo independientes, no se puede descartar que futuras versiones incorporen esta funcionalidad.

La comunidad debería estar atenta a estos cambios para aprovechar las capacidades de los modelos de lenguaje conforme evolucionen tanto las herramientas como los lenguajes de programación. En definitiva, la interacción con modelos de lenguaje para la generación de código muestra que, pese al gran avance tecnológico, todavía existen barreras técnicas y conceptuales importantes que requieren atención. Los desarrolladores deben ejercer un control crítico y no entregar ciegamente la resolución de problemas complejos a una IA. Reconocer y comprender estas limitaciones es un paso necesario para la integración responsable y efectiva de la inteligencia artificial en el ciclo de desarrollo de software, aprovechando sus ventajas y mitigando sus deficiencias. En resumen, la experiencia con la implementación de métodos genéricos en Go por parte de LLMs evidencia una manifestación clara de sus limitaciones técnicas actuales.

La perseverancia de estos modelos en una solución incorrecta revela tanto la necesidad de una mejora en la comprensión contextual como un llamado a la colaboración humana para corregir y guiar este tipo de herramientas. Solo con un abordaje conjunto y consciente se podrá avanzar hacia un entorno en que la inteligencia artificial sea un recurso confiable y eficiente para la programación profesional.