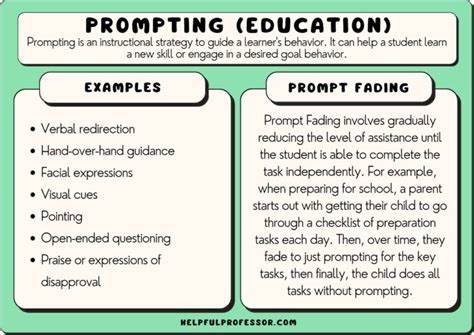

En la era actual, donde la inteligencia artificial se ha convertido en una herramienta fundamental para la creación de contenido, la interacción directa con modelos de lenguaje como ChatGPT es esencial para obtener resultados precisos y útiles. Sin embargo, un aspecto que a menudo se pasa por alto es el arte del prompting, o cómo formular preguntas y solicitudes de manera óptima para guiar a estas inteligencias artificiales hacia las respuestas más relevantes y acertadas. El concepto de prompting va más allá de simplemente ingresar texto y esperar una respuesta. Se trata de la habilidad para diseñar instrucciones claras, específicas y estratégicas que permitan al modelo entender el contexto, el tono y el objetivo deseado. A pesar de su importancia, la literatura y las guías prácticas sobre cómo realizar prompting efectivo aún son limitadas, provocando que muchos usuarios no aprovechen al máximo estas potentes herramientas.

Una de las preguntas más comunes y aparentemente sencillas es cómo solicitar un resumen eficaz de un artículo o texto. Aunque parece una tarea básica, obtener un resumen que no solo recorra el contenido sino que identifique los puntos clave y las ideas más sorprendentes requiere de técnicas específicas. Explorar métodos como pedir que se citen directamente las frases que mejor ilustran los temas principales puede ayudar a extraer contenido más rico y fiel a la fuente original. Otra estrategia vital es definir claramente el propósito del prompt. Por ejemplo, si se busca un resumen técnico, el prompt debe incluir instrucciones para mantener términos especializados y evitar simplificaciones excesivas.

Si el objetivo es un resumen para un público general, entonces el lenguaje debe ser accesible y claro. Esta adaptación es crucial para que el modelo de lenguaje entregue respuestas que se ajusten a las necesidades específicas de cada usuario. Además, la estructura del prompt puede influir significativamente en la calidad de la respuesta. Comenzar con una breve descripción del contexto antes de realizar la petición ayuda al modelo a situarse mejor y a entregar resultados más precisos. En lugar de pedir "Resume el artículo", una fórmula más efectiva puede ser "Lee este artículo sobre avances tecnológicos y resume las ideas principales, resaltando cualquier innovación destacada y sus posibles impactos".

Explorar la técnica de hacer preguntas sucesivas o encadenadas también potencia el diálogo con los modelos de lenguaje. Al dividir una consulta extensa en varias preguntas más específicas, se puede profundizar gradualmente en un tema, permitiendo obtener información detallada sin perder claridad ni relevancia. Este método facilita además la corrección o ajuste de las solicitudes en función de las respuestas previas, mejorando la interacción y resultados. La experimentación con estilos y tonos en los prompts es otra herramienta interesante. Indicar al modelo que responda con un tono formal, coloquial, técnico o incluso creativo puede variar considerablemente la utilidad y adecuación del contenido generado.

Esto es especialmente valioso en contextos profesionales, educativos o artísticos donde el estilo del texto tiene un impacto directo en su recepción. La inclusión de ejemplos dentro del prompt puede guiar aún más a los modelos de lenguaje. Cuando un usuario proporciona un ejemplo claro de la respuesta esperada, el modelo puede imitar ese formato y enfoque, mejorando la coherencia y relevancia de la respuesta. Esta práctica es útil en tareas como creación de listas, elaboración de explicaciones detalladas o generación de textos con estructuras particulares. Otro aspecto fundamental es la limitación del alcance o extensión de la respuesta solicitada.

Pedir respuestas breves o extensas según el objetivo ayuda a manejar mejor la información obtenida. Para resúmenes concisos, podría ser beneficioso limitar la respuesta a un número específico de frases o párrafos. En cambio, para análisis profundos, se puede solicitar un desarrollo más amplio que incluya comparaciones, ejemplos y matices. Cuando se trata de temas complejos o técnicos, establecer definiciones o aclarar términos dentro del prompt puede evitar malentendidos o respuestas erróneas. Esto es especialmente relevante para campos especializados donde el vocabulario y las referencias específicas son clave para un buen desempeño del modelo.

La consideración de sesgos y limitaciones inherentes a los modelos es un factor que no debe dejarse de lado. Aunque el prompting puede optimizar respuestas, es importante reconocer que estas inteligencias artificiales no son infalibles ni poseen conocimientos actualizados en tiempo real. Por ello, los usuarios deben complementar la información generada con fuentes confiables y mantener un enfoque crítico. En resumen, dominar las técnicas de prompting es fundamental para maximizar el potencial de los modelos de lenguaje en la generación de contenido. Desde definir con claridad los objetivos, contextualizar las solicitudes, ajustar el estilo y tono, hasta emplear preguntas encadenadas y ejemplos concretos, cada detalle cuenta para conseguir respuestas satisfactorias y precisas.

La expansión del conocimiento y la publicación de más guías especializadas en prompting son necesarias para que tanto usuarios novatos como expertos puedan beneficiarse plenamente. A medida que la inteligencia artificial evoluciona, también lo deben hacer las estrategias para interactuar con ella, fomentando un uso eficiente, ético y creativo que impulse la innovación y productividad en diversos ámbitos. Explorar y compartir estas técnicas permitirá que la comunidad crezca y se enriquezca, facilitando un acceso más amplio a herramientas avanzadas y promoviendo su adopción en sectores variados. La inversión en educación y recursos sobre prompting es, sin duda, un paso decisivo para aprovechar al máximo las capacidades de la inteligencia artificial actual y futura.