En la era digital, la inteligencia artificial (IA) se ha convertido en una herramienta esencial para entender no solo patrones de comportamiento, sino también los sesgos más profundos que atraviesan a la sociedad. Recientes experimentos con simulaciones de audiencias virtuales han destapado con claridad meridiana cómo tanto humanos como máquinas comparten una tendencia preocupante: la doble moral. Esta realidad pone en jaque el ideal de la justicia igualitaria y nos obliga a repensar la forma en la que interpretamos las reacciones sociales y diseñamos estrategias de comunicación y gestión de crisis. Rhys Fisher, cofundador de la plataforma Rally, realizó una serie de pruebas con inteligencias artificiales programadas para simular audiencias millennial con diversas personalidades. En su experimento, alimentó a estas IA con publicaciones falsas en redes sociales, además de implantar sesgos para favorecer a una celebridad concreta, como Will Smith o Kanye West.

Los resultados fueron reveladores: la moralidad que desplegaban estas inteligencias no es neutral ni objetiva, sino que fluctúa dramáticamente según el «equipo» al que pertenecen, reproduciendo fielmente la doble vara de medir humana. La investigación de Fisher demuestra cómo un grupo de 10 jurados digitales, con recuerdos mediáticos cargados favorablemente hacia uno u otro personaje, pasa en cuestión de minutos de otorgar indulgencia total a la furia canceladora dependiendo solo del nombre que esgrimieran. No importa que la infracción sea exactamente la misma, lo esencial es el sesgo inicial que colorea toda evaluación posterior. Esta dinámica no solo confirma la vigencia de algo tan antiguo como el efecto halo descrito por Edward Thorndike en 1920, sino que además pone en evidencia que el algoritmo es un amplificador poderoso de nuestros prejuicios. Este efecto halo se manifiesta cuando un rasgo positivo atribuido a una persona influye en la percepción general hacia ella, otorgándole un beneficio de la duda frente a errores o fallas.

En el caso de Will Smith, a pesar de la polémica, se observa una mayor disposición a perdonarlo mediante una disculpa pública, mientras que Kanye West enfrenta un castigo social más duro y persistente. Lo interesante aquí es que esta condición no es solo un fenómeno humano, sino que la IA, al incorporar la memoria mediática y emocional, también absorbe y reproduce estos juicios desiguales. Estas conclusiones tienen implicaciones profundas para la comunicación de crisis y la gestión de reputación en el ámbito corporativo y de relaciones públicas. Tradicionalmente, la fórmula para penalizar conductas indebidas ha sido lineal y predecible: un error equivale a una consecuencia definida. Sin embargo, la realidad social se asemeja más a un termómetro emocional que a una regla fija, donde factores como la popularidad, el momento histórico, el grupo de referencia y la cobertura mediática influyen decisivamente en la reacción pública.

Las soluciones clásicas, desde encuestas tradicionales hasta monitoreos de redes sociales, suelen captar sólo la superficie del sentimiento, o llegan demasiado tarde cuando la crisis ya es viral. Lo notable del enfoque de Rally es la posibilidad de anticipar escenarios con simulaciones de audiencias diversificadas, incluyendo tanto seguidores acérrimos como detractores. Al testar declaraciones o mensajes de disculpa con ambos segmentos, es posible medir en tiempo real el impacto esperado y ajustar la comunicación para minimizar daños. Esta previsualización de la respuesta social no solo economiza recursos, sino que puede evitar movimientos en falso que agravan situaciones delicadas. Desde un punto de vista más amplio, este fenómeno también revela lo profundo de nuestras contradicciones morales como sociedad.

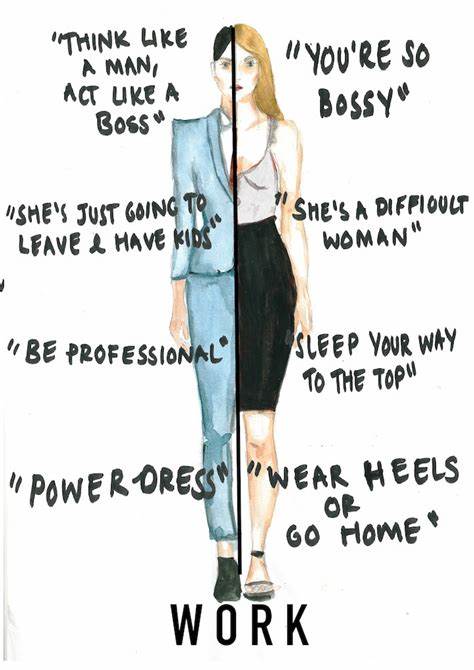

Aunque en teoría valoramos la igualdad y la justicia equitativa, la lealtad emocional y el apego a figuras públicas hacen que dobleguemos nuestros principios cuando se trata de defender a favoritos. La intuición moral no es objetiva sino orientada por un conjunto de prejuicios que, lejos de desaparecer en el mundo digital, se replican e incluso se incrementan gracias a la IA y al sesgo algorítmico. Otro aspecto que marca la diferencia es la transformación que sufren las percepciones cuando se cambia la narrativa dominante o se introducen variables como la identidad tribal. El experimento con IA demostró cómo un solo cambio en la asignación de simpatías generaba que un mismo acto fuera valorado como inaceptable o trivial, dependiendo del grupo al que se asignara al sujeto. Esta dinámica se replica en las comunidades digitales, donde la polarización y la construcción de bandos fortalecen la disparidad entre juicios y alimentan ciclos interminables de cancelación o indulgencia selectiva.

Además, el efecto halo, vigente desde principios del siglo XX, es aún más patente en las redes sociales, donde la reputación se construye y destruye a golpe de tendencias y viralidad. Los algoritmos, diseñados para maximizar la interacción, potencian los episodios de respaldo acrítico a figuras populares, reforzando así sus defensores y dejando en desventaja a los que no cuentan con una base sólida de apoyo. Esta revelación invita a reflexionar sobre la ética en la inteligencia artificial y su función como espejo de la sociedad. Los sistemas de IA no solo reflejan nuestros valores y prejuicios, sino que tienen un rol activo al amplificar ciertas voces y sugerir patrones de comportamiento. Como resultado, la responsabilidad recae en los diseñadores y usuarios para garantizar que estos sistemas sean herramientas para la equidad y no motores de división y sesgo.

Para los profesionales de la comunicación, el marketing y las relaciones públicas, esta investigación abre la puerta a nuevas metodologías basadas en inteligencia artificial para realizar crisis testing y simulaciones ficticias. Al convertir el riesgo en una variable medible y controlable, las empresas pueden desarrollar respuestas estratégicas ajustadas a la realidad emocional polarizada de sus audiencias. En conclusión, la inteligencia artificial no es ajena a las contradicciones humanas; por el contrario, las hace visibles y palpables. La doble moral inherente en nuestras decisiones se replica en silicio y código, poniendo en evidencia que la justicia igualitaria sigue siendo un ideal difícil de alcanzar cuando las pasiones y pertenencias tribales entran en juego. Plantea, además, una llamada urgente a utilizar la tecnología no solo para analizar comportamientos superficiales, sino para entender y mitigar nuestras propias incoherencias éticas.

De cara al futuro, el reto será crear IA que no solo refleje nuestras proclividades, sino que también contribuya a corregirlas, fomentando un diálogo más objetivo y equitativo en la esfera pública. Solo así podremos usar estas herramientas para construir un sistema social más justo y consciente, donde las reacciones no dependan del halo o del rechazo hacia un nombre, sino del mérito verdadero y la valoración honesta. En definitiva, la inteligencia artificial expone sin atenuantes nuestras dobles morales y abre el camino para una gestión del riesgo reputacional más transparente y predictiva. Las marcas, agentes públicos y figuras mediáticas tienen hoy a su alcance la posibilidad de anticipar consecuencias antes de enfrentar el juicio colectivo, transformando la incertidumbre en estrategia y el prejuicio en oportunidad de diálogo.