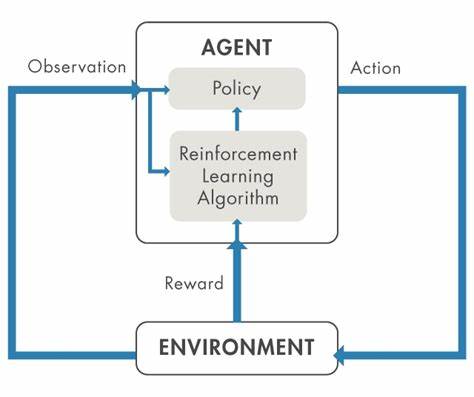

En la era actual de la inteligencia artificial, los modelos de lenguaje a gran escala (LLMs) se han convertido en herramientas indispensables para diversos profesionales. Desde desarrolladores de software hasta creadores de contenido, el uso de estos modelos ha revolucionado la forma en que se abordan tareas complejas. Sin embargo, a medida que su capacidad aumenta, también lo hacen los desafíos para garantizar que su rendimiento sea óptimo y confiable. Aquí es donde cobran relevancia las evaluaciones privadas, conocidas también como "private evals". Estas evaluaciones no sólo transforman la manera en que interactuamos con los modelos de lenguaje, sino que también potencian nuestra habilidad para aprovecharlos de forma crítica y estratégica.

El concepto de evaluaciones privadas surge como una respuesta a la necesidad de filtrar y validar la información proporcionada por LLMs. Mientras que los usuarios principiantes se conforman con un enfoque más pasivo, confiando en la generación de respuestas sin cuestionarlas, los usuarios avanzados adoptan una postura activa que combina juicio, escepticismo y experiencia para evaluar la calidad y utilidad del contenido generado. Esta actitud permite separar lo realmente útil de la mera apariencia de competencia. En muchas ocasiones, las evaluaciones privadas se convierten en la barrera esencial contra errores, sesgos y alucinaciones que pueden surgir del procesamiento del lenguaje natural. Es fundamental entender que el crecimiento exponencial de LLMs y su integración en tareas complejas hace que confiar ciegamente en sus respuestas sea un riesgo.

La opacidad en el desarrollo de estos modelos, la concentración del poder en unas pocas entidades y la falta de transparencia en sus operaciones, similitud con estructuras jerárquicas rígidas, plantean dudas sobre la fiabilidad absoluta de sus ejecuciones. Por lo tanto, implementar evaluaciones privadas se convierte en un acto de autonomía y responsabilidad profesional, devolviendo a los usuarios cierto control sobre el resultado final. A la hora de seleccionar las evaluaciones adecuadas, conviene partir de la experiencia propia. Revisar el historial de interacciones con los modelos de lenguaje es un buen punto de partida para identificar las áreas más críticas y recurrentes donde la precisión y calidad son imprescindibles. En lugar de dispersarse en pruebas generales, enfocarse en problemas específicos y relevantes para la propia labor cotidiana asegura que la inversión de tiempo y recursos tenga un retorno real.

Además, plantear automatizaciones inteligentes para algunas evaluaciones puede ser práctico, pero no debe volverse una obsesión. No todo es automatizable y muchas evaluaciones requieren una revisión manual cuidadosa para captar matices complejos. La habilidad para diseñar evaluaciones eficientes estriba en varios factores clave. En primer lugar, estas deben centrarse en áreas donde se posea un conocimiento profundo. Con esto se evita la confusión y se garantiza una señal clara del rendimiento real del modelo.

Por ejemplo, un profesional del derecho estaría mejor capacitado para crear evaluaciones en temas legales que un aficionado. En segundo lugar, las pruebas deben dirigirse a aspectos de verdadero interés, que impacten en la labor diaria y cuyo dominio determine diferencias palpables en el desempeño. Otro elemento decisivo es el nivel de dificultad. Para que una evaluación aporte valor, debe suponer un reto tanto para el usuario como para el modelo de lenguaje. Si la tarea es demasiado sencilla, el esfuerzo en evaluarla se vuelve ineficiente y poco provechoso.

En cambio, aquellas que representan desafíos significativos impulsan mejoras en la comprensión de las capacidades y limitaciones reales de los modelos. Finalmente, una diversidad en el tipo de evaluaciones ayuda a captar la versatilidad de los LLMs y su utilidad en múltiples contextos, desde programación hasta redacción, diseño y recomendaciones. Por ejemplo, en el área de recomendaciones, pedir al modelo que sugiera el mejor café en una zona local es una evaluación reveladora. Mientras un experto local puede dar una respuesta precisa basada en conocimiento real, los LLMs tienden a recomendar lugares cerrados o desactualizados, lo que muestra una limitación evidente. Este tipo de pruebas evidencia que aunque los modelos son impresionantes para ciertas tareas, en contextos que requieren conocimiento contemporáneo y específico aún quedan muchas oportunidades de mejora.

En materia de revisión de código y detección de errores, los modelos de lenguaje se desempeñan con notable eficacia. Detectar bugs en fragmentos amplios de código y explicar sus causas es una tarea compleja en la que los LLMs pueden ser de gran ayuda, siempre y cuando exista un marco de evaluación que valide su diagnóstico y asegure su precisión. La automatización en estas evaluaciones, incluyendo la ejecución sandbox para código generado, es una estrategia esencial para mantener la seguridad y la funcionalidad. Respecto a diseños y algoritmos, aunque las evaluaciones en esta categoría suelen requerir un conocimiento detallado y especializado, su implementación puede aportar insights valiosos sobre la elección de estrategias óptimas para problemas particulares, como la optimización del almacenamiento de archivos basada en predicciones de popularidad futura. Estas evaluaciones permiten contrastar diferentes enfoques y obtener una visión crítica que va más allá de la generación automática.

El ámbito de la redacción también se beneficia de las evaluaciones privadas. Aun cuando en un inicio pueda existir escepticismo sobre la capacidad de los modelos para escribir o editar texto de calidad, con un método adecuado de revisión y comparación, se ha comprobado que los LLMs pueden aportar retroalimentaciones útiles que mejoran significativamente la claridad y coherencia de los textos. Desde la perspectiva técnica, existen marcos y herramientas que facilitan la definición y ejecución de evaluaciones privadas. Aunque algunas soluciones pueden resultar complejas y adaptadas para pruebas públicas o de alto nivel, una alternativa más sencilla y asequible está al alcance de usuarios interesados que usan recursos mínimos y automatización básica. La ejecución periódica y cronificada de estas pruebas garantiza un monitoreo continuo y una actualización permanente del rendimiento de los modelos frente a las necesidades cambiantes.

Al construir un sistema propio de evaluaciones, el usuario experimentado adquiere una ventaja estratégica. Pasa de la mera confianza en resultados, a una gestión activa y crítica de la tecnología, desmitificando el funcionamiento de los LLMs y permitiendo un mejor aprovechamiento de sus capacidades. En este proceso, el usuario se convierte en un artesano de herramientas digitales, capaz de adaptar y personalizar soluciones para sus propios desafíos. En conclusión, frente al acelerado desarrollo de los modelos de lenguaje y su creciente integración en el ámbito profesional y cotidiano, contar con evaluaciones privadas constituye una práctica esencial para garantizar resultados fiables, evitar errores y maximizar el valor aportado por estas tecnologías. Esta estrategia ayuda a formar usuarios más conscientes, críticos y competentes, que no solo consumen sino que moldean activamente las herramientas del futuro.

La adopción de evaluaciones privadas es, en esencia, un acto de empoderamiento tecnológico. Quienes lo implementan pasen a liderar la interacción humana con la inteligencia artificial, transformando el flujo de tokens en conocimiento seguro y aplicable. Así, el potencial disruptivo de los LLMs se canaliza hacia un impacto tangible y positivo en múltiples campos, colocando a los usuarios más hábiles y exigentes un paso adelante en la revolución digital que estamos viviendo.