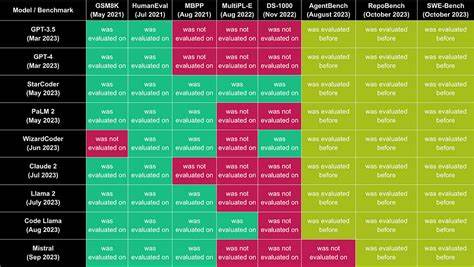

Los modelos de lenguaje de última generación, conocidos como LLM (Large Language Models), están revolucionando múltiples ámbitos tecnológicos, y uno de los campos más prometedores es la generación automática de consultas SQL a partir de lenguaje natural. Esta capacidad permite que usuarios sin conocimientos técnicos puedan interactuar con bases de datos complejas y obtener información precisa sin necesidad de dominar el lenguaje de bases de datos. Sin embargo, no todos los modelos son iguales, y evaluar su rendimiento en entornos reales resulta fundamental para entender qué tan efectivos son en términos de precisión, eficiencia y tiempo de respuesta. El benchmark de generación de SQL con LLM evalúa distintos modelos populares por su capacidad para traducir preguntas formuladas en lenguaje natural en consultas SQL eficaces y exactas. Para esta evaluación se utilizó un conjunto de datos realista y masivo proveniente de GH Archive, con un volumen aproximado de 200 millones de registros, alojado en la plataforma Tinybird.

Este entorno presenta un desafío considerable, puesto que las consultas deben optimizar no solo la corrección sintáctica y lógica sino también la eficiencia a la hora de explorar y extraer información. La evaluación consideró 50 preguntas diferentes formuladas en lenguaje natural. Los modelos de LLM debían generar consultas SQL para responder estas preguntas, las cuales fueron comparadas con una línea base humana. Esto permitió medir distintos aspectos del desempeño de los modelos, incluyendo la exactitud del resultado generado, la eficiencia en el acceso a los datos y el tiempo necesario para generar cada consulta. Entre los parámetros clave analizados está la exactitud o “Exactness”, que mide qué tan correctamente el modelo traduce la pregunta natural a una consulta SQL funcional y certera.

Otro aspecto evaluado es la eficiencia, que cuantifica qué tan optimizadas son las consultas en términos de recursos consumidos, como la cantidad de datos leídos, el tiempo de latencia de la consulta y el número de filas procesadas. Los resultados obtenidos dan una perspectiva clara de cuáles modelos son líderes en esta tecnología y presentan un balance óptimo entre precisión y velocidad. Destacan los modelos de la empresa Anthropic, que encabezan el ranking con puntajes superiores en ambas dimensiones. Su modelo claude-opus-4 lidera con una alta calificación en eficiencia y exactitud, mostrando además un tiempo de generación de consultas bastante competitivo. Los modelos de OpenAI también se sitúan en posiciones destacadas, con GPT-4.

1 y variantes como gpt-4.5-preview, que demuestran un equilibrio interesante, priorizando una muy alta exactitud, aunque con un grado algo mayor de recursos consumidos en términos de filas y datos procesados en ciertas consultas. Modelos alternativos como los de Meta y Google ofrecen opciones competitivas, aunque con particularidades en su rendimiento. Por ejemplo, algunas versiones de llama-4 destacan por su precisión extrema, cercana a la humana, mientras que las variantes gemini de Google muestran buenos tiempos de respuesta, aunque requieren una optimización adicional para mejorar la eficiencia en la lectura de datos. La comparación con la base humana es especialmente reveladora.

Aunque la línea base humana mantiene un excelente rendimiento, los LLMs están alcanzando niveles aproximados de efectividad con beneficios sustanciales en automatización y escalabilidad. Este balance entre perfección humana y automatización representa un punto crítico para adopciones empresariales donde la velocidad y el costo de procesamiento también son factores decisivos. En cuanto al tiempo de generación, la mayoría de los modelos completan sus consultas en menos de medio segundo, lo que los hace aptos para aplicaciones en tiempo real o casi en tiempo real. Esta rapidez es un factor importante en contextos comerciales donde la respuesta inmediata a consultas puede potenciar la toma de decisiones ágiles. Otro dato interesante es el número promedio de intentos que cada modelo hace para construir una consulta adecuada.

Este indicador refleja la robustez del modelo en generar consultas correctas en un solo paso, lo cual impacta directamente en la experiencia de usuario final. Modelos con un promedio cercano a uno ofrecen una interacción más fluida, mientras que aquellos que requieren múltiples intentos pueden generar fricciones o retrasos. La cantidad de datos leídos y procesados también es un índice relevante de la eficiencia del modelo. Consultas más eficientes acceden solo a la información necesaria, evitando lecturas masivas que elevan el consumo de recursos y tiempos de respuesta. En este sentido, los modelos top del benchmark muestran una tendencia a optimizar sus consultas en base al contexto, generando soluciones SQL más limpias y focalizadas.

Este tipo de benchmarks es vital para el desarrollo y evolución futura de la generación automática de SQL. Permite a los investigadores y desarrolladores identificar puntos fuertes y debilidades puntuales de cada modelo, y orientarlos hacia mejoras que integren mejores estrategias de optimización y comprensión semántica. Además, ofrece a las empresas y usuarios finales un panorama completo para seleccionar la solución que mejor se adapte a sus necesidades específicas. La importancia de contar con herramientas efectivas de generación de SQL radica en la democratización del acceso a grandes volúmenes de datos. Tradicionalmente, extraer información valiosa requería expertos en bases de datos, lo que elevaba costos y tiempo.

Los modelos LLM eliminan esta barrera, posibilitando consultas complejas a partir de preguntas en lenguaje coloquial, facilitando insights y análisis más rápidos, accesibles para perfiles menos técnicos. Sin embargo, hay desafíos todavía por superar. La generación automática requiere no solo comprender correctamente la intención del usuario, sino también conocer la estructura y peculiaridades de cada base de datos. Los modelos deben adaptarse a diferentes esquemas, vocabularios técnicos y requisitos de negocio, lo que demanda entrenamientos especializados y ajustes constantes. Además, la eficiencia en el manejo de grandes volúmenes de datos es crítica para evitar costos elevados en infraestructuras y asegurar la rapidez del sistema.

Por ello, las métricas vinculadas a la cantidad de datos leídos y al tiempo de latencia no pueden ser ignoradas. Cada milisegundo cuenta, en especial en ambientes de e-commerce, análisis financiero o servicios en línea donde la velocidad es sinónimo de mejor experiencia y mayores ganancias. En resumen, el benchmark de generación de SQL con LLM representa una herramienta esencial para medir el estado del arte en esta tecnología emergente. Los resultados evidencian avances notables en la capacidad de los modelos para emular la precisión humana, combinando rapidez y eficiencia en contextos de datos reales y complejos. A medida que estos modelos continúen evolucionando, se espera que las empresas puedan aprovechar aún más los beneficios de la inteligencia artificial aplicada en bases de datos, reduciendo barreras técnicas y acelerando la toma de decisiones basadas en datos precisos y oportunos.

Mientras el mercado y los desarrolladores impulsan estas innovaciones, mantenerse informado sobre las comparativas de desempeño y las tendencias emergentes será clave para quienes buscan implementar soluciones robustas y escalables en la generación automática de consultas SQL. La generación de SQL a partir de lenguaje natural no es solo una mejora técnica, sino una transformación que democratiza el acceso a la información y amplía el potencial analítico en industrias de todo tipo. Con benchmarks detallados y datos sólidos, el futuro de la interacción con bases de datos se vislumbra cada vez más inteligente, eficiente y accesible.