En la era digital actual, donde la velocidad y la precisión de los datos marcan la diferencia entre el éxito y el fracaso empresarial, Kafka ha emergido como una plataforma esencial para la transmisión de datos en tiempo real. Kafka, con su arquitectura robusta y escalable, se ha consolidado como la columna vertebral de muchas infraestructuras de datos modernas. Sin embargo, pese a su popularidad y potencia, los costos asociados y la complejidad operativa han limitado su adopción y escalabilidad en algunas organizaciones. En este contexto, surge una nueva generación de soluciones que aprovechan el almacenamiento basado en objetos, como Bufstream, ofreciendo una versión más económica y funcionalmente enriquecida de Kafka. No obstante, más allá del ahorro en costos, el verdadero avance se encuentra en el desarrollo guiado por esquemas, que promete transformar radicalmente cómo las organizaciones diseñan, validan y consumen datos en sus canales de streaming.

Las soluciones económicas de Kafka basadas en almacenamiento de objetos, como Bufstream, están revolucionando la forma en que se gestionan y almacenan los mensajes en sistemas distribuidos. Utilizando almacenamiento compatible con S3 para guardar los temas de Kafka, estas plataformas permiten aprovechar replicaciones automáticas gratuitas entre zonas de disponibilidad, eliminando muchos de los costos habituales en la transferencia de datos inter-regionales. Esta ventaja económica resulta sumamente atractiva para empresas que manejan altos volúmenes de datos pero que deben optimizar su presupuesto tecnológico. Sin embargo, esta optimización conlleva un compromiso en términos de latencia, donde el tiempo de procesamiento y entrega puede alcanzar a veces entre 500 y 1000 milisegundos, una cifra que, no obstante, es aceptable para la mayoría de los casos de uso actuales. Además, estas innovaciones introducen un cambio arquitectónico importante: el sistema débilmente coordinado y sin líderes centralizados puede escribir en cualquier broker sin sufrir la penalización habitual de coordinación.

Esto simplifica la gestión y potencia la escalabilidad automática, eliminando gran parte de la intervención operativa tradicional, además de facilitar la autoajustabilidad ante fluctuaciones en la carga de trabajo. Desde la perspectiva de fiabilidad, la dependencia únicamente de tecnologías cloud ampliamente utilizadas y estables, como sistemas de almacenamiento en objeto y almacenamientos externos de metadata conocidos (Postgres, Etcd, Google Cloud Spanner) ofrece una base sólida en entornos productivos. No obstante, la verdadera diferenciación no solo radica en las eficiencias de costos y la infraestructura, sino en la incorporación profunda del desarrollo guiado por esquemas. El enfoque tradicional en sistemas Kafka ha relegado la validación y gestión de esquemas a los consumidores o productores, dejándolos como un añadido opcional y fragmentado. Esto genera incertidumbre en la calidad y estructura real de los datos que fluyen a través del pipeline, provocando problemas frecuentes de integridad, inconsistencia y errores que se manifiestan días después en aplicaciones de negocio o paneles de inteligencia comercial.

Bufstream propone un cambio radical con la introducción de la conciencia del esquema directamente en el broker. Este broker, al tener conocimiento explícito de la forma y restricciones de los datos, puede ejercer validaciones semánticas avanzadas que bloquean la entrada de datos inválidos antes que comprometan a los consumidores. Este tipo de validación en el producto asegura que los registros producidos cumplan con las reglas definidas, y en caso contrario, los rechaza o redirige a colas de mensajes inválidos o rechazados. Esta solución evita escenarios típicos de corrupción sutil de datos, eliminando el tiempo perdido en la investigación y resolución de problemas, y también protege la credibilidad del ecosistema de Kafka dentro de la empresa. En línea con esta evolución, surge la necesidad de una gobernanza de esquemas estricta que impida la proliferación de cambios incompatibles o erróneos en los esquemas usados.

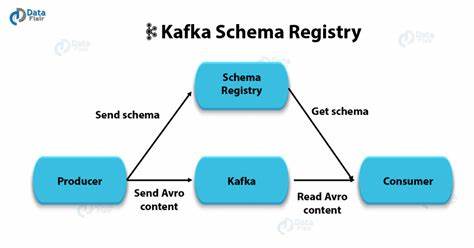

Los enfoques tradicionales, en los que los esquemas se registran dinámicamente en registries como Confluent Schema Registry, no garantizan que esos esquemas hayan sido revisados ni sean compatibles en el sentido más profundo, incluyendo sus propiedades semánticas. Esto abre la puerta a rupturas accidentales y a inconsistencias en la base de datos y aplicaciones consumidoras. Buf introduce un modelo de registro de esquemas mucho más riguroso: los cambios en los esquemas solo pueden ser introducidos mediante un proceso explícito de push en la fase de build, directamente integrado a los flujos de control de versiones y revisión de código. Esta validación incluye no solo las compatibilidades estructurales, sino también las propiedades semánticas a través de herramientas como Protovalidate, que usa CEL para validar reglas complejas sobre los datos. De esta manera, se garantiza que ningún cambio rompedor sea desplegado sin la aprobación necesaria y que todas las partes involucradas tengan una visión coherente y confiable del contrato de datos.

Este enfoque integral, que va desde la definición de esquemas hasta su validación y gobernanza, está basado en Protobuf como lenguaje universal de descripción de datos. Protobuf es la tecnología más madura y ampliamente soportada para la representación eficiente y extensible de datos estructurados, con bibliotecas en casi todos los lenguajes y un mapeo bien definido hacia JSON para facilitar la interoperabilidad humana y migratoria. Frente a alternativas como Avro, JSON Schema o SQL, Protobuf ofrece la combinación ideal de rendimiento, compatibilidad y facilidad de uso transversal. Buf ha dedicado años al desarrollo de un ecosistema completo para facilitar la adopción masiva de Protobuf en toda la pila tecnológica. Herramientas como Buf CLI permiten un desarrollo local sencillo e integrado, gestionando compilación, generación de stubs, detección de breaking changes, estilo y documentación.

Su Schema Registry centralizado funciona como un paquete manager que controla la distribución, versionamiento y políticas de esquemas, facilitando la adopción empresarial a gran escala. Además, cuentan con frameworks como ConnectRPC que brindan RPCs compatibles con gRPC y adaptados a varios escenarios con soporte HTTP/1.1 y JSON donde se necesitan. La combinación de estas herramientas facilita la transición hacia un desarrollo guiado por esquemas en streaming de datos, donde la calidad, la consistencia y la gobernanza son prioridades centrales y no tareas colaterales o delegadas a los clientes. Esto significa que los datos en tránsito ya no son cajas negras descontroladas, sino entidades firmemente gobernadas y validadas.

Con lo anterior, es posible lograr integraciones más seguras, transformar datos en tiempo real con garantías de tipo y evitar la propagación de errores en toda la pipeline desde el origen al destino final. Queda claro entonces que aunque lo económico en las infraestructuras Kafka es importante, la verdadera innovación y valor agregado reside en dejar atrás las prácticas desordenadas y adoptar la conciencia y el control total de los esquemas en cada punto del proceso de datos. Esta unión de eficiencia y gobernanza abre paso a un mundo en donde los ingenieros podrán diseñar y evolucionar rápidamente sistemas de streaming robustos, coherentes, y con visibilidad total sin sacrificar costos ni la integridad de los datos. El futuro de la gestión de datos en tiempo real pasa por integrar herramientas y metodologías que eleven la calidad, la seguridad y la confianza. La adopción de plataformas como Bufstream y la implementación de un desarrollo estrictamente guiado por esquemas con Protobuf marcan el camino hacia arquitecturas de datos más responsable, escalables y eficientes.

Organizaciones de todos los sectores pueden beneficiarse de este cambio, transformando su cultura de datos, reduciendo costos operativos y ganando agilidad en sus procesos de entrega. En resumen, Kafka económico es una solución atractiva para optimizar gastos, pero la evolución hacia un desarrollo guiado por esquemas representa una revolución más profunda que no solo ahorra costos sino que genera mayor calidad, confianza y control en la gestión de datos en streaming. Adoptar un lenguaje de esquemas universal, herramientas fiables para validación y gobernanza, y una plataforma que entienda y aplique estas reglas directamente en el broker redefine el paradigma del streaming y sienta las bases para la siguiente generación de arquitecturas de datos empresariales.