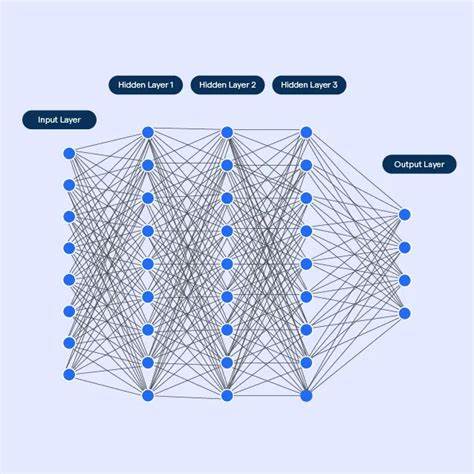

La complejidad en los modelos de redes neuronales profundas es un tema cada vez más relevante en la inteligencia artificial y el aprendizaje automático. A medida que los modelos crecen en tamaño y capacidad, entender qué hace que un modelo sea complejo, cómo medir esa complejidad y cómo esta influye en su desempeño y generalización es fundamental tanto para investigadores como para ingenieros de software. La búsqueda de una teoría sólida que combine conceptos de complejidad, entropía y representación de datos ha dado lugar a debates y estudios que intentan formalizar estos conceptos, aplicándolos directamente a redes profundas. Las redes neuronales profundas, utilizadas en aplicaciones como procesamiento de lenguaje natural, reconocimiento de imágenes y juegos, se enfrentan a un reto fundamental: cómo representar correctamente la información contenida en los datos de entrenamiento sin caer en el sobreajuste, manteniendo la capacidad de generalizar a datos no vistos. En este sentido, la complejidad del modelo no solo hace referencia a la cantidad de parámetros o capas, sino también a la calidad y estructura de la información que el modelo es capaz de capturar y almacenar.

Una aproximación para entender la complejidad está anclada en la teoría de la información, específicamente a través de conceptos como la entropía. Tradicionalmente, la entropía es una medida del desorden o la incertidumbre en un sistema, cuantificando la cantidad de información necesaria para describir un estado aleatorio. Sin embargo, el solo uso de la entropía como medida de complejidad resulta insuficiente, ya que no distingue entre información estructurada y ruido aleatorio dentro de un dato o sistema. Por eso, investigadores han propuesto diferentes formas de evaluar lo que se podría denominar “complejidad aparente” o “interesante” en datos y configuraciones. Esta medición busca capturar los patrones significativos —aquellos que reflejan estructura o significado— y separar la información incidental o ruido que no aporta a la comprensión profunda del fenómeno.

Para ello, se establece generalmente alguna transformación o función de suavizado que filtre el ruido y resalte la estructura. En redes neuronales, este filtro puede conceptualizarse como un proceso equivalente a la compresión o extracción de características, que llevan a cabo los pesos y configuraciones internas del modelo. No obstante, definir o encontrar esa función de suavizado no es trivial pues puede depender del dominio, del formato de los datos y del propio observador. Es aquí donde el concepto de sofisticación, derivado de la complejidad de Kolmogórov, ha ganado atención como una posible herramienta teórica para discriminar entre estructura y ruido. La complejidad de Kolmogórov define la complejidad de un objeto como la longitud del programa más corto que puede generar ese objeto en una máquina computacional universal.

Dicha definición formaliza la idea de información comprimida de manera óptima, aunque la complejidad de Kolmogórov no es computable en términos prácticos. A pesar de ello, este marco teórico sostiene que para cada objeto (o dato) existe un conjunto estructurado que contiene toda su información relevante y un índice o representación con respecto a dicho conjunto. Esto sugiere que la representación óptima de un dato se descompone en una parte estructurada —generalizable y significativa— y una parte aleatoria o residual. Adaptando estas ideas al mundo de las redes neuronales, se puede pensar que el proceso de entrenamiento busca precisamente descubrir ese conjunto estructurado subyacente a los datos de entrenamiento, que definiremos como S, mientras que los datos individuales x pueden ser entendidos como elementos particulares dentro de ese conjunto. La red trata de aprender un modelo con una descripción compacta de S, que captura toda la información importante y generalizable, evitando así adaptar sus parámetros al ruido o datos específicos que no contribuyen a la correcta generalización.

Este entendimiento conecta profundamente con la teoría de la longitud mínima de descripción (Minimum Description Length, MDL), la cual propone que el mejor modelo para los datos es aquel que minimiza la suma de la longitud de la descripción del modelo y la longitud de la descripción de los errores o discrepancias con respecto a los datos reales. En términos simples, se trata de balancear el tamaño o complejidad del modelo contra la precisión del ajuste de datos. En el contexto de la inteligencia artificial y las redes neuronales profundas, este principio ayuda a explicar por qué agregar complejidad al modelo (más parámetros, capas, etc.) sin un control adecuado, usualmente representado por regularización u otros mecanismos, conduce a un mal comportamiento —sobreespecialización o sobreajuste— y disminuye la capacidad de generalización. Los modelos modernos, como las grandes arquitecturas tipo transformers, requieren una enorme cantidad de datos para capacitarse efectivamente y evitar este sobreajuste.

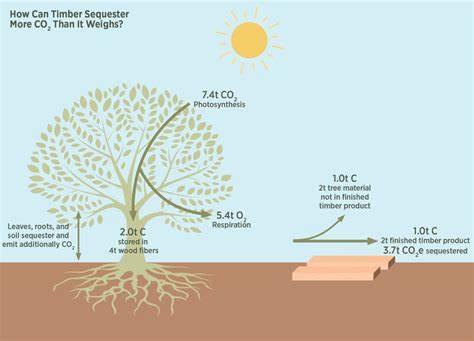

Sin embargo, no es suficiente tener solamente datos, sino que también es clave la calidad de la representación que el modelo aprende en sus capas internas para separar el ruido de la estructura. Además, se han realizado experimentos con modelos teóricos y simulaciones que ilustran cómo la complejidad de un sistema puede variar a lo largo del tiempo y cómo un estado de máxima complejidad tiende a surgir en posiciones intermedias de un proceso de evolución, lo cual se ha llamado un “arco de complejidad”. Por ejemplo, estudios sobre autómatas celulares inspirados en la mezcla de cremas con café muestran que al inicio y al final del proceso la complejidad es baja, mientras que en puntos intermedios se resalta un alto grado de estructura y organización. Este fenómeno refleja la idea de que la complejidad no es un simple aumento constante con el tiempo o con la cantidad de datos, sino que aparece y desaparece dependiendo de la interacción entre orden y desorden, estructura y entropía. Esto es relevante para redes neuronales, donde la representación interna se modifica durante el entrenamiento, y podemos interpretar que el modelo atraviesa fases donde la complejidad de sus patrones internos aumenta para representar relaciones entre datos, para luego eventualmente estabilizarse o disminuir cuando alcanza un buen equilibrio entre precisión y generalización.

Un punto crucial de discusión reside en cómo las redes neuronales implementan de manera implícita funciones de suavizado que permiten separar la información relevante del ruido. Conceptualizando los pesos y las activaciones como una compresión adaptativa del conjunto estructurado de datos, la red funciona como un algoritmo de compresión que identifica patrones significativos en los datos y los codifica en sus parámetros. Modelos específicos, como los Autoencoders Variacionales (VAEs), hacen explícito este proceso ofreciendo un espacio latente comprimido que representa la información estructurada y permite reconstrucciones del dato original. Esto ejemplifica directamente la idea de una función de suavizado ideal que filtra el ruido aleatorio, dejando solo los componentes esenciales para la reconstrucción. De manera similar, los modelos de difusión pueden interpretarse como mecanismos que aprenden a quitar progresivamente ruido de los datos, reforzando la noción de aprendizaje de estructura desde datos ruidosos.

A pesar de los avances, es importante reconocer que todavía no existe una medida universalmente aceptada o práctica de complejidad aplicada a los modelos de aprendizaje profundo. Las dificultades para computar ciertas métricas como la sofisticación o la complejidad de Kolmogórov, junto con la dependencia en funciones de suavizado no siempre bien definidas, representan desafíos teóricos y prácticos. Sin embargo, estas teorías aportan un marco conceptual valioso para entender el proceso de entrenamiento y la capacidad de generalización de las redes neuronales desde un punto de vista de la teoría de la información, la compresión y la estadística. Además, entender la complejidad del modelo en relación con la complejidad del conjunto de datos que debe aprender tiene implicaciones directas en cómo se diseñan, entrenan y evalúan los modelos de inteligencia artificial. Nos invita a reflexionar sobre la naturaleza de los datos, la necesidad de grandes volúmenes y diversidad, la forma de regularización y el equilibrio finito entre tamaño del modelo y capacidad de generalización.