En el fascinante y veloz mundo de la inteligencia artificial y los modelos de lenguaje, ha surgido una tendencia particular dentro de la comunidad tecnológica: la búsqueda obsesiva de los llamados "prompts mágicos". Estos son frases o comandos presentados como la fórmula perfecta para obtener resultados extraordinarios o casi humanos de asistentes de inteligencia artificial como ChatGPT, Claude o Gemini. Se promueven con titulares llamativos que aseguran que un prompt puede convertirte en un consultor con resultados millonarios o elevar tu desempeño a niveles superhumanos. Sin embargo, esta obsesión con encontrar la frase exacta o el prompt ideal puede ser un enfoque erróneo y limitado que no refleja el verdadero potencial de estas tecnologías. Más allá del atractivo de las soluciones rápidas, es fundamental comprender que dominar el uso de modelos de lenguaje no es cuestión de seguir una receta mágica, sino de adquirir un entendimiento profundo sobre qué pueden y qué no pueden hacer estas herramientas.

Aprender a identificar cuándo es apropiado continuar una interacción con un modelo, cuándo es mejor iniciar una nueva conversación, y cómo aprovechar efectivamente las capacidades de razonamiento de los modelos es la clave para utilizar verdaderamente estas tecnologías a favor de nuestros objetivos. Un ejemplo claro se encuentra en el ámbito del desarrollo de software, donde uno de los usuarios más críticos y exigentes con la inteligencia artificial nos proporciona una perspectiva fresca y práctica. En su día a día como ingeniero de software, utiliza funcionalidades como las del Copilot para recibir sugerencias inteligentes mientras escribe código. Esto no se basa en apuntar comandos específicos o frases ofertadas como "mágicas", sino en integrar el modelo en el flujo de trabajo como una extensión natural de sus habilidades. También recurre a los modelos para comprender enfoques idiomáticos en lenguajes o frameworks poco conocidos, realizar análisis rápidos de bugs y hasta para revisar cambios en su código antes de integrarlos en proyectos.

Estos usos no requieren búsquedas exhaustivas de prompts perfectos, sino planteamientos naturales y contextuales: proporcionar toda la información relevante y esperar respuestas precisas y bien fundamentadas. El foco está en la calidad del contexto presentado al modelo más que en la perfección del prompt en sí. Lo que resulta pragmático no es tener una biblioteca de prompts prefabricados, sino saber ajustar las preguntas al problema concreto, con flexibilidad y buen juicio. Es precisamente la adaptación y experiencia práctica lo que hace la diferencia. Por ejemplo, al enfrentar un problema complejo, es posible que la inteligencia artificial pueda ofrecer soluciones inmediatas si recibe el contexto adecuado.

Pero en situaciones que demandan mayor profundidad o precisión, el usuario inteligente sabe cuándo detener la interacción, replantear el problema o emplear modelos de razonamiento especializados. Además, al trabajar con código o entornos de producción, es crucial revisar y replicar manualmente cualquier código generado antes de considerarlo fiable, dado que los modelos pueden cometer errores o generar soluciones incompletas. Otro área interesante a destacar es el uso de estas tecnologías para tareas puntuales o scripts que no requieren supervisión extensiva. En estos casos, la rapidez para generar código desechable de una sola ejecución ahorra tiempo y recursos, demostrando que el poder de los modelos radica tanto en su versatilidad como en la gestión cuidadosa del riesgo asociado a confiar en su salida sin validación. Es también importante mencionar un punto de vista personal acerca de la generación de comunicaciones internas, como correos electrónicos o mensajes en redes corporativas.

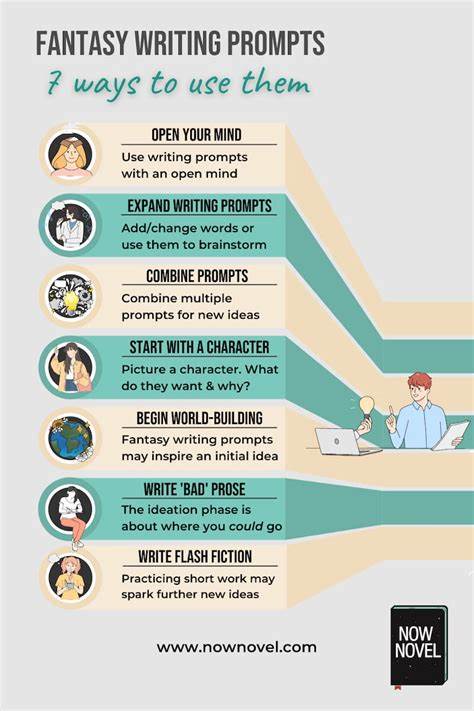

Mientras estas prácticas son comunes y funcionales en muchos contextos, algunos profesionales prefieren mantener una comunicación auténtica y personalizada, evitando el estilo característico o artificial que puede producir un modelo de lenguaje. Esto subraya la importancia de calibrar el uso de la inteligencia artificial según las preferencias y ética de cada usuario o equipo. Lo que muchos usuarios y entusiastas quizás no han internalizado es que el verdadero valor de estas herramientas no está en la magia de repetir una fórmula, sino en descubrir a través del ensayo, el error y la observación continua qué tareas son adecuadas para la inteligencia artificial y cuáles no. Los llamados "prompts mágicos" también tienen cierto mérito al abrir la mente de los usuarios hacia todo el espectro de posibilidades de estas tecnologías. Pueden funcionar como una puerta de entrada para que usuarios menos experimentados empiecen a explorar aplicaciones que antes no consideraban, desde estrategias de marketing hasta consultas médicas informales.

Sin embargo, la realidad es que incluso en los laboratorios de las grandes compañías de inteligencia artificial, nadie conoce con total certeza los alcances definitivos de estos modelos. Cada día se descubren nuevas capacidades que antes no estaban documentadas ni previstas. Por ejemplo, se ha visto que modelos recientes pueden geolocalizar imágenes con precisión superior a la de expertos humanos, algo que vino como sorpresa para todos. Esta exploración constante de lo que los modelos pueden hacer, una suerte de minería en el espacio latente de posibilidades, requiere una mentalidad abierta y curiosa, en vez de la búsqueda estricta de atajos o respuestas prefabricadas. En definitiva, si el objetivo es mejorar la interacción con modelos de lenguaje por motivos profesionales o personales, la recomendación más efectiva es cultivar una comprensión sólida de sus fortalezas y debilidades.

Practicar con problemas variados, aprender a facilitar el contexto adecuado y discernir cuándo vale la pena profundizar o cambiar de enfoque son habilidades que superan con creces la utilidad de cualquier "biblioteca de prompts". Así, el verdadero camino hacia la excelencia con inteligencia artificial no pasa por el hechizo de frases perfectas, sino por una colaboración consciente entre humanos y máquinas, en la que el usuario actúa como el verdadero motor que guía la tecnología hacia soluciones útiles, relevantes y confiables. La magia, en este sentido, está en la experiencia y en la sabiduría para entender cuándo y cómo usar estas herramientas al máximo de su potencial.