En la era digital actual, la comunicación instantánea se ha convertido en un pilar fundamental para las relaciones personales, laborales y de entretenimiento. En este contexto, el chat de voz en tiempo real ha emergido como una herramienta revolucionaria que permite conversaciones naturales y fluidas a través de internet. Sin embargo, lograr una comunicación sin interrupciones, con calidad y baja latencia, presenta importantes desafíos tecnológicos. Especialmente cuando se busca una latencia cercana a los 500 milisegundos, meta que representa un equilibrio entre rapidez y estabilidad para ofrecer una experiencia óptima al usuario. La latencia en un sistema de comunicación en tiempo real se refiere al retraso que existe desde el momento en que una persona habla hasta que la otra recibe el mensaje.

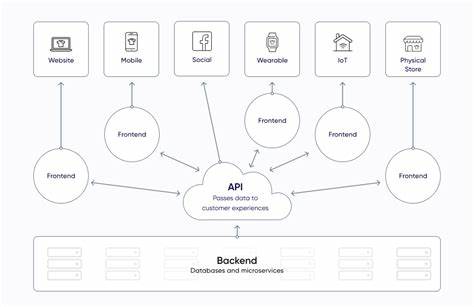

Una latencia elevada provoca interrupciones, voces solapadas y una interacción poco natural que afecta la experiencia general. En este sentido, conseguir una latencia cercana a los 500ms es crucial porque se aproxima a la percepción humana de una conversación cara a cara, haciendo que las interacciones en línea se sientan más auténticas y menos forzadas. Las tecnologías que soportan este tipo de chat están evolucionando rápidamente. Se combinan varios elementos como la captura y transmisión de audio, el procesamiento mediante modelos de inteligencia artificial para transcripción y generación de respuestas, así como la síntesis de voz para regresar la respuesta hablada. Por ejemplo, en sistemas avanzados, el audio se captura directamente a través del navegador web y se envía en pequeños fragmentos por medio de conexiones WebSocket a un backend basado en Python.

Este backend utiliza modelos de reconocimiento de voz en tiempo real que convierten el audio en texto casi instantáneamente. Una vez que el mensaje está en formato texto, se utiliza un modelo de lenguaje grande (como los ofrecidos por Ollama o OpenAI) para procesar y generar la respuesta adecuada en lenguaje natural. Este proceso de “pensamiento” por parte de la inteligencia artificial normalmente es la etapa más intensiva en términos computacionales. Sin embargo, mediante la optimización del flujo y la arquitectura backend, es posible minimizar el tiempo dedicado y mantener la comunicación fluida y con poco retraso. La respuesta generada en texto debe transformarse nuevamente a formato de audio para que el usuario pueda escucharla.

Esto se logra con sistemas de texto a voz (Text-to-Speech o TTS) que convierten las respuestas de la IA en voz sintética. Algunos motores populares incluyen Coqui, Kokoro y Orpheus, ofreciendo voces personalizables y naturales. La arquitectura debe manejar la transmisión del audio sintetizado de forma escalonada, enviando trozos a medida que se generan, para evitar esperas largas. Uno de los grandes avances en estos sistemas es la implementación de detección inteligente de pausas o silencios en la conversación mediante algoritmos que adaptan automáticamente el ritmo del intercambio. Esto permite que el sistema identifique cuándo el usuario ha terminado de hablar o cuando es apropiado intervenir para no solapar voces, mejorando el turn-taking natural de las conversaciones.

El stack tecnológico para este tipo de chat de voz en tiempo real es multifacético. Se suele utilizar Python con frameworks como FastAPI por su eficiencia en la gestión de conexiones WebSocket, combinado con frontend implementado con JavaScript puro que aprovecha las capacidades del Web Audio API para manipular el sonido directamente en el navegador. Además, el uso de contenedores Docker garantiza portabilidad y facilidad de despliegue, especialmente si se requiere utilizar GPU para acelerar el procesamiento de modelos neurales. Un aspecto clave para el funcionamiento fluido de estos sistemas es el hardware. La recomendación es contar con GPUs NVIDIA compatibles con CUDA, pues aceleran significativamente las fases de reconocimiento y síntesis de voz.

En escenarios donde el hardware sea limitado o se opere solo con CPU, la experiencia puede ser más lenta, aumentando la latencia y afectando la percepción del usuario. Asimismo, el soporte multiplataforma es esencial para que los usuarios accedan sin inconvenientes desde distintas máquinas. La solución recomendada generalmente incluye un despliegue basado en Docker Compose, que facilita la instalación rápida y la gestión de dependencias en sistemas Linux, con soporte adicional para Windows y macOS mediante configuraciones manuales o scripts. El arte de mantener la latencia alrededor de 500ms está en la optimización integral del flujo de datos, desde la captura inicial hasta la reproducción final del audio. Se implementan técnicas como el streaming progresivo de datos, buffers ajustados para evitar tanto lag como cortes y manejo inteligente de interrupciones.

Por ejemplo, si el usuario interrumpe al AI mientras habla, el sistema detecta la interrupción y adapta el comportamiento sin perder información ni ralentizar la experiencia. Más allá de la tecnología pura, este tipo de chat tiene enormes aplicaciones prácticas. En la educación virtual, facilita un aprendizaje más interactivo y dinámico. En el ambiente laboral, mejora la colaboración remota al acercar la experiencia a una reunión presencial. También se puede aplicar en juegos en línea, asistencia virtual y atención al cliente, donde la voz humana genera una conexión emocional más fuerte que la comunicación solo por texto.

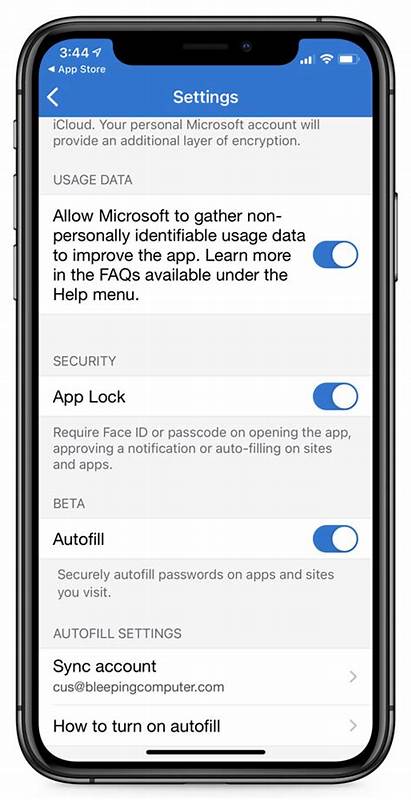

Este avance tecnológico también abre el camino a interfaces más accesibles, permitiendo a personas con dificultades para teclear o leer mantener conversaciones fluidas con máquinas inteligentes. Adicionalmente, la combinación de reconocimiento de voz y generación automática de respuestas hace posible la creación de asistentes conversacionales que entienden y responden en lenguaje natural sin la fricción típica de los chatbots clásicos. Naturalmente, existen desafíos que deben contemplarse. La privacidad y la seguridad en la transmisión y almacenamiento de datos de voz son temas prioritarios. Se recomienda el uso de conexiones cifradas mediante SSL/TLS y políticas claras sobre el manejo de información sensible.

Por otro lado, garantizar que el sistema pueda manejar múltiples usuarios simultáneamente sin sacrificar la latencia es fundamental para su escalabilidad. Los proyectos open source en este ámbito han sido cruciales para acelerar la innovación. Al compartir código y experiencias, la comunidad puede optimizar aún más los algoritmos y adaptar las soluciones a diversos idiomas y situaciones específicas. La modularidad en el diseño permite actualizar componentes independientes como el motor de texto a voz o el modelo de lenguaje según nuevas tecnologías aparezcan. En conclusión, el chat de voz en tiempo real con latencia cercana a 500 milisegundos representa una frontera tecnológica donde convergen inteligencia artificial, hardware potente y software bien optimizado para transformar la forma en la que nos comunicamos digitalmente.

La sensación de conversaciones naturales, la fluidez de los intercambios y la inmediatez que ofrece esta innovación abren todo un abanico de posibilidades para mejorar la vida cotidiana, el trabajo y el entretenimiento en línea. Con expectativas de que estas tecnologías sigan evolucionando y democratizándose, estamos por presenciar un futuro donde las barreras comunicativas virtuales se minimicen, logrando interacciones más humanas, rápidas y enriquecedoras que nunca.