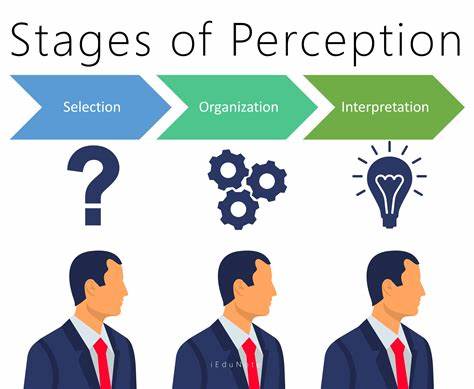

En la era actual de la inteligencia artificial, uno de los avances más fascinantes es la capacidad de las máquinas para interpretar y razonar sobre el mundo que las rodea. La percepción visual y el razonamiento han sido tradicionalmente abordados por modelos especializados: los modelos de percepción se centran en entender imágenes y videos, mientras que los modelos de razonamiento, especialmente los basados en lenguaje, se encargan de procesar y generar respuestas complejas. Sin embargo, la unificación de estas dos habilidades ha sido un desafío importante en la comunidad científica. Recientemente, surge una metodología innovadora llamada fusión de modelos (model merging), que promete combinar de manera efectiva modelos de distintas modalidades para potenciar tanto la percepción como el razonamiento en sistemas de inteligencia artificial. La percepción en inteligencia artificial se refiere a la habilidad de interpretar y procesar información visual, como reconocer objetos, escenas o eventos en imágenes o videos.

Los modelos que se especializan en esta tarea, como las Redes Neuronales Convolucionales (CNNs) o los modelos de visión-transformer, extraen características visuales a partir de datos de entrada para ofrecer interpretaciones precisas y detalladas. Por otro lado, el razonamiento, especialmente en los Procesadores de Lenguaje Natural (NLP, por sus siglas en inglés) como los Grandes Modelos de Lenguaje (LLMs), permite a las máquinas inferir, deducir y generar conocimiento basado en pistas contextuales o datos previos. La integración de la percepción con el razonamiento abre un campo vasto de posibilidades para aplicaciones prácticas. Estos sistemas multimodales, comúnmente conocidos como modelos de visión y lenguaje (VLMs), pueden generar descripciones detalladas de imágenes, responder preguntas visuales complejas o incluso realizar acciones basadas en la interpretación de datos audiovisuales. Sin embargo, combinar eficazmente estos modelos no es trivial.

Tradicionalmente, la fusión se ha realizado a través de técnicas de entrenamiento conjunto o la incorporación de módulos especializados que coordinen ambas capacidades. A pesar de ello, estas técnicas pueden ser costosas, requerir grandes cantidades de datos y enfrentar retos de compatibilidad entre arquitecturas. El enfoque reciente de fusionar modelos, ciertamente innovador, plantea una solución elegante para estos retos. En lugar de entrenar un modelo completamente nuevo que integre percepción y razonamiento, la fusión de modelos permite conectar directamente los parámetros de dos modelos ya entrenados, uno enfocado en percepción y otro en razonamiento. Este método no solo es eficiente al evitar reentrenamientos extensos, sino que también facilita la transferencia de capacidades específicas entre modelos a través de la manipulación de sus pesos internos.

Estudios recientes demuestran que las capas tempranas en los modelos fusionados mantienen esencialmente las habilidades de percepción, codificando las características visuales básicas y complejas. Por el contrario, las capas intermedias y finales se vuelven responsables del razonamiento, procesando información para generar inferencias y tomar decisiones contextuales. Tras la fusión, una transformación significativa ocurre: el razonamiento comienza a manifestarse a lo largo de todas las capas del modelo, mientras que la percepción se preserva en las etapas iniciales sin alteraciones sustanciales. Esta distribución diversa en la contribución de capas sugiere un mecanismo intrínseco mediante el cual la fusión enriquece la arquitectura, potenciando una colaboración interdisciplinaria entre percepción y razonamiento. La capacidad para unir modelos de distintas modalidades mediante la fusión ofrece un nuevo paradigma para entender la interpretación multimodal.

No solo se trata de combinar funcionalidades, sino que también es posible trazar cómo se distribuyen internamente estas capacidades, proporcionando una visión clara del proceso de integración. De esta manera, el análisis de modelos fusionados puede aclarar los patrones de codificación interna que sustentan la percepción visual y el razonamiento lógico. Esto no solo contribuye a avances técnicos en la IA, sino que también mejora la interpretabilidad y la transparencia de los sistemas inteligentes. Las aplicaciones de esta técnica son vastas y prometedoras. En el campo de la medicina, por ejemplo, sistemas capaces de analizar imágenes médicas y razonar sobre síntomas y diagnósticos pueden proveer apoyo decisivo a profesionales.

En robótica, un robot con percepción avanzada y razonamiento integrado puede interactuar de forma más intuitiva con su entorno, identificando objetos y tomando decisiones en tiempo real. En el sector educativo, estos sistemas pueden facilitar experiencias de aprendizaje interactivas, entendiendo tanto el contexto visual como el lenguaje para ofrecer respuestas y guías personalizadas. Además, la fusión de modelos representa un avance significativo en la eficiencia del desarrollo y despliegue de inteligencia artificial. Esto se traduce en una reducción de costos computacionales y temporales, ya que no requiere entrenar modelos desde cero, aprovecha el conocimiento preexistente y adapta capacidades mediante la manipulación directa de parámetros. A su vez, esta técnica puede mitigar la necesidad de grandes bases de datos multimodales para entrenar, pues los modelos individuales ya han sido entrenados extensamente en sus dominios respectivos.

El futuro de la inteligencia artificial multimodal parece prometedor gracias a este enfoque. La exploración continua de la fusión de modelos puede conducir a la emergente generación de sistemas híbridos, que aprendan y evolucionen de manera flexible, integrando información visual, textual y posiblemente otras modalidades sensoriales. Así, se acelerará el desarrollo de máquinas que comprendan el mundo de manera más humana, capturando no solo datos, sino contextos complejos y significados abstractos. Sin embargo, a pesar de su potencial, es fundamental continuar investigando las limitaciones y desafíos de esta metodología. La compatibilidad arquitectónica entre modelos, la preservación de habilidades específicas y la evaluación rigurosa de la eficacia son aspectos clave para garantizar que la fusión se traduzca en mejoras reales y consistentes.