En los últimos años, la inteligencia artificial ha alcanzado niveles impresionantes, especialmente en el campo de la generación de código a través de modelos de lenguaje grandes (LLM, por sus siglas en inglés). Estas herramientas, capaces de generar miles de líneas de código en cuestión de segundos, están transformando la forma en que se desarrolla software. Sin embargo, esta revolución también presenta retos significativos en el ámbito de las pruebas de software, una disciplina fundamental para garantizar la calidad y la fiabilidad de los programas. Tradicionalmente, las estrategias de prueba han estado estrechamente ligadas al proceso clásico de desarrollo humano. Los programadores implementan cambios incrementales, realizan ajustes localizados y corrigen errores que suelen estar vinculados a modificaciones recientes.

En este contexto, las pruebas unitarias, de integración y de sistema han sido diseñadas para validar comportamientos específicos y para detectar desviaciones vinculadas a cambios específicos, permitiendo una identificación ágil y precisa de fallos. Sin embargo, la introducción de modelos de lenguaje grandes para la generación automática de código desafía estos paradigmas. Estos modelos no generan el código de manera incremental ni parecen seguir un patrón de desarrollo tradicional. En lugar de ello, producen código secuencialmente, token por token, condicionando cada fragmento en función del anterior y del contexto inicial proporcionado por el prompt. Esto implica que la especificación real del código no es únicamente aquella expresada al inicio, sino un resultado dinámico y acumulativo que evoluciona a medida que el modelo avanza en la generación.

Este fenómeno genera desafíos importantes para las pruebas de software. Por ejemplo, un desarrollador humano podría escribir una función para ordenar una lista y calcular la mediana dividiendo el problema en pasos claros y separados que son fácilmente comprobables de forma individual. En cambio, un LLM podría generar un bloque único donde la lógica de ordenamiento afecta directamente el cálculo de la mediana de formas sutiles e interdependientes, complicando la identificación y aislamiento de errores mediante pruebas unitarias tradicionales. Además, la escala y complejidad del código generado por estos modelos es significativamente superior a la de los desarrollos humanos convencionales. Es común que los LLM produzcan grandes cantidades de código monolítico en una sola ejecución, transformando la estructura habitual de pequeños módulos o componentes interconectados en una masa gigantesca de líneas y dependencias.

Esta situación dificulta notablemente la aplicación de métricas tradicionales, como la cobertura de código, y la inspección manual pierde eficacia ante semejante volumen e interdependencia. Los patrones de errores también evolucionan en esta nueva era. Ya no se trata únicamente de errores sintácticos o fallos lógicos evidentes que pueden ser rastreados aisladamente. Los problemas emergen como inconsistencias semánticas sutiles vinculadas a la evolución interna del estado del modelo mientras genera código, resultando en comportamientos inesperados en escenarios específicos. Esto demanda técnicas de prueba capaces de enfocarse en el comportamiento global del sistema y en sus propiedades emergentes más que en componentes aislados.

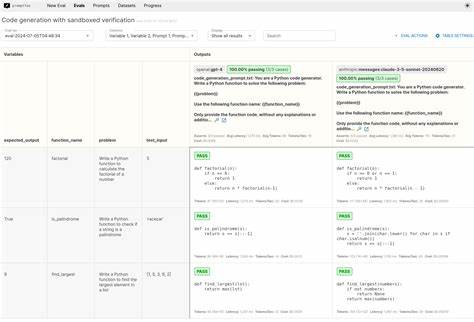

De cara al futuro, es fundamental repensar cómo se diseñan y aplican las estrategias de prueba. Las herramientas actuales, orientadas a detectar desviaciones en cambios limitados y localizados de código escrito por humanos, podrían quedarse cortas frente al desafío que representa validar y verificar código generado automáticamente a gran escala. Es necesario explorar y desarrollar métodos que permitan analizar el código desde una perspectiva más holística, que consideren dependencias complejas, flujos de estado no triviales y propiedades emergentes que solo pueden ser observadas en el conjunto completo del código. La integración de inteligencia artificial en las herramientas de prueba puede ser una vía prometedora. Por ejemplo, utilizar análisis basados en aprendizaje automático para detectar patrones anómalos o inconsistencias semánticas en el código generado, o implementar sistemas que puedan simular y razonar sobre el comportamiento global tomando en cuenta la naturaleza secuencial y contextual del proceso de generación del código.

Estas innovaciones podrían complementar y superar las limitaciones de los métodos tradicionales. Asimismo, la colaboración entre humanos y máquinas se vuelve más crucial que nunca. Los desarrolladores deben aprender a interpretar y complementar el trabajo generado por LLM, no solo confiando ciegamente en su salida, sino utilizando diversas pruebas automatizadas y análisis estáticos y dinámicos para validar cada aspecto del código de manera robusta. La formación en nuevas metodologías y en el uso efectivo de estas herramientas será clave para mantener altos estándares de calidad y seguridad. La llegada de los modelos de lenguaje grandes en la programación presenta desafíos sin precedentes, pero también grandes oportunidades para redefinir y mejorar la forma en que se garantiza la calidad del software.

Adoptar nuevas perspectivas y tecnologías en las pruebas permitirá no solo adaptarse a esta nueva realidad, sino también aprovechar el potencial de generación automática para acelerar el desarrollo sin sacrificar confiabilidad y robustez. El futuro del testing está en la innovación y en la fusión entre inteligencia humana y artificial para afrontar códigos cada vez más complejos y dinámicos.