En la era de la inteligencia artificial, los modelos de lenguaje a gran escala (LLM) están transformando sectores diversos como la salud, la ley, la ciencia y los medios de comunicación. Su capacidad para generar texto de forma autónoma ha revolucionado la manera en que interactuamos con la información y automatizamos procesos complejos. Sin embargo, uno de los mayores desafíos que enfrentan estos modelos es la generación de información no respaldada o incorrecta, fenómeno conocido como alucinación. La detección de estas alucinaciones es fundamental para garantizar la confiabilidad y seguridad en aplicaciones críticas. Aquí es donde HalluMix emerge como una herramienta vital.

HalluMix se presenta como un benchmark innovador diseñado para detectar alucinaciones en modelos de lenguaje en escenarios reales de múltiples dominios y sin estar restringido a un tipo de tarea particular. A diferencia de los benchmarks tradicionales, que suelen centrarse en tareas específicas como preguntas y respuestas y que no capturan la complejidad del mundo real, HalluMix integra datos provenientes de diversos sectores y tipos de tareas. Su diseño incluye contextos representados por fragmentos de documentos mezclados, con contenido relevante e irrelevante, para simular de forma efectiva los escenarios reales en los que funcionan los llamados sistemas de generación aumentada por recuperación (RAG). Uno de los puntos que distingue a HalluMix es su naturaleza agnóstica a tareas, permitiendo evaluar la detección de alucinaciones no solo en preguntas y respuestas sino también en resúmenes y razonamientos mediante inferencia natural del lenguaje. Esto es clave dado que los textos generados por los LLM suelen ser extensos y complejos, abarcando múltiples oraciones o párrafos, lo cual añade dificultad al proceso de detección de contenido inconsistencias o no fundamentado.

El desarrollo de HalluMix se basa en la integración y transformación rigurosa de conjuntos de datos humanos de alta calidad. Por ejemplo, conjuntos de datos de inferencia natural del lenguaje fueron adaptados etiquetando como fieles las respuestas con "entailment" y como alucinadas las con "neutral" o "contradiction". Además, se incorporaron conjuntos de resúmenes donde se mezclaron documentos no relacionados para generar ejemplos alucinatorios, y conjuntos de preguntas y respuestas que incluyen desajustes intencionales entre contexto y respuesta, así como respuestas generadas por LLM que son plausibles, pero incorrectas. Con estas estrategias, HalluMix consiguió conformar un conjunto balanceado de 6,500 ejemplos que cubren diversas tareas y ámbitos. La inclusión de fragmentos de documentos irrelevantes posee un propósito concreto: simular las dificultades reales que enfrentan los sistemas cuando recuperan información para generar respuestas.

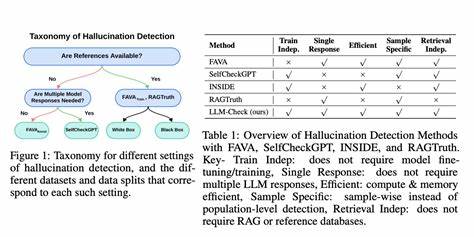

En la práctica, estos sistemas pueden acceder a bases de datos heterogéneas o documentos contaminados o no relacionados, lo que complica la verificación automática de la fidelidad del texto. Tal complejidad convierte a HalluMix en un entorno de evaluación más representativo y desafiante, fomentando la creación de modelos de detección más resistentes y generales. Uno de los grandes aportes del benchmark fue el análisis comparativo de siete sistemas líderes de detección de alucinaciones, que incluyó tecnologías de código abierto y cerrado. Destacó el sistema Quotient Detections, que mostró un desempeño equilibrado con alta precisión y recuperación sobre el conjunto completo. Otros sistemas evidenciaron fortalezas específicas dependiendo del tamaño del contexto y tipo de tarea evaluada: por ejemplo, modelos finamente ajustados para textos largos mostraron excelentes resultados en tareas de resumen, mientras que detectores basados en análisis a nivel oración exhibieron mayor eficacia en contextos más cortos, como inferencia o preguntas simples.

Esta diferenciación pone en evidencia algunos retos importantes para la comunidad de inteligencia artificial. Por un lado, la sobreajuste a subconjuntos específicos de datos puede limitar la capacidad de generalización de los detectores. Por otro lado, los métodos diseñados para manejar textos extensos pueden perder precisión en fragmentos breves y viceversa. La combinación de ambos enfoques, quizás mediante técnicas jerárquicas o ventanas deslizantes, aparece como una solución prometedora para lograr una detección robusta independiente del tamaño o formato de entrada. Los resultados y hallazgos derivados del uso de HalluMix tienen profundas implicancias para la implementación y despliegue seguro de modelos de lenguaje en la industria.

Garantizar que un modelo no produzca información falsa o sin respaldo es indispensable, especialmente en sectores sensibles como la atención médica, donde una alucinación podría poner en riesgo vidas, o en ámbitos legales y científicos donde la precisión es vital para la toma de decisiones. La disponibilidad pública del dataset HalluMix en plataformas como Hugging Face facilita la participación de investigadores y desarrolladores de todo el mundo, fomentando una comunidad colaborativa enfocada en superar los límites actuales de la detección de alucinaciones. Además, su diseño multi-dominio y multi-tarea permite explorar nuevos métodos y evaluar la adaptabilidad de diferentes enfoques ante desafíos reales. En suma, HalluMix representa un paso trascendental hacia la creación de sistemas de inteligencia artificial más confiables y transparentes. Permite enfrentar uno de los problemas más acuciantes en la interacción entre humanos y máquinas: la producción de contenido incorrecto o engañoso.