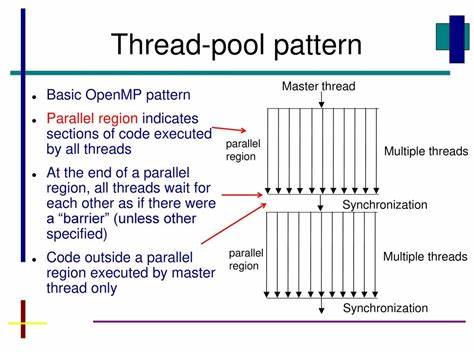

En el mundo del desarrollo de software, la paralelización de tareas es fundamental para aprovechar al máximo la capacidad de los procesadores modernos. Durante mucho tiempo, OpenMP ha sido una de las bibliotecas más populares y sencillas para implementar paralelismo en programas C++ y C, facilitando la ejecución simultánea de múltiples hilos mediante directivas de compilador. Sin embargo, con la evolución del lenguaje y la creciente demanda de control fino sobre el comportamiento de los hilos, surgen alternativas que prometen mayor flexibilidad y eficiencia. Una de ellas es la implementación de un ThreadPool basado en std::threads, y es aquí donde Copilot, la inteligencia artificial de GitHub, ha tenido un papel destacado al generar gran parte del código para sustituir OpenMP en proyectos de paralelización compleja. La decisión de reemplazar OpenMP por un ThreadPool se enmarca en la necesidad de controlar directamente la gestión de los hilos, el reparto de tareas y la sincronización entre ellos.

OpenMP ofrece una solución simple y eficiente para paralelizar bucles y secciones críticas, pero puede ser un tanto rígido y abstraer detalles importantes para optimizaciones específicas. Por otra parte, el uso de std::threads nativo de C++ permite programar de forma explícita y detallada el comportamiento del paralelismo, integrando mecanismos modernos de concurrencia y sincronización. Copilot ha contribuido al desarrollo de una clase ThreadPool recién implementada que optimiza la ejecución paralela de algoritmos intensivos en cómputo, como quicksort. Esta implementación utiliza la biblioteca estándar de threads de C++ para crear un grupo de trabajadores que están permanentemente esperando tareas. Al enviar trabajos a este grupo, las tareas se distribuyen eficientemente, evitando la sobrecarga que genera iniciar hilos en cada llamada y permitiendo un mejor aprovechamiento del hardware disponible.

Además del ThreadPool, se adaptó la lógica de paralelización del algoritmo quicksort para utilizar esta nueva infraestructura. La ventaja de este enfoque es que ofrece un paralelismo equivalente al que OpenMP provee, pero con un control mayor sobre cuándo y cómo se ejecutan las tareas. Esto se traduce en un rendimiento equiparable, manteniendo la eficiencia y además facilitando la integración con entornos que no cuentan con un compilador que soporte OpenMP o donde la dependencia de esta biblioteca sea inconveniente. Uno de los aspectos más desafiantes al implementar un ThreadPool manualmente es la correcta sincronización y gestión de los recursos compartidos entre los hilos. En esta implementación, se usaron primitivas como mutex, condition_variable, y atomic para asegurar acceso seguro a la cola de tareas y para gestionar el estado de ejecución de los trabajos.

Sin embargo, durante el proceso de revisión del código generado por Copilot, se detectaron posibles condiciones de carrera y puntos donde la notificación de hilos podía perderse, lo que podría conducir a bloqueos. Estas observaciones llevaron a refinamientos para garantizar que los trabajadores permanezcan activos hasta que se les indique explícitamente detenerse y para evitar que la llegada de tareas pase desapercibida. La gestión de la cantidad de hilos es otra consideración importante. Se estableció un límite de trabajadores para evitar saturar el sistema con demasiados hilos, lo cual puede degradar el rendimiento debido a la competencia excesiva por los recursos de CPU. Aunque se estableció un tope arbitrario, en sistemas con múltiples núcleos es fundamental adaptar el número de hilos para equilibrar la carga y mejorar la localización de datos en caché, evitando problemas de latencia y penalizaciones de rendimiento.

El proceso de integrar este ThreadPool en un proyecto existente también involucró actualizar las herramientas de construcción, como actualizar las opciones en Meson, así como las rutinas de prueba y benchmarking para validar el rendimiento y funcionamiento correcto del nuevo enfoque basado en std::threads. Además, los flujos de integración continua fueron modificados para incluir la compilación y pruebas con esta opción, garantizando que el código se mantenga robusto y eficiente en el tiempo. En términos de compatibilidad, el salto del manejo de paralelismo de OpenMP a std::threads basada en C++17 también ha sido ventajoso en ciertos contextos. El código logra utilizar características modernas del lenguaje como la deducción automática de tipos en los locks y el manejo de funciones lambda capturando variables, facilitando así la escritura de un código más limpio y mantenible. Sin embargo, algunas propuestas sugerían utilizar std::jthread para un manejo más seguro de los hilos, pero al ser esta característica introducida en C++20, se descartó para mantener compatibilidad con entornos que todavía no adoptan la versión más reciente del estándar.

Esta transición también pone de manifiesto la tendencia creciente en la industria del software hacia una mayor personalización y control en la paralelización. Mientras que soluciones como OpenMP brindan simplicidad y rapidez de implementación, para aplicaciones que requieren un rendimiento muy fino o dependen de arquitecturas especiales, el control detallado sobre la vida y comportamiento de los hilos es esencial. La intrincada colaboración entre inteligencia artificial y desarrolladores humanos en este proyecto es otro punto que merece resaltarse. La mayor parte del código para el ThreadPool y la paralelización con std::threads fue generado por Copilot. Sin embargo, el rol del programador para revisar, detectar problemas potenciales como condiciones de carrera o fallos en la señalización de hilos, y plantear soluciones refinadas fue fundamental para llegar a un producto estable y eficiente.